当前位置:网站首页>PatchEmbed代码讲解记录

PatchEmbed代码讲解记录

2022-08-09 14:57:00 【明天一定早睡早起】

PatchEmbed

代码

首先上代码。

class PatchEmbed(nn.Module):

""" Image to Patch Embedding

"""

def __init__(self, img_size=256, patch_size=8, in_chans=3, embed_dim=512):

super().__init__()

img_size = to_2tuple(img_size)

patch_size = to_2tuple(patch_size)

num_patches = (img_size[1] // patch_size[1]) * (img_size[0] // patch_size[0])

self.img_size = img_size

self.patch_size = patch_size

self.num_patches = num_patches

self.proj = nn.Conv2d(in_chans, embed_dim, kernel_size=patch_size, stride=patch_size)

def forward(self, x):

B, C, H, W = x.shape

x = self.proj(x)

return x

1. 从NLP任务中的embedding开始理解

首先从NLP任务中的embedding开始理解。我们举个例子,假设有下面的句子:“Could have done better”

我们对其中的每个单词进行编码(不用了解怎么编码),为每个单词分配一个数字(索引),假设得到编码结果为:

Could have done better

122 8 114 12

我们为每个索引分配一个n维向量,假设 n = 5 n=5 n=5并得到如下的分配结果(不需要了解是怎么分配的):

索引122对应的词向量:0.0190721 -0.04473796 0.03923314 0.04681129 -0.02183579

索引8对应的词向量:0.01421751 -0.00090249 0.01750712 -0.03774468 0.04996594

索引114对应的词向量:-0.04607415 0.04186441 0.02681447 -0.00218643 0.03448829

索引12对应的词向量:-0.03162882 0.03427991 0.0324514 0.03953638 0.01771886

上述整个embedding过程可以概括为:

- 单词编码

- 编码转词向量

实际上,单词编码是因为计算机并不能直接处理文字,只能处理离散的数字,所以我们首先要将单词通过编码转为计算机可以识别的数字。我们真正要关注的是编码转词向量的过程,这一步才是embedding的核心。可以看到,我们通过embedding把编码后的单词映射到另一个维度空间,用一个新的向量来描述这个单词。这也是理解接下来patchembed的关键。

2. 回到PatchEmbed

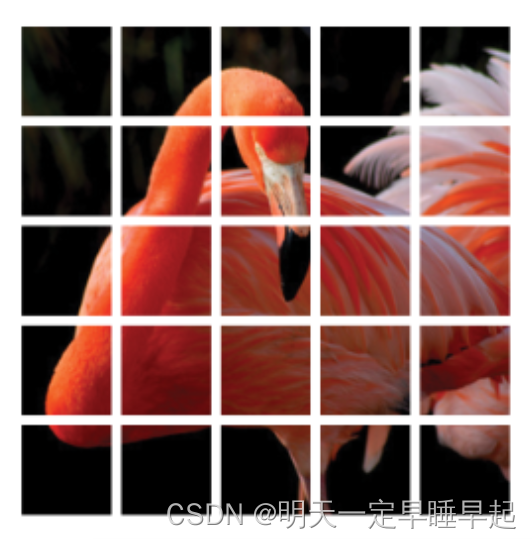

首先需要理解一下什么是patch。我们对一张图片可以划分成为多个块,每个块就称为一个patch。如图所示:

从PatchEmbed这个名字我们也能猜到它的作用,PatchEmbed实际上就是对每个patch进行embed输出一个n维向量来代表这个patch。

接下来我们从代码层面理解patchembed这一过程:

首先PatchEmbed继承自nn.Module这个类不用说,我们重点关注一下它的参数img_size, patch_size, in_chans, embed_dim,它们代表的含义分别是

- img_size:图像尺寸

- patch_size:每个patch的大小,并非将图片划为patch_size个patch

- in_chans:输入的通道数,彩色图像通常为3

- embed_dim:将每个patch编码为embed_dim维向量

以默认参数img_size=256, patch_size=8, in_chans=3, embed_dim=512为例,相当于输入一幅 256 × 256 256\times 256 256×256通道数为3的图像,每个patch的大小分别为 8 × 8 8\times 8 8×8,总patch数目就相当于 ( 256 8 ) 2 = 1024 (\frac{256}{8})^2=1024 (8256)2=1024个,相当于把图像分为1024个patch,每个patch编码为一个512维的向量。

如果不需要深入理解代码是如何实现的,那看到上面知道代码是做什么的就可以了。

接下来我们逐行理解代码是如何实现这个过程的(理解可能有误,如有误请指出)

patchembed代码讲解

边栏推荐

猜你喜欢

随机推荐

pyspark jieba 集群模型 对文本进行切词

如何选择可靠的亚马逊代运营

hugging face tutorial - Chinese translation - model summary

《身体是革命的本钱,该注意时还是要注意!》

【深度学习】梳理范数与正则化(二)

GoogLeNet

【深度学习】介绍六大类损失函数(九)

地铁预约Postman脚本使用

链游是什么意思 链游和游戏的区别是什么

NoUniqueBeanDefinitionException和JSON乱码处理出现异常

【Leetcode】433. 最小基因变化

理解泛型之得到泛型类型

pyspark explode时增加序号

crontab失效怎么解决

js总结,基础篇

NLP-阅读理解任务学习总结概述

Server运维:设置.htaccess按IP和UA禁止访问

stream去重相同属性对象

YOLOV1详解

【剑指 Offer II 091. 粉刷房子】