当前位置:网站首页>【VQA survey】视觉问答中的语言学问题

【VQA survey】视觉问答中的语言学问题

2022-08-09 11:15:00 【临淮郡人】

这里先放一个比较全的reading list,可以方便浏览,而不用在survey中一个一个找了:

https://github.com/jokieleung/awesome-visual-question-answering

1.前言

看文章,也有所谓的2、8定律,顶会之中也有那么80%的文章,其实并没有下文,或者没有人关注。集中精力发现

关注那20%的文章,是很重要的。

回想起来,很多领域都是研究了重要的问题,因此才出现的.比如,为什么分为判别式模型和生成式模型?因为实际上是对问题的建模不同,一个是对联合概率建模,另一个是直接建立“问题和目标的”映射,

为什么分为有监督和无监督?实际上是对不同问题的研究,即有数据集标注,和无数据集标注,希望依据某种标准发现数据集的结构。

为什么有生成问题?因为模型需要自主生成的能力,而并不是对我们给定的数据进行判别。

2.介绍

关于VQA任务,我们可以观察到CV community对其建设做出了非常大的贡献,具体体现在CVPR,CVPR,ECCV三大cv顶会关于VQA任务的探讨非常多,相应的,在NLP领域的顶会ACL和EMNLP中,就相对有限。其它在ICLR和NIPS两个会中,也有相当多的论文探讨VQA问题。

视觉问答,相比于纯粹的问答任务,需要将理解的对象变为图片,同时也必须对问题进行理解。在这里,其实对于“语言处理”的要求并不是特别高,主要原因在于,这里的语句形式是相对单调的,而且问句的句子和篇章比起来,一句话而已,不是很长。但是同时,问题就像触发器一样,完全引导了整个模型对于问题解决的方向,实际上非常重要。因此,本文尝试探讨一些VQA任务中的Linguistic issue。

Image Grounding是利用指定描述的语句进行标定图片中所显示的物体。可见,grounding meaning representations into the visual context是一个非常重要的问题。- 人们具备将语言描述对应到图片的zero-shot能力:zebra-“horse & stripes”.人们通过解释,可以在看到斑马的时候认识出斑马;

我认为,一个VQA模型,必须具备类似“多问几次问题”的能力!即active-learning;

此外,为了回答一个复杂的问题,系统必须handle reasoning abilities and deal with language ambiguity(歧义性), vagueness(模糊), negation(否定) and pragmatics(语用)。当然,貌似现在的VQA数据集,问题是简单的,因为系统远远没有达到,将二者很好结合的情况。

可见,如果VQA系统能够真的理解好图像中的物体关系,理解文字信息,那么其实他要求很高:

a list of main linguistic phenomena(ambiguity,vagueness, negation) and skills (reasoning推理 and pragmatic‐based interpretation指代消解) that we believe a multimodal 多模态系统。

VQA has been treated both as a downstream task and as a pre‐training task to effectively encode multimodal input and trasfer it to other multimodal tasks.事实上,VQA数据集是一个包含各种问题的数据集,这样就要求模型同时具备各种能力——显然,这是非常贪心的想法,因为很多问题完全可以被单独作为一个子问题,比如计数、指代、关系判断、目标识别的grounding,而不是作为如此笼统的一个大任务解决。

总的来说,大家也意识到了VQA任务的多样性,一个是内容的多样性,如visual部分的多样性,比如有不同形态的图片,医学影像、图标信息等等;如问题的多样性,不同的问题,以及同一个内核的问题,进行不同问法的情况等等;第二个是对VQA能力上要求的多样性,如不同问题其实背后蕴含的是,对图像不同角度的理解,如是问属性、问关系还是其它,诸如role labelling and spatial relations。

因此,关注VQA之类的任务,还是要关注到:

- 任务所需要的能力是什么,这对应着更为细致的研究要点;

- 模型的设计,虽然可能有的是在水模型,但是他们的设计其实关注到的要点也不同。

- 数据集:数据集的偏好,正是容易训练出不同偏好的数据集,也正是适合研究不同的问题。

因此,针对于VQA任务:

- 从模型来看,最初的模型是很简单的:他们都是遵循某种范式,先获得多模态的表示,对两种表示进行简单操作,进行融合、对齐等操作。但是现在似乎根据任务的能力,有不同的针对性的设计?,似乎哦;

- 从任务的能力要求看,这对应的就是数据集的评判指标。从一开始VQA任务,简单的用正确率作为评判指标,到之后,对不同种类问题的回答正确率评价,对鲁棒性评价、consistency, plausibility and grounding等等指标;另一方面,对于任务的数据模态有所丰富,比如“关注图片中的文字信息”、“医学影像”的QA,“需要智能体与环境交互的QA”,“”阅读图表信息的QA“等等。

- 从数据集的角度看:开始的数据集是大杂烩,一方面有所谓的数据偏置的问题,因此从VQA到了VQA2.0。另一方面有研究问题不明的问题,对应的解决是,把问题再次细分了,并衍生了许多对标注更为细致的数据集,他们实际上要求我们分析模型的能力,比如关注模型的视觉推理和组合能力。数据集如visual Genome,visual 7W,GQA等。此外,还有一些更为严苛的评价数据集,如for VQA and GQA,new out‐of‐domain test sets have been proposed to allow a more reliable evaluation of the models。

以上来自Linguistic issues behind visual question

answering的2.1部分,这部分值得好好看看!

2.4部分讲述了从lab迈向real life的需要面对的问题,无论是从视觉还是从语言方面:

首先是模型的需要解决的OOD问题,始终是各种任务中都值得研究的地方:

A crucial challenge all these models have to face is the ability to generalize the knowledge learned to unseen data, which can be achieved only if the model is able to compositionally build the multimodal representations, a must for any model of human intelligence。

再就是语言学中的问题:language ambiguities(语言歧义), pragmatic aspects(语用现象) and context dependence(上下文依赖),negation(否定), entailment(语言蕴含), mutual exclusivity(互斥?) and all the reasoning skills(推理)

我觉得这篇综述其实说的也是挺中肯的,因为实际上我们不一定是说提出一个VQA的通用的数据集去研究某些问题,在语言中我们很多的歧义之类的的问题,或者不明确的问题,都是可以通过,互动、常识推理或者说多模态的信息查看,来消解掉这些问题。因此相对于语言学中的一些难题,也是需要值得认真的思考的。

3.具体问题

3.1 Reasoning

这个是所谓的因果推理嘛??

关于VQA问题的reasoning研究,是两方面的,一方面是对模型的推理步骤进行建模:by controlling the reasoning steps that a system has to perform to answer VQA questions;另一方面是对于数据集的建设,来检验模型的能力。

一些数据集的建设,也使得人们将模型中的non-reasoning问题,关注到了reasoning问题之中。

从视觉角度看:

其中non-relational的问题,其实关注的是region of the image which ‘contains’ the object;

而relational的问题,其实关注的是multiple objects in the visual scene,既要关注到多个区域中物体的属性,也要关注到他们之中的关系。

从语言角度看:

If one views language from a denotational semantic

perspective, it becomes clear that the move from non‐relational to relational skills is also crucial to master language phenomena of increasing complexity, for which yet another step is necessary, namely to deal with questions involving relations between sets of objects.

Recently, the reasoning skills of multimodal models have been tested by means of either probing tasks involving high‐level reasoning or grounded textual entailment,how they perform on the entailment task

This reveals that a full understanding of complex language phenomena is an ability required for models to deal with real‐life multimodal questions.

3.2 ambiguity

语言本身在句法上确实有歧义,但是我们通过结合图片的多模态,可以实现消解歧义:

如以下句子:

Put the blue pyramid on the block in the box,这句话从句法上看,到底是是把blue pyramid on the block放到box里,还是blue pyramid放到box中的block上面?但是我们看图片分析一下,就可以排除一些不合适的“介词附属关系”,得到结果。又比如,sam approach the chair with bag,我们可以知道,chair不会with bag,是sam with bag。其它的歧义,还包括the semantic and discourse level的歧义,比如一些不明确的首部指代(anaphora),以及“比喻”识别metaphors and proposed the task of visually‐grounded metaphor detection。其它,Syntax has been shown to be useful also to disambiguate referring expressions and properly locate (ground), in an image, the object to which the expression refers。

- Referring Expression指的是,一些名词或者代词等,指的是具体的事物,而不是一类事物。

举例:

1.“蛋糕是食物的一个品类。”这句话中出现了三个名词指代,蛋糕、食物、品类,但是这三个名词指代都不是指具体的事物,而是一个笼统的说法,所以这三个词语都不是指称表达。

2.“这块蛋糕是一块奶油蛋糕。”这里的“这块蛋糕”指代具体的事物,便是指称表达。

3.3 vagueness

这个并不是指语义的模糊性,而是指,一些语言现象的上下文相关性,使得词语的具体含义会发生变化。

For example, the applicability(适用性) of words like most or big in a certain context depends on the properties of the set of objects that are relevant for their interpretation.Moreover, their interpretation can be borderline(暧昧不清的) and therefore differ across human speakers。也就是说,一些词语之间的含义可能过于宽泛,在不同人的表达之下,意思是不同的。

比如understand quantifiers (at least one) and gradable adjectives(比较级,narrower)都有这种意思。

understanding how word meaning changes depending on the context in which the word is uttered,这个是什么意思?

3.4 negation

否定问题,How many blocks are not in the box。其实我觉得可以探讨,比如考察not的问句对应的attention map?

More recently, some interest has been paid in the computer vision community to logical skills of VQA models, particularly negation.前文其实列举了几篇文章,关于否定现象的探讨,但是说最近似乎对图像推理能力有了更高的要求。

Greco et al. (2021) show that multimodal universal encoders have difficulty in interpreting negatively answered questions.

3.5 语用(Pragmatics)

语用似乎值得就是语言的灵活运用方面。

use referring expressions that are pragmatically

discriminative based on the context in which they are used; for example, (指称表达)。“the big red block” if

there are other blocks and none else are both big and red,这就是语言的灵活性,因为并没有真正的big red block,那么它具有其他含义。个人认为,这种需要“active learning”,但是机器需要基础的,理解、推理、提问能力才行。

4.未来的观察

对于VQA任务,其实还有很远的路要走。现在基础的很多问题都尚待解决,更不用说以上提到的,需要深刻领会到图文信息的难点问题的解决了。

事实上,我们也可以关注到,如果让机器人有了初步的能力,并能进行active learning,有意义的问答对话,那么机器获得数据的能力与学习能力,有望进一步增强。

- When opening the box of interaction, the next challenge that pops up immediately is question generation.

5.一些语言的例子

黄瓜一般是绿的却叫做黄瓜;

肉夹馍是肉夹于馍;

我晒太阳=我被太阳晒;

我晒被子=我晒被子

坐电梯!=坐在电梯里

边栏推荐

猜你喜欢

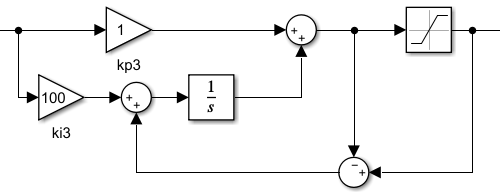

抗积分饱和 PID代码实现,matlab仿真实现

sublime记录

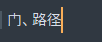

剖析STM32F103时钟系统

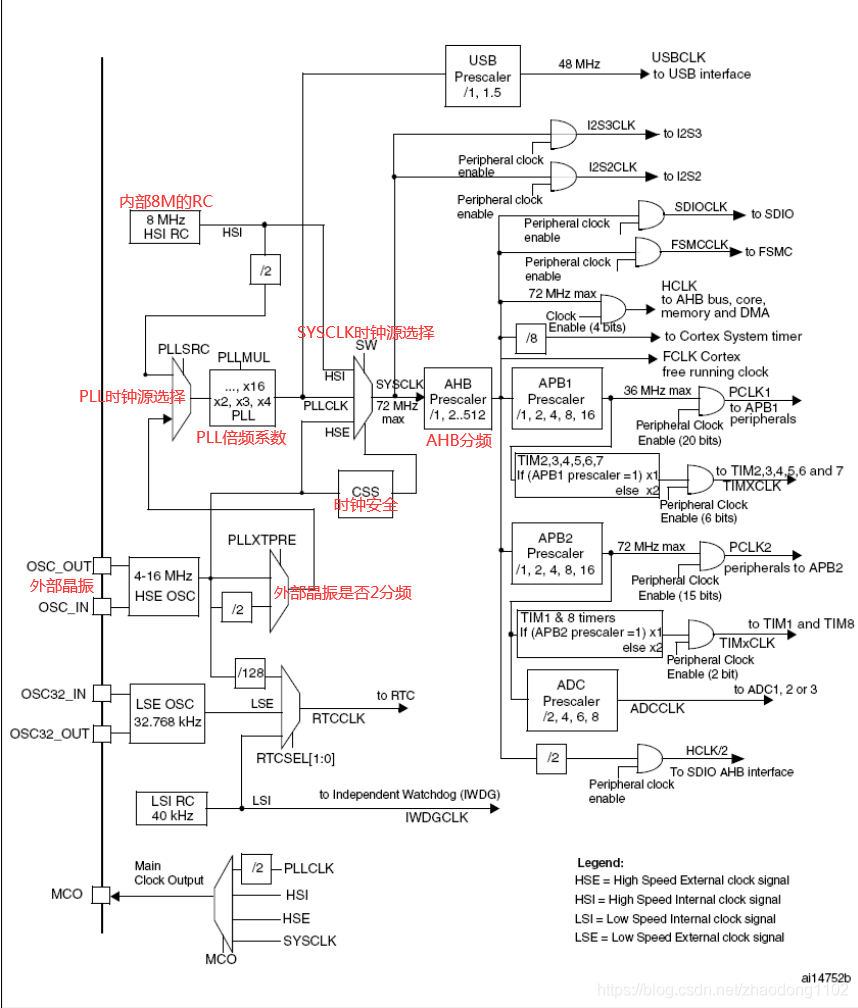

x86 Exception Handling and Interrupt Mechanism (1) Overview of the source and handling of interrupts

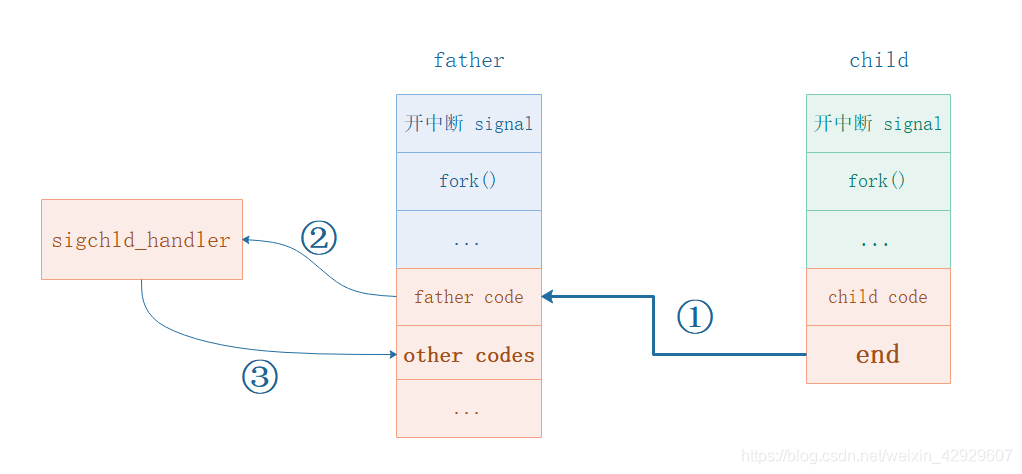

信号量SIGCHLD的使用,如何让父进程得知子进程执行结束,如何让父进程区分多个子进程的结束

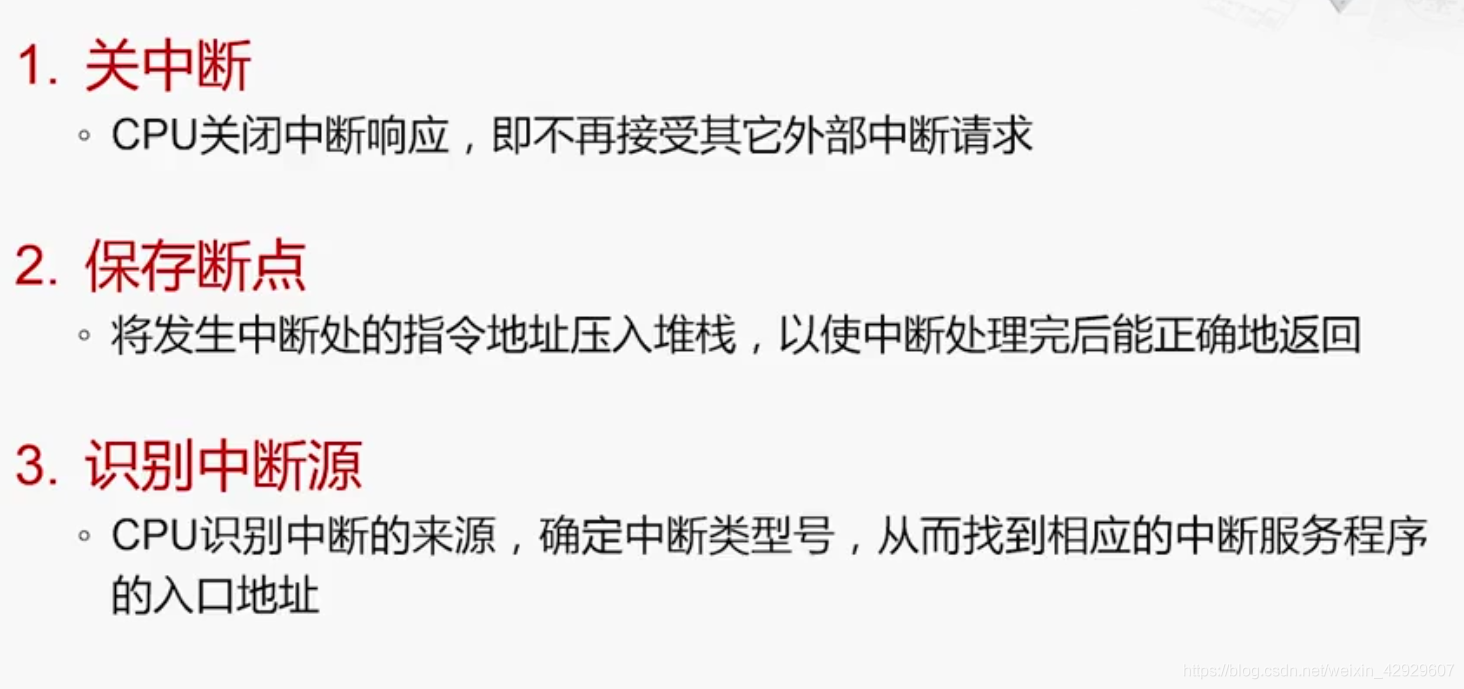

x86 Exception Handling and Interrupt Mechanism (3) Interrupt Handling Process

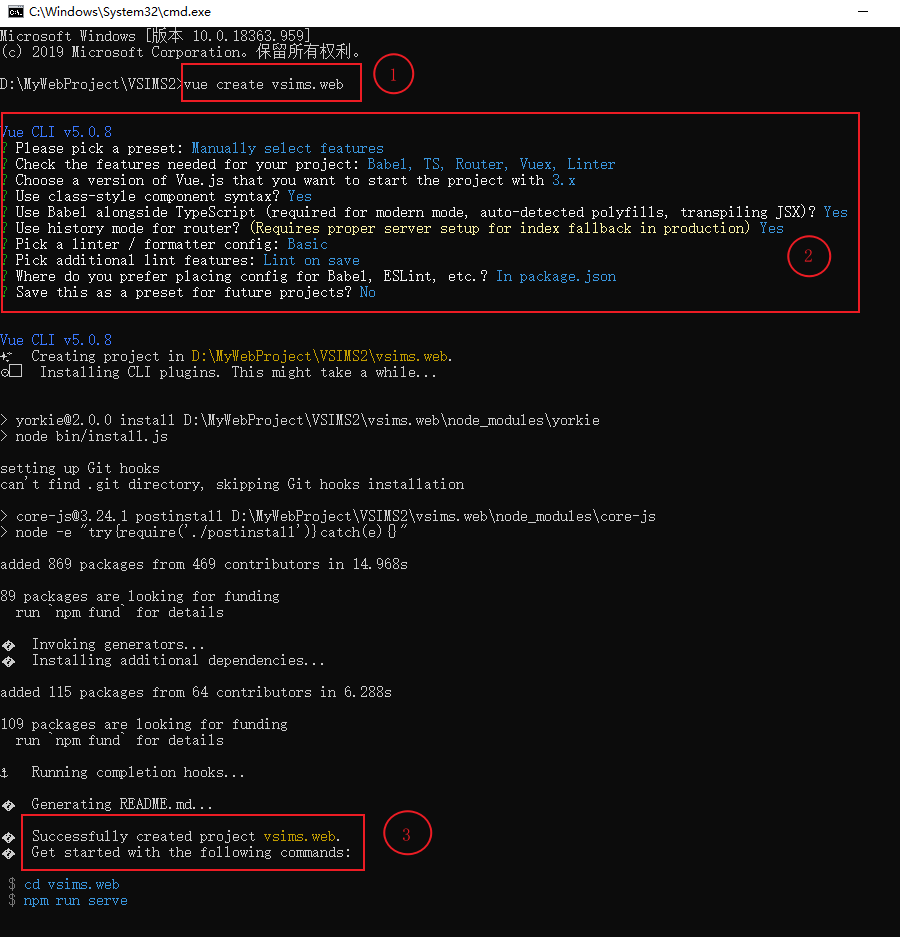

Antdv+Asp.net WebApi开发学生信息管理系统(一)

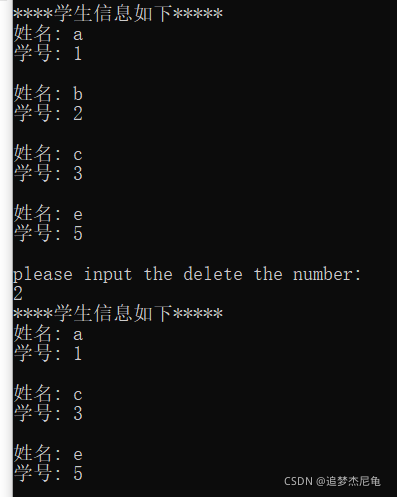

链表基本操作(详解)

matlab图像分割,从基因芯片荧光图像中提取阴性点(弱)和阳性点(强)

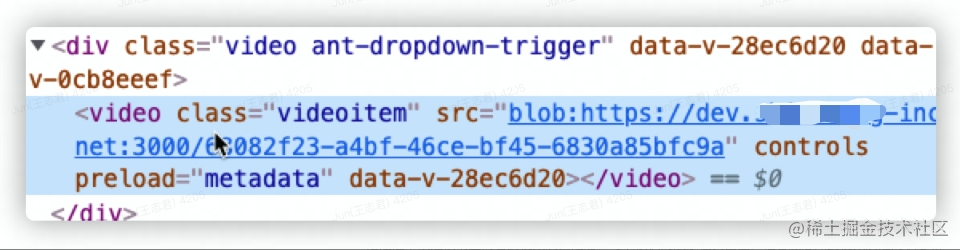

富媒体在客服IM消息通信中的秒发实践

随机推荐

PTA习题 三角形判断

使用.NET简单实现一个Redis的高性能克隆版(四、五)

Julia资料收集

最长回文子串

双向链表的各种操作

Oracle Database Architecture

Chinese valentine's day?Programmers don't exist

PAT1007

PAT1010

PAT1002

redis的线程模型

激光条纹中心提取——灰度重心法

Qt获取EXE可执行文件的上一级目录下的文件

focusablejs

PAT1014 未解决

MySQL的MVVC多版本并发控制机制

bat文件(批处理文件)运行时一闪而过解决方法

激光条纹中心提取——Steger

父类的main方法可以被继承么?有什么特殊?

无刷无霍尔BLCD电机控制