当前位置:网站首页>抱抱脸(hugging face)教程-中文翻译-使用 AutoClass 加载预训练的实例

抱抱脸(hugging face)教程-中文翻译-使用 AutoClass 加载预训练的实例

2022-08-09 14:56:00 【wwlsm_zql】

使用 AutoClass 加载预训练的实例

由于有这么多不同的 Transformer 体系结构,为您的 checkpoint 创建一个 Transformer 体系结构是一项挑战。作为 Transformers core 哲学的一部分,AutoClass 可以从给定的checkout自动推断和加载正确的体系结构,从而使库容易、简单和灵活地使用。来自 pretrained method 的他可以让你快速为任何架构装载一个预先训练好的模型,这样你就不必投入时间和资源从头开始训练一个模型。这种类型的checkout不可知代码意味着如果你的代码适用于一个checkout,那么它将适用于另一个checkout——只要它是为相似的任务而训练的——即使体系结构不同。

请记住,体系结构是指模型的骨架,而checkout是给定体系结构的权重。例如,BERT 是一种架构,而 BERT-base-uncased 是一种checkout。模型是一个通用术语,它可以表示架构,也可以表示checkout。

在本教程中,学习:

- 加载一个预先训练的标记器

- 加载一个经过训练的特征提取器

- 加载预先训练过的处理器

- 加载一个预先训练好的模型

AutoTokenizer

几乎每个 NLP 任务都是从一个标记器开始的。标记器将您的输入转换为模型可以处理的格式。

用 AutoTokenizer.from_pretrained()加载一个 tokenizer:

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased")

然后像下面这样标记你的输入:

sequence = "In a hole in the ground there lived a hobbit."print(tokenizer(sequence))

{

'input_ids': [101, 1999, 1037, 4920, 1999, 1996, 2598, 2045, 2973, 1037, 7570, 10322, 4183, 1012, 102],

'token_type_ids': [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0],

'attention_mask': [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1]}

自动功能提取器

对于音频和视觉任务,特征提取器将音频信号或图像处理为正确的输入格式。

使用 AutoFeatureExtractor.from_pretrained加载一个特性提取器:

from transformers import AutoFeatureExtractor

feature_extractor = AutoFeatureExtractor.from_pretrained(

... "ehcalabres/wav2vec2-lg-xlsr-en-speech-emotion-recognition"... )

自动处理器

多通道任务需要一个结合了两种预处理工具的处理器。例如,layoutlmv2模型需要一个特性提取器来处理图像,还需要一个标记器来处理文本; 处理器将两者结合起来。

用 AutoProcessor.from_pretrained加载处理器:

from transformers import AutoProcessor

processor = AutoProcessor.from_pretrained("microsoft/layoutlmv2-base-uncased")

AutoModel

Pytorch

最后,AutoModelFor 类允许您为给定任务加载预训练的模型(参见此处可用任务的完整列表)。例如,使用 AutoModelForSequenceClassification.from_pretrained加载序列分类模型

from transformers import AutoModelForSequenceClassification

轻松地重用相同的checkout来为不同的任务加载架构:

from transformers import AutoModelForTokenClassification

model = AutoModelForTokenClassification.from_pretrained("distilbert-base-uncased")

通常,我们建议使用 AutoTokenizer 类和 AutoModelFor 类来加载预训练过的模型实例。这将确保您每次都加载正确的体系结构。在下一个教程中,学习如何使用新加载的标记器、特性提取器和处理器对数据集进行预处理以进行微调。

Tensorflow

最后,tfautomatodelfor 类允许您为给定任务加载预训练的模型(参见此处获得可用任务的完整列表)。例如,使用 tfautomatodelforsequenceclassification.

from_pretrained加载序列分类模型

from transformers import TFAutoModelForSequenceClassification

model = TFAutoModelForSequenceClassification.from_pretrained("distilbert-base-uncased")

轻松地重用相同的checkout来为不同的任务加载架构:

from transformers import TFAutoModelForTokenClassification

model = TFAutoModelForTokenClassification.from_pretrained("distilbert-base-uncased")

通常,我们建议使用 AutoTokenizer 类和 TFAutoModelFor 类来加载预训练过的模型实例。这将确保您每次都加载正确的体系结构。在下一个教程中,学习如何使用新加载的标记器、特性提取器和处理器对数据集进行预处理以进行微调。

本文是抱抱脸教程翻译,仅学习记录

边栏推荐

猜你喜欢

随机推荐

spark shuffle

Use tensorboard remotely on the server

MouStart指纹浏览器怎么防关联

C写菜单指令的快捷方法

在服务器上远程使用tensorboard

对导入的 excel 的时间的处理 将excel表中的时间,转成 标准的时间

bin document read and write

PHP开源 | ysKit(ys工具包) - 微型Web框架

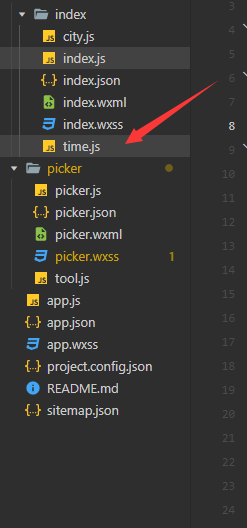

微信小程序转盘demo

NetCore 5.0连接MySql

路由的懒加载与接口的封装

从数组到js基础结束

《平凡的世界》(书评)

LNK1123: Failed during transition to COFF: invalid or corrupt file

抱抱脸(hugging face)教程-中文翻译-翻译任务(translating)

排序方法(希尔、快速、堆)

Common compilation problems

内存泄露检测工具VLD(Visual Leak Detector)使用说明

常见编译问题

关于亚马逊的坑你知道几个?