当前位置:网站首页>spark集群环境搭建

spark集群环境搭建

2022-08-08 15:58:00 【星哥玩云】

1.安装jdk

安装环境:CentOS-7.0.1708 安装方式:源码安装 软件:jdk-6u45-linux-x64.bin 下载地址:http://www.Oracle.com/technetwork/Java/javase/downloads/java-archive-downloads-javase6-419409.html

第一步:更该权限

chmod 775 jdk-6u45-linux-x64.bin

第二步:执行jdk安装

./jdk-6u45-linux-x64.bin

第三步:配置环境变量

环境变量的配置分为几种方式,根据自己的选择配置:

方式一:vi /etc/profile文件中配置JAVA_HOME以及PATH和CLASS_PATH

因为这样的设置将对所有用户的shell都生效,对系统安全会产生影响。

就是在这个文件的最后加上:

export JAVA_HOME=/usr/local/softWare/jdk1.6.0_45

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_HOME/bin

执行 source /etc/profile 是配置立即生效

方式二:

修改.bashrc文件来配置环境变量:

#vi .bashrc

export JAVA_HOME=/usr/local/softWare/java/jdk1.6.0_45

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_HOME/bin

配置完成之后,使用logout命令退出,然后重新登入使其生效.

验证一下是否安装成功,使用java -version查看一下。

2.安装scala 下载路径: https://downloads.lightbend.com/scala/2.12.8/scala-2.12.8.tgz scala-2.12.8.tgz 把下载包上传解压 tar -zxvf scala-2.12.8.tgz rm -rf scala-2.12.8.tgz 配置环境变量 vi /etc/profile export SCALA_HOME=/usr/local/scala-2.12.8 export PATH=$PATH:$JAVA_HOME/bin:$SCALA_HOME/bin 复制到其他节点: scp -r scala-2.12.8 192.168.0.109:/usr/local/ scp -r scala-2.12.8 192.168.0.110:/usr/local/ scp /etc/profile 192.168.0.109:/etc/ scp /etc/profile 192.168.0.110:/etc/ 使环境变量生效:source /etc/profile 验证:scala -version

3.ssh 免密码登录 参考https://blog.51cto.com/13001751/2487972

4.安装Hadoop 参考https://blog.51cto.com/13001751/2487972

5.安装spark 把下载包上传解压 cd /usr/local/ tar -zxvf spark-2.4.5-bin-hadoop2.7.tgz cd /usr/local/spark-2.4.5-bin-hadoop2.7/conf/ #进入spark配置目录 mv spark-env.sh.template spark-env.sh #从配置模板复制 vi spark-env.sh #添加配置内容 export SPARK_HOME=/usr/local/spark-2.4.5-bin-hadoop2.7 export SCALA_HOME=/usr/local/scala-2.12.8 export JAVA_HOME=/usr/local/jdk1.8.0_191 export HADOOP_HOME=/usr/local/hadoop-2.7.7 export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$SCALA_HOME/bin export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export YARN_CONF_DIR=$HADOOP_HOME/etc/hadoop export SPARK_MASTER_IP=spark1 SPARK_LOCAL_DIRS=/usr/local/spark-2.4.5-bin-hadoop2.7 SPARK_DRIVER_MEMORY=1G export SPARK_LIBARY_PATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$HADOOP_HOME/lib/native、 vi slaves spark2 spark3 scp -r /usr/local/spark-2.4.5-bin-hadoop2.7 [email protected]:/usr/local/ scp -r /usr/local/spark-2.4.5-bin-hadoop2.7 [email protected]:/usr/local/ ./sbin/start-all.sh(不可直接start-all.sh,这个命令是hadoop的)

边栏推荐

猜你喜欢

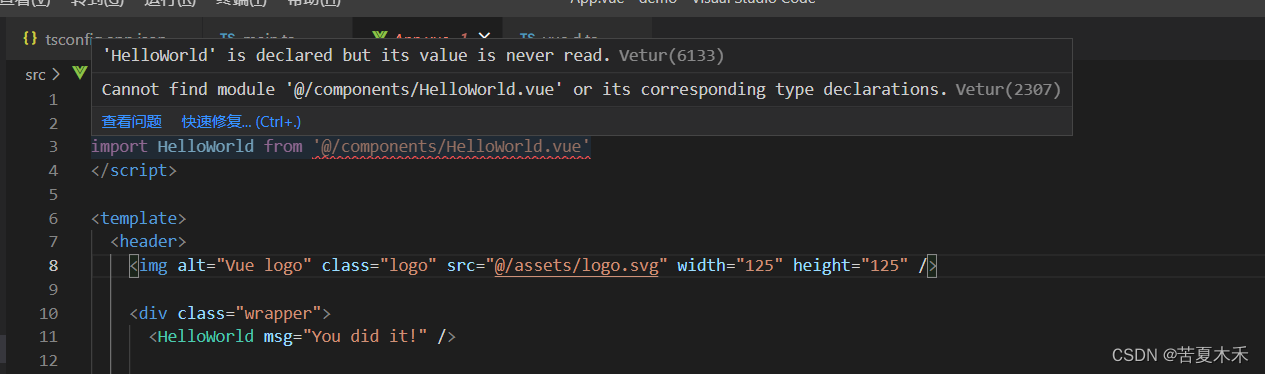

‘xxxx‘ is declared but its value is never read.Vetur(6133)

Iptables防火墙iprange模块扩展匹配规则

科创人·优锘科技COO孙岗:错误问题找不到正确答案,求索万物可视的大美未来

程序发生run time error原因及解决方案

Smobiler的复杂控件的由来与创造

成员变量和局部变量的区别?

【kali-权限提升】(4.2.5)社会工程学工具包:PowerShell攻击向量(防报毒)

Elegantly detect and update web applications in real time

如何选择ui设计机构

pytorch安装过程中出现torch.cuda.isavailable()=False问题

随机推荐

[Unity entry plan] Unity instance - how to protect data members through encapsulation in C#

leetcode/number of palindromic substrings

bzoj3693 圆桌会议 hall定理+线段树

18、学习MySQL ALTER命令

返回分页查询分类并统计多对多关系表中各分类下的应用数量

表实时同步,没有etl 可以用这个吗,从mysql到mysql

线程本地存储 ThreadLocal

NFT质押挖矿分红系统开发逻辑功能介绍

bzoj3262 Flowers bloom on Mo

带你玩转“超大杯”ECS特性及实验踩坑【华为云至简致远】

Iptables防火墙iprange模块扩展匹配规则

华为云分布式缓存服务Redis开通及使用规划教程【华为云至简致远】

在通达信开户安全不呢

GPT3中文自动生成小说「谷歌小发猫写作」

如何制作网页

Introduction to Power BI

Elegantly detect and update web applications in real time

跟我一起来学弹性云服务器ECS【华为云至简致远】

web自动化无头模式

看到这个应用上下线方式,不禁感叹:优雅,太优雅了!