当前位置:网站首页>网页分析和一些基础题目

网页分析和一些基础题目

2022-08-10 15:42:00 【华为云】

本次练习的是<有关网页分析和一些基础题目>,想要学习Python和巩固基础的可以现在打开来一起学习吧。

文章目录

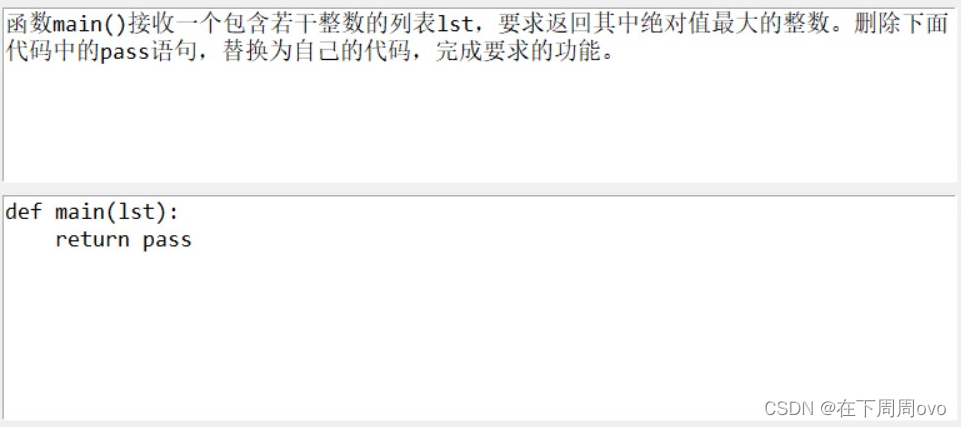

题目一

题目要求

我的解析

本道题目难度较小主要考察了内置函数的基本使用方法

我的答案

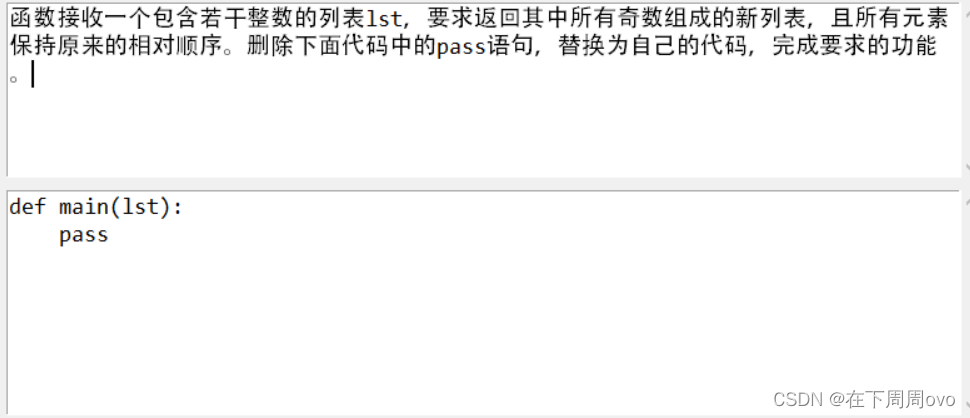

题目二

我的解析

本题难度较小,主要考察列表,匿名函数,列表推导式的基本使用方法。

我的答案

------>>】

------>> 【】

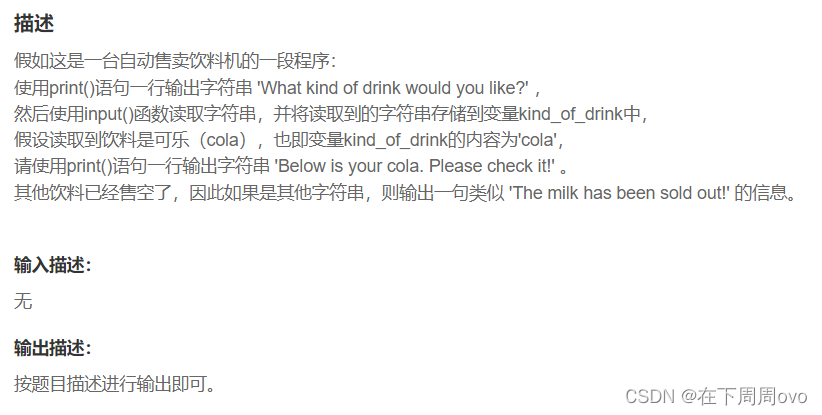

题目三

题目要求

我的解析

本题难度很小主要考察的是if-else语句和格式化输出

我的答案

题目四

写在前面

写本道题目之前需要掌握以下知识点哟,不清楚的可以翻看我之前的博客或者是网上查找相应的视频来回顾

- 知识点一urlib库的使用中请求对象的定制使用urllib来获取源码

- 知识点二re模块的基本使用方法

- 知识点三json模块的基本使用方法

- 知识点四正则匹配(用于对网页想要信息的提取和不想要信息的剔除)

- 知识点五文件的基本使用方法

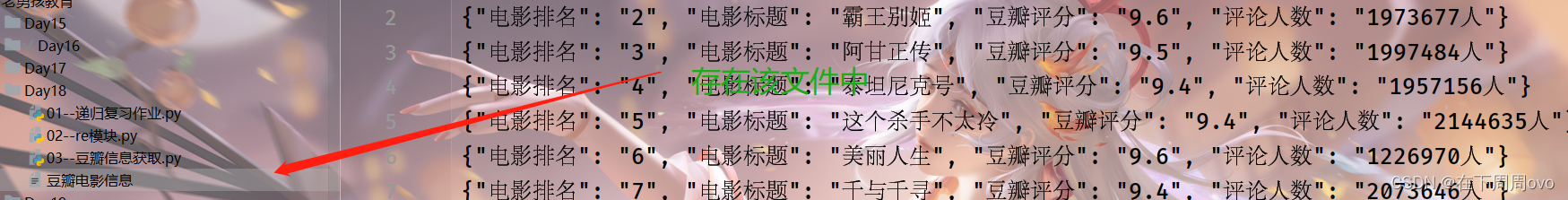

题目要求

获取某瓣电影排名前十页电影的<"电影排名" "电影标题" "豆瓣评分"和"评论人数">并且将爬取下来的数据放到名为<豆瓣电影信息>的文件中

我的答案

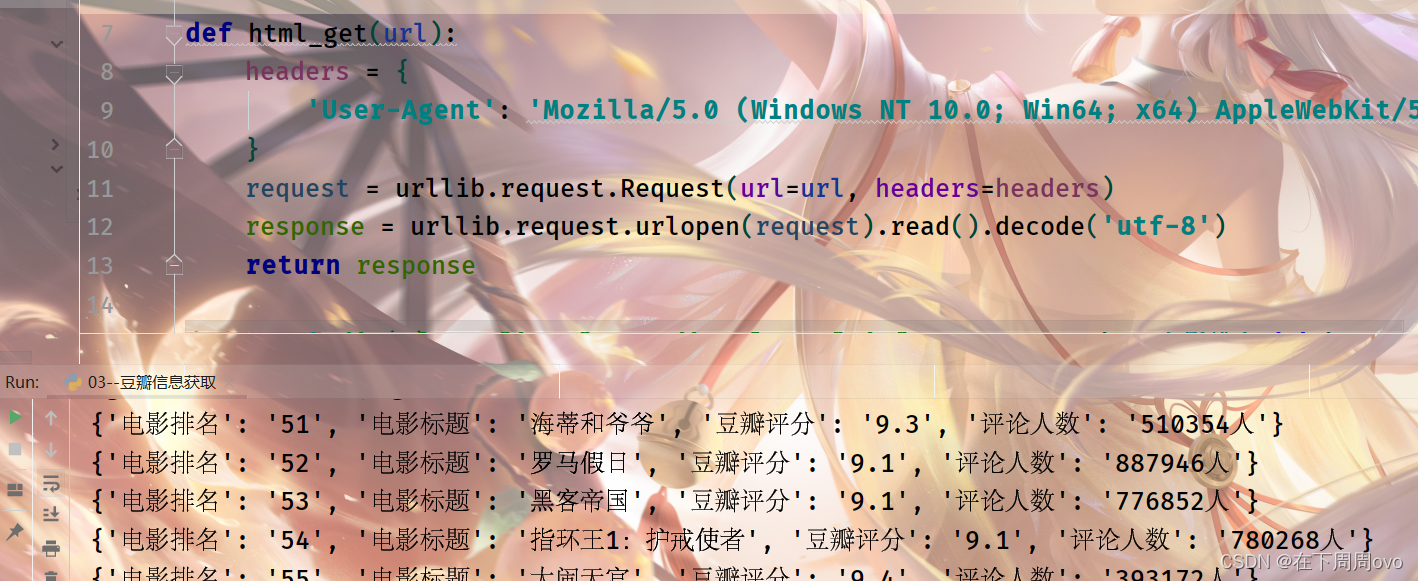

输出结果:

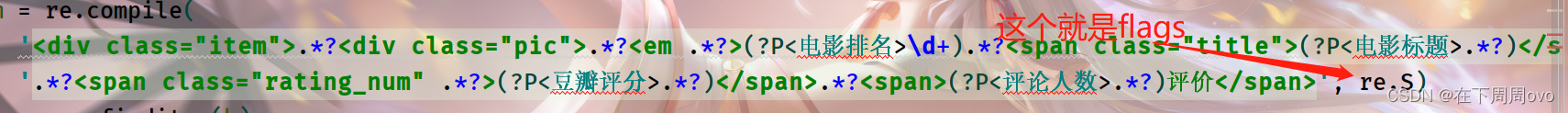

知识点:

flags有很多可选值:

- re.I(IGNORECASE)忽略大小写,括号内是完整的写法

- re.M(MULTILINE)多行模式,改变^和$的行为

- re.S(DOTALL)点可以匹配任意字符,包括换行符

- re.L(LOCALE)做本地化识别的匹配,表示特殊字符集 \w, \W, \b, \B, \s, \S 依赖于当前环境,不推荐使用

- re.U(UNICODE) 使用\w \W \s \S \d \D使用取决于unicode定义的字符属性。在python3中默认使用该flag

- re.X(VERBOSE)冗长模式,该模式下pattern字符串可以是多行的,忽略空白字符,并可以添加注释

我的解析:

html_get(url)函数:

- 作用:

获取豆瓣对应网址的网页源码

- 参数:

要获取信息的网址

- 返回值:

豆瓣对应网址的网页源码

page_info(h)函数

- 作用:

该函数的作用是匹配获取到的网页源码中的"电影排名" "电影标题" "豆瓣评分"和"评论人数"

- 参数:

对应网址的网页源码

- 返回值:

一个生成器函数

main(num)函数

- 作用:

顾名思义该函数是程序中的主函数,调用它获取对应页数的<"电影排名" "电影标题" "豆瓣评分"和"评论人数">并且将爬取下来的数据放到名为<豆瓣电影信息>的文件中

- 参数:

num = 0 则表示第一页,num = 25则表示第二页,num = 50则表示第三页,以此类推,因为每页有25部电影。

- 返回值:

将爬取下来的数据放到名为<豆瓣电影信息>的文件中

边栏推荐

猜你喜欢

随机推荐

MySQL批量更新与批量更新多条记录的不同值实现方法

LeetCode-876. Middle of the Linked List

超越神经缩放法则:通过数据剪枝

数据类型与整型存储

JVM学习——2——内存加载过程(类加载器)

5G NR MIB详解

Reids 源码导读

智为链接,慧享生活,荣耀智慧服务,只为 “懂” 你

5G NR MIB Detailed Explanation

匿名函数和全部内置函数详细认识(下篇)

秒杀项目收获

cmake记录

spark面试常问问题

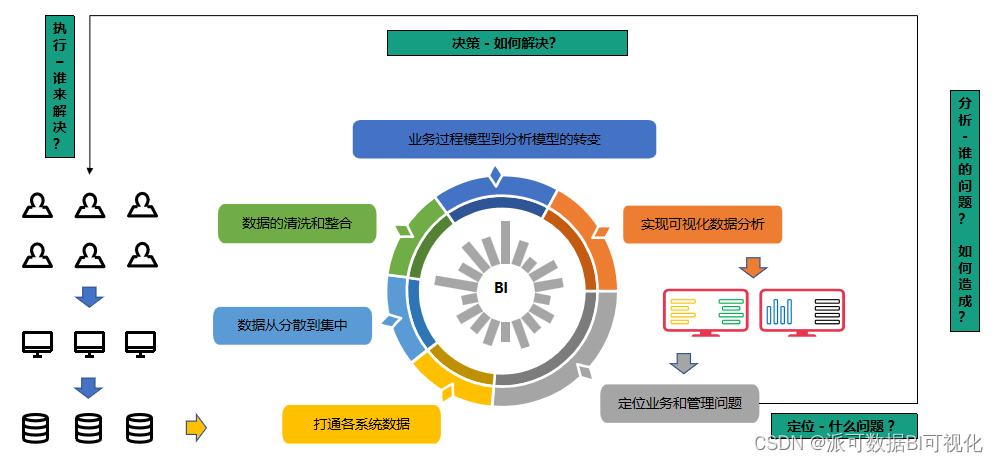

8月Meetup | “数据调度+分析引擎”解锁企业数字化转型之路

openpyxl绘制堆叠图

关于Web渗透测试需要知道的一切:完整指南

Oracle database backup DMP file is too big, what method can be split into multiple DMP when backup?

Community News——Congratulations to Dolphin Scheduling China User Group for 9 new "Community Administrators"

快速申请代码签名证书方法

商业版SSL证书