当前位置:网站首页>Seq2Seq论文阅读笔记

Seq2Seq论文阅读笔记

2022-08-09 22:36:00 【孜然星星星星】

- 算法介绍

- RNN编码器-解码器

- 两个递归神经网络

- 将一串符号编码成一个固定长度(不可变)的向量表示

- 将上得表示解码成另一串符号(可变)

- 即学习将可变序列编码为固定长度的向量表示,并将给定的固定长度的向量表示解码为可变长度的序列

- 联合训练->最大化给定原序列的目标序列的条件概率能力

- 使用复杂的隐藏单元->提高记忆容量和训练的便利性

- 通过训练预测序列中的下一个符号来学习一个序列的概率分布

- 通过在每个时间步长进行迭代采样来对新序列进行采样

- 使用RNN算法,一般为LSTM

- LSTM

- 接收:序列的某一位输入+上一轮的隐藏状态

- 产生:当前轮的输出+当前轮的隐藏状态

- LSTM

- 隐藏层

- ![[Y$1MTL4QXNTE5IFLR[[NIYX.jpg]]

- 当复位门->0时,隐藏状态被强制忽略之前的隐藏状态,并以当前输入复位

- 更新们控制前一个隐藏状态的信息有多少会延续到当前隐藏状态

- 应用举例:

- 生成一个给定输入的目标序列

- 用来对给定的一对输入和输出序列进行评分

- 两个递归神经网络

- RNN编码器-解码器

- 总结与展望

- 提出了一种新的神经网络架构,称为RNN编码器 - 解码器,它能够学习从任意长度的序列到另一个序列的映射,可能来自不同的集合,任意长度。

- 所提出的RNN编码器 - 解码器能够对一对序列进行评分(就条件概率而言),或者在给定源序列的情况下生成目标序列。

- 随着新架构的推出,提出了一种新颖的隐藏单元,其中包括一个复位门和一个更新门,自适应地控制每个隐藏单元在读取/生成序列时记住或忘记的程度。

- 以统计机器翻译为任务评估了所提出的模型,其中使用RNN编码器 - 解码器对短语表中的每个短语对进行评分。从定性上讲,能够证明新模型能够很好地捕获短语对中的语言规律性,并且RNN编码器 - 解码器能够提出格式良好的目标短语。 RNN编码器 - 解码器的分数被发现在BLEU分数方面提高了整体翻译性能。

- 此外,发现RNN编码器 - 解码器的贡献与在SMT系统中使用神经网络的现有方法相当正交,因此可以通过使用例如RNN编码器 - 解码器和神经网络语言模型来进一步提高性能。 对训练模型的定性分析表明,它确实捕获了多个层次的语言规律,即在单词水平和短语水平。这表明可能有更多与自然语言相关的应用程序可能受益于所提出的RNN编码器 - 解码器。

- 拟议的架构具有进一步改进和分析的巨大潜力。这里没有研究的一种方法是通过让RNN编码器 - 解码器提出目标短语来替换整个或部分短语表。此外,注意到所提出的模型不仅限于与书面语言一起使用,将所提出的架构应用于语音转录等其他应用将是一项重要的未来研究。

参考文献:Learning Phrase Representations using RNN Encoder–Decoder

for Statistical Machine Translation

边栏推荐

猜你喜欢

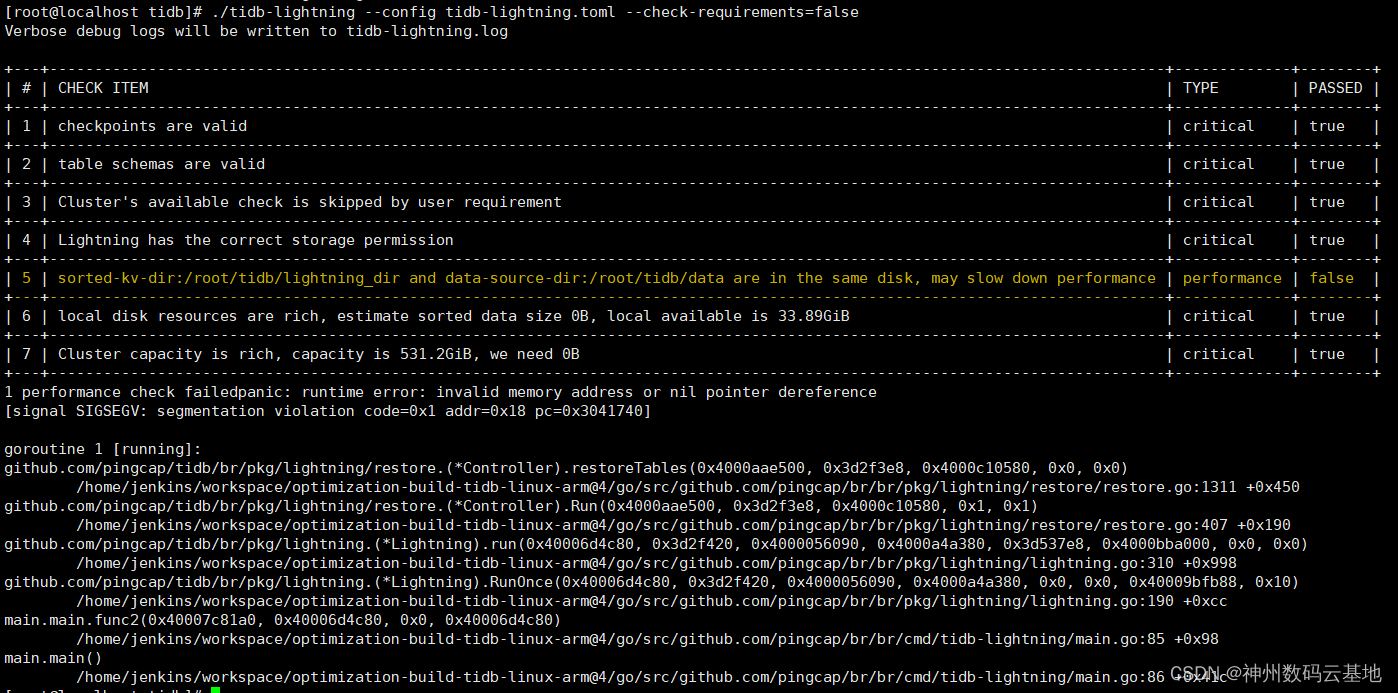

探索TiDB Lightning源码来解决发现的bug

了解什么是架构基本概念和架构本质

![[Interface Test] Decoding the request body string of the requests library](/img/99/82ef792dacd398a8a62dd94f235a91.png)

[Interface Test] Decoding the request body string of the requests library

【集训DAY5】快速排序【模拟】【数学】

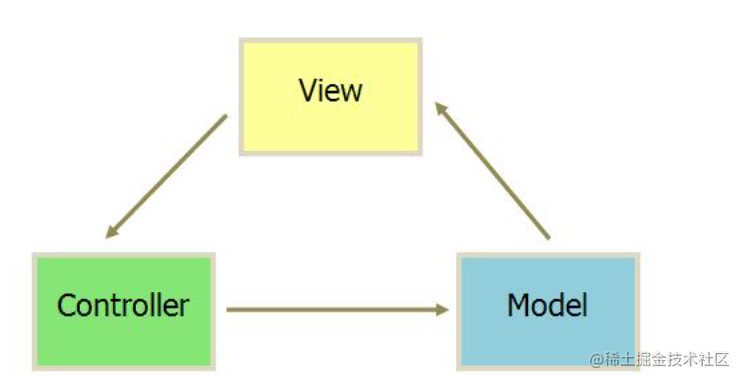

MVC与MVVM模式的区别

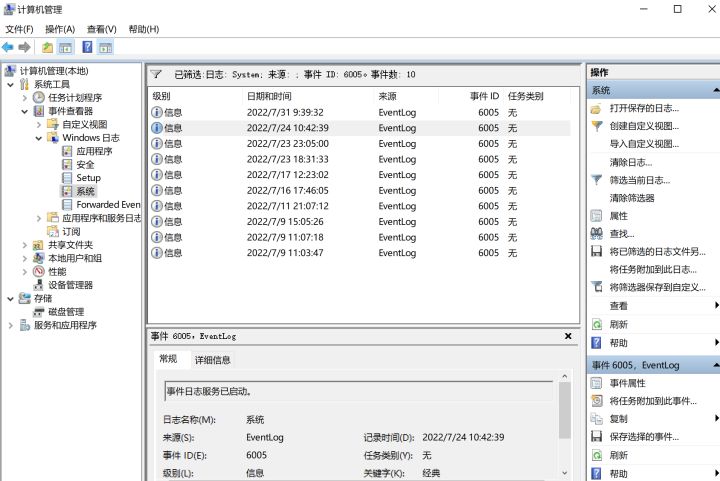

如何知道电脑开机记录?

【实用工具系列】MathCAD入门安装及快速上手使用教程

Travel with Shengteng: See all the AI attractions in Jinling City in one day

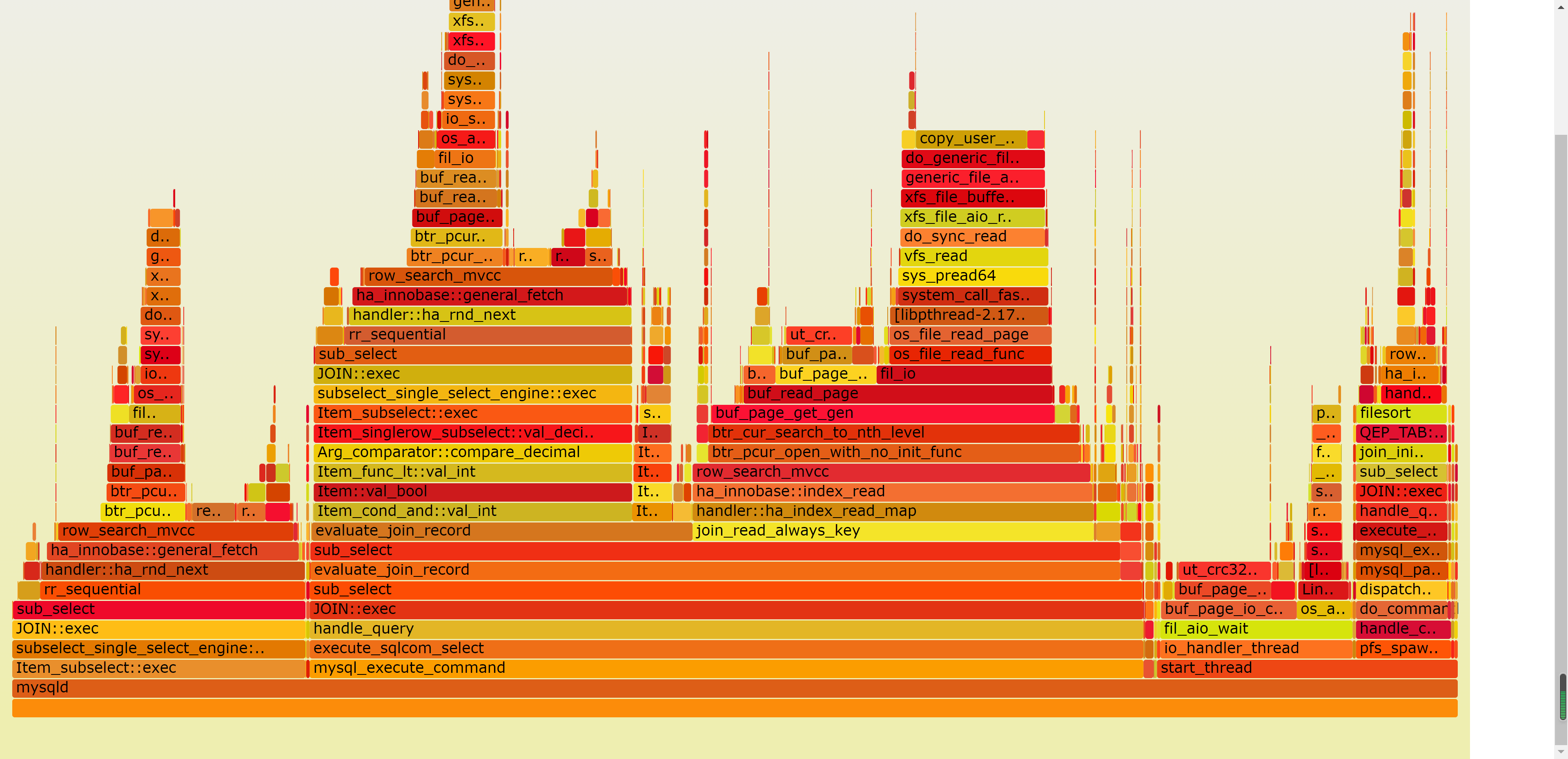

Mysql/stonedb - slow SQL - 2022-08-09 Q16 analysis

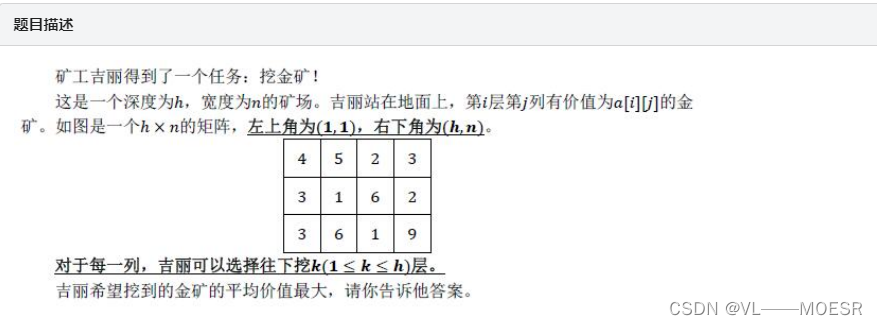

【集训DAY3】挖金矿【二分答案】

随机推荐

2022牛客暑期多校训练营6(ABGIJM)

技术盛宴!华云数据携六大议题亮相OpenInfra Days China

Force buckle: 279. Perfect square

金仓数据库 KingbaseGIS 使用手册(6.4. 几何对象存取函数)

Controller层代码这么写,简洁又优雅!

Force Buckle: 474. Ones and zeros

后台管理实现导入导出

伦敦银行情中短线的支撑和阻力位

高手这样看现货白银走势图

H5实现分享功能

Gold Warehouse Database KingbaseGIS User Manual (6.2. Management Functions)

61.【快速排序法详解】

多商户商城系统功能拆解24讲-平台端分销会员

中国SaaS企业排名,龙头企业Top10梳理

[Cloud Native] This article explains how to add Tencent Crane to Kubevela addon

【JZOF】77 Print binary tree in zigzag

测试2年,当时身边一起入行的朋友已经月薪20k了,自己还没过万,到底差在了哪里?

直播预告 | ICML 2022 11位一作学者在线分享神经网络,图学习等前沿研究

【诗歌】最高级的惩罚就是沉默

Filament - Material basic graphics drawing