当前位置:网站首页>The mathematical knowledge required for neural networks, the mathematical foundation of neural networks

The mathematical knowledge required for neural networks, the mathematical foundation of neural networks

2022-08-11 09:38:00 【Yangyang 2013 haha】

Want to learn neural network need to acquire what mathematical knowledge

神经网络是什么?

神经网络可以指向两种,一个是生物神经网络,一个是人工神经网络rbsci.生物神经网络:一般指生物的大脑神经元,细胞,触点等组成的网络,用于产生生物的意识,帮助生物进行思考和行动.

人工神经网络(ArtificialNeuralNetworks,简写为ANNs)也简称为神经网络(NNs)或称作连接模型(ConnectionModel),它是一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型.

这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的.人工神经网络:是一种应用类似于大脑神经突触联接的结构进行信息处理的数学模型.

在工程与学术界也常直接简称为“神经网络”或类神经网络.

深度学习需要多强的数学基础?

对于零基础小白,Want to develop deep learning,What math knowledge to master?首先是线性代数.Much of the computation in neural networks is matrix multiplication,This requires knowledge of linear algebra..

The inner product operation is also used to calculate the cosine similarity of the vector.,Various decomposition methods of matrices also appear in principal component analysis and singular value decomposition.followed by probability theory and statistics.

广义的说,At the heart of machine learning is statistical inference,Many of the giants of machine learning are masters of statistics,like michael jordan,Yang Lekun,Hinton et al,In addition, Bayesian formula is widely used in machine learning,Hidden Markov Models etc..Calculus again.

This is one of the core knowledge in machine learning,In both of the gradient descent method for gradient back propagation of error transfer will need to use the derivation of differential and integral calculus.可以了解下U就业.

To learn pattern recognition、神经网络、遗传算法、Ant colony algorithm, and so on artificial intelligence algorithm needs what mathematical knowledge?

Pattern recognition requires very good probability theory,数理统计;In addition, a small amount of matrix algebra will be used,Random processes and some operations in high numbers,Of course is the foundation;I'm afraid I need to learn functional if should go deep,But generally it is not necessary to reach this depth.

神经网络,Intelligent algorithms such as genetic algorithms have very important applications in pattern recognition,But generally do not need to study artificial intelligence in computer science,We have a cross subject called control intelligent control is about these,Intelligent control does not require any foundation,A collection of middle school math and a little knowledge of spaces is enough,The foundations of fuzzy mathematics are included in this discipline.

神经网络算法的人工神经网络

人工神经网络(ArtificialNeuralNetworks,ANN)系统是20世纪40年代后出现的.

它是由众多的神经元可调的连接权值连接而成,具有大规模并行处理、分布式信息存储、良好的自组织自学习能力等特点.

BP(BackPropagation)算法又称为误差反向传播算法,是人工神经网络中的一种监督式的学习算法.

BP神经网络算法在理论上可以逼近任意函数,基本的结构由非线性变化单元组成,具有很强的非线性映射能力.

而且网络的中间层数、各层的处理单元数及网络的学习系数等参数可根据具体情况设定,灵活性很大,在优化、信号处理与模式识别、智能控制、Fault diagnosis and many other fields have broad application prospects.

人工神经元的研究起源于脑神经元学说.19世纪末,在生物、生理学领域,Waldeger等人创建了神经元学说.人们认识到复杂的神经系统是由数目繁多的神经元组合而成.

大脑皮层包括有100亿个以上的神经元,每立方毫米约有数万个,它们互相联结形成神经网络,通过感觉器官和神经接受来自身体内外的各种信息,传递至中枢神经系统内,经过对信息的分析和综合,再通过运动神经发出控制信息,以此来实现机体与内外环境的联系,协调全身的各种机能活动.

神经元也和其他类型的细胞一样,包括有细胞膜、细胞质和细胞核.但是神经细胞的形态比较特殊,具有许多突起,因此又分为细胞体、轴突和树突三部分.细胞体内有细胞核,突起的作用是传递信息.

树突是作为引入输入信号的突起,而轴突是作为输出端的突起,它只有一个.树突是细胞体的延伸部分,它由细胞体发出后逐渐变细,全长各部位都可与其他神经元的轴突末梢相互联系,形成所谓“突触”.

在突触处两神经元并未连通,它只是发生信息传递功能的结合部,联系界面之间间隙约为(15~50)×10米.突触可分为兴奋性与抑制性两种类型,它相应于神经元之间耦合的极性.

每个神经元的突触数目正常,最高可达10个.各神经元之间的连接强度和极性有所不同,并且都可调整、基于这一特性,人脑具有存储信息的功能.利用大量神经元相互联接组成人工神经网络可显示出人的大脑的某些特征.

人工神经网络是由大量的简单基本元件——神经元相互联接而成的自适应非线性动态系统.每个神经元的结构和功能比较简单,但大量神经元组合产生的系统行为却非常复杂.

人工神经网络反映了人脑功能的若干基本特性,但并非生物系统的逼真描述,只是某种模仿、简化和抽象.

与数字计算机比较,人工神经网络在构成原理和功能特点等方面更加接近人脑,它不是按给定的程序一步一步地执行运算,而是能够自身适应环境、总结规律、完成某种运算、识别或过程控制.

人工神经网络首先要以一定的学习准则进行学习,然后才能工作.现以人工神经网络对于写“A”、“B”两个字母的识别为例进行说明,规定当“A”输入网络时,应该输出“1”,而当输入为“B”时,输出为“0”.

所以网络学习的准则应该是:如果网络作出错误的的判决,则通过网络的学习,应使得网络减少下次犯同样错误的可能性.

首先,给网络的各连接权值赋予(0,1)区间内的随机值,将“A”所对应的图象模式输入给网络,网络将输入模式加权求和、与门限比较、再进行非线性运算,得到网络的输出.

在此情况下,网络输出为“1”和“0”的概率各为50%,也就是说是完全随机的.这时如果输出为“1”(结果正确),则使连接权值增大,以便使网络再次遇到“A”模式输入时,仍然能作出正确的判断.

如果输出为“0”(即结果错误),则把网络连接权值朝着减小综合输入加权值的方向调整,其目的在于使网络下次再遇到“A”模式输入时,减小犯同样错误的可能性.

如此操作调整,当给网络轮番输入若干个手写字母“A”、“B”后,经过网络按以上学习方法进行若干次学习后,网络判断的正确率将大大提高.

这说明网络对这两个模式的学习已经获得了成功,它已将这两个模式分布地记忆在网络的各个连接权值上.当网络再次遇到其中任何一个模式时,能够作出迅速、准确的判断和识别.

一般说来,网络中所含的神经元个数越多,则它能记忆、识别的模式也就越多.(1)人类大脑有很强的自适应与自组织特性,后天的学习与训练可以开发许多各具特色的活动功能.

如盲人的听觉和触觉非常灵敏;聋哑人善于运用手势;训练有素的运动员可以表现出非凡的运动技巧等等.普通计算机的功能取决于程序中给出的知识和能力.显然,对于智能活动要通过总结编制程序将十分困难.

人工神经网络也具有初步的自适应与自组织能力.在学习或训练过程中改变突触权重值,以适应周围环境的要求.同一网络因学习方式及内容不同可具有不同的功能.

人工神经网络是一个具有学习能力的系统,可以发展知识,以致超过设计者原有的知识水平.

通常,它的学习训练方式可分为两种,一种是有监督或称有导师的学习,这时利用给定的样本标准进行分类或模仿;另一种是无监督学习或称无为导师学习,这时,只规定学习方式或某些规则,则具体的学习内容随系统所处环境(即输入信号情况)而异,系统可以自动发现环境特征和规律性,具有更近似人脑的功能.

(2)Generalization ability Generalization ability refers to the untrained samples,有很好的预测能力和控制能力.特别是,当存在一些有噪声的样本,网络具备很好的预测能力.

(3)Nonlinear mapping capabilities,很透彻或者很清楚时,则一般利用数值分析,偏微分方程等数学工具建立精确的数学模型,但当对系统很复杂,或者系统未知,系统信息量很少时,建立精确的数学模型很困难时,神经网络的非线性映射能力则表现出优势,因为它不需要对系统进行透彻的了解,但是同时能达到输入与输出的映射关系,这就大大简化设计的难度.

(4)Highly parallelism Parallelism is controversial.承认具有并行性理由:神经网络是根据人的大脑而抽象出来的数学模型,由于人可以同时做一些事,所以从功能的模拟角度上看,神经网络也应具备很强的并行性.

多少年以来,人们从医学、生物学、生理学、哲学、信息学、计算机科学、认知学、组织协同学等各个角度企图认识并解答上述问题.

在寻找上述问题答案的研究过程中,这些年来逐渐形成了一个新兴的多学科交叉技术领域,称之为“神经网络”.神经网络的研究涉及众多学科领域,这些领域互相结合、相互渗透并相互推动.

不同领域的科学家又从各自学科的兴趣与特色出发,提出不同的问题,从不同的角度进行研究.

下面将人工神经网络与通用的计算机工作特点来对比一下:若从速度的角度出发,人脑神经元之间传递信息的速度要远低于计算机,前者为毫秒量级,而后者的频率往往可达几百兆赫.

但是,由于人脑是一个大规模并行与串行组合处理系统,因而,在许多问题上可以作出快速判断、决策和处理,其速度则远高于串行结构的普通计算机.

人工神经网络的基本结构模仿人脑,具有并行处理特征,可以大大提高工作速度.人脑存贮信息的特点为利用突触效能的变化来调整存贮内容,也即信息存贮在神经元之间连接强度的分布上,存贮区与计算机区合为一体.

虽然人脑每日有大量神经细胞死亡(平均每小时约一千个),但不影响大脑的正常思维活动.

普通计算机是具有相互独立的存贮器和运算器,知识存贮与数据运算互不相关,只有通过人编出的程序使之沟通,这种沟通不能超越程序编制者的预想.元器件的局部损坏及程序中的微小错误都可能引起严重的失常.

心理学家和认知科学家研究神经网络的目的在于探索人脑加工、储存和搜索信息的机制,弄清人脑功能的机理,建立人类认知过程的微结构理论.

生物学、医学、脑科学专家试图通过神经网络的研究推动脑科学向定量、精确和理论化体系发展,同时也寄希望于临床医学的新突破;信息处理和计算机科学家研究这一问题的目的在于寻求新的途径以解决不能解决或解决起来有极大困难的大量问题,构造更加逼近人脑功能的新一代计算机.

人工神经网络早期的研究工作应追溯至上世纪40年代.下面以时间顺序,以著名的人物或某一方面突出的研究成果为线索,简要介绍人工神经网络的发展历史.

1943年,心理学家W·Mcculloch和数理逻辑学家W·Pitts在分析、总结神经元基本特性的基础上首先提出神经元的数学模型.此模型沿用至今,并且直接影响着这一领域研究的进展.

因而,他们两人可称为人工神经网络研究的先驱.1945年冯·诺依曼领导的设计小组试制成功存储程序式电子计算机,标志着电子计算机时代的开始.

1948年,他在研究工作中比较了人脑结构与存储程序式计算机的根本区别,提出了以简单神经元构成的再生自动机网络结构.

但是,由于指令存储式计算机技术的发展非常迅速,迫使他放弃了神经网络研究的新途径,继续投身于指令存储式计算机技术的研究,并在此领域作出了巨大贡献.

虽然,冯·诺依曼的名字是与普通计算机联系在一起的,但他也是人工神经网络研究的先驱之一.50年代末,F·Rosenblatt设计制作了“感知机”,它是一种多层的神经网络.

这项工作首次把人工神经网络的研究从理论探讨付诸工程实践.当时,世界上许多实验室仿效制作感知机,分别应用于文字识别、声音识别、声纳信号识别以及学习记忆问题的研究.

然而,这次人工神经网络的研究高潮未能持续很久,许多人陆续放弃了这方面的研究工作,这是因为当时数字计算机的发展处于全盛时期,许多人误以为数字计算机可以解决人工智能、模式识别、专家系统等方面的一切问题,使感知机的工作得不到重视;其次,当时的电子技术工艺水平比较落后,主要的元件是电子管或晶体管,利用它们制作的神经网络体积庞大,价格昂贵,要制作在规模上与真实的神经网络相似是完全不可能的;另外,在1968年一本名为《感知机》的著作中指出线性感知机功能是有限的,它不能解决如异感这样的基本问题,而且多层网络还不能找到有效的计算方法,这些论点促使大批研究人员对于人工神经网络的前景失去信心.

60年代末期,人工神经网络的研究进入了低潮.另外,在60年代初期,Widrow提出了自适应线性元件网络,这是一种连续取值的线性加权求和阈值网络.后来,在此基础上发展了非线性多层自适应网络.

当时,这些工作虽未标出神经网络的名称,而实际上就是一种人工神经网络模型.随着人们对感知机兴趣的衰退,神经网络的研究沉寂了相当长的时间.

80年代初期,模拟与数字混合的超大规模集成电路制作技术提高到新的水平,完全付诸实用化,此外,数字计算机的发展在若干应用领域遇到困难.这一背景预示,向人工神经网络寻求出路的时机已经成熟.

美国的物理学家Hopfield于1982年和1984年在美国科学院院刊上发表了两篇关于人工神经网络研究的论文,引起了巨大的反响.人们重新认识到神经网络的威力以及付诸应用的现实性.

随即,一大批学者和研究人员围绕着Hopfield提出的方法展开了进一步的工作,形成了80年代中期以来人工神经网络的研究热潮.

1985年,Ackley、Hinton和Sejnowski将模拟退火算法应用到神经网络训练中,提出了Boltzmann机,该算法具有逃离极值的优点,但是训练时间需要很长.

1986年,Rumelhart、Hinton和Williams提出了多层前馈神经网络的学习算法,即BP算法.它从证明的角度推导算法的正确性,是学习算法有理论依据.从学习算法角度上看,是一个很大的进步.

1988年,Broomhead和Lowe第一次提出了径向基网络:RBF网络.总体来说,神经网络经历了从高潮到低谷,再到高潮的阶段,充满曲折的过程.

关于<人工神经网络>如何入门?Foundation courses?

Artificial neural network is an algorithm that mimics the neural network of the human brain.After entering the corresponding features,Layer-by-layer calculation through the network,得出输出.To be carried out in accordance with the corresponding algorithm weights,Update of parameters such as thresholds.The more commonly used neural network models areBP(误差反馈)网络.The general network is three layers.

你可以先看看BP网络的,Should be able to solve your problem in classification recognition.

人工神经网络的定义,详细说明

人工神经网络(ArtificialNeuralNetworks,ANN),一种模范动物神经网络行为特征,进行分布式并行信息处理的算法数学模型.

这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的.

人工神经网络具有自学习和自适应的能力,可以通过预先提供的一批相互对应的输入-输出数据,分析掌握两者之间潜在的规律,最终根据这些规律,用新的输入数据来推算输出结果,这种学习分析的过程被称为“训练”.

(引自《环球科学》2007年第一期《神经语言:老鼠胡须下的秘密》)The concept of nonlinearity consisting of a large number of interconnected processing units、自适应信息处理系统.

它是在现代神经科学研究成果的基础上提出的,试图通过模拟大脑神经网络处理、记忆信息的方式进行信息处理.人工神经网络具有四个基本特征:(1)Nonlinear nonlinear relationship is a universal property of nature.

大脑的智慧就是一种非线性现象.人工神经元处于激活或抑制二种不同的状态,这种行为在数学上表现为一种非线性关系.具有阈值的神经元构成的网络具有更好的性能,可以提高容错性和存储容量.

(2)Non-limiting A neural network is usually composed of multiple neurons widely connected.一个系统的整体行为不仅取决于单个神经元的特征,而且可能主要由单元之间的相互作用、相互连接所决定.通过单元之间的大量连接模拟大脑的非局限性.

联想记忆是非局限性的典型例子.(3)Very qualitative artificial neural network with adaptive、自组织、自学习能力.神经网络不但处理的信息可以有各种变化,而且在处理信息的同时,非线性动力系统本身也在不断变化.

经常采用迭代过程描写动力系统的演化过程.(4)The evolution direction of a nonconvex system,在一定条件下将取决于某个特定的状态函数.例如能量函数,它的极值相应于系统比较稳定的状态.

非凸性是指这种函数有多个极值,故系统具有多个较稳定的平衡态,这将导致系统演化的多样性.人工神经网络中,神经元处理单元可表示不同的对象,例如特征、字母、概念,或者一些有意义的抽象模式.

网络中处理单元的类型分为三类:输入单元、输出单元和隐单元.输入单元接受外部世界的信号与数据;输出单元实现系统处理结果的输出;隐单元是处在输入和输出单元之间,不能由系统外部观察的单元.

神经元间的连接权值反映了单元间的连接强度,信息的表示和处理体现在网络处理单元的连接关系中.

人工神经网络是一种非程序化、适应性、大脑风格的信息处理,其本质是通过网络的变换和动力学行为得到一种并行分布式的信息处理功能,并在不同程度和层次上模仿人脑神经系统的信息处理功能.

它是涉及神经科学、思维科学、人工智能、计算机科学等多个领域的交叉学科.

人工神经网络是并行分布式系统,采用了与传统人工智能和信息处理技术完全不同的机理,克服了传统的基于逻辑符号的人工智能在处理直觉、非结构化信息方面的缺陷,具有自适应、自组织和实时学习的特点.

历史沿革1943年,心理学家W.S.McCulloch和数理逻辑学家W.Pitts建立了神经网络和数学模型,称为MP模型.

他们通过MP模型提出了神经元的形式化数学描述和网络结构方法,证明了单个神经元能执行逻辑功能,从而开创了人工神经网络研究的时代.1949年,心理学家提出了突触联系强度可变的设想.

60年代,人工神经网络的到了进一步发展,更完善的神经网络模型被提出,其中包括感知器和自适应线性元件等.

M.Minsky等仔细分析了以感知器为代表的神经网络系统的功能及局限后,于1969年出版了《Perceptron》一书,指出感知器不能解决高阶谓词问题.

他们的论点极大地影响了神经网络的研究,加之当时串行计算机和人工智能所取得的成就,掩盖了发展新型计算机和人工智能新途径的必要性和迫切性,使人工神经网络的研究处于低潮.

在此期间,一些人工神经网络的研究者仍然致力于这一研究,提出了适应谐振理论(ART网)、自组织映射、认知机网络,同时进行了神经网络数学理论的研究.以上研究为神经网络的研究和发展奠定了基础.

1982年,美国加州工学院物理学家J.J.Hopfield提出了Hopfield神经网格模型,引入了“计算能量”概念,给出了网络稳定性判断.

1984年,他又提出了连续时间Hopfield神经网络模型,为神经计算机的研究做了开拓性的工作,开创了神经网络用于联想记忆和优化计算的新途径,有力地推动了神经网络的研究,1985年,又有学者提出了波耳兹曼模型,在学习中采用统计热力学模拟退火技术,保证整个系统趋于全局稳定点.

1986年进行认知微观结构地研究,提出了并行分布处理的理论.

人工神经网络的研究受到了各个发达国家的重视,美国国会通过决议将1990年1月5日开始的十年定为“脑的十年”,国际研究组织号召它的成员国将“脑的十年”变为全球行为.

在日本的“真实世界计算(RWC)”项目中,人工智能的研究成了一个重要的组成部分.Basic content The artificial neural network model mainly considers the topology of the network connection、神经元的特征、学习规则等.

目前,已有近40种神经网络模型,其中有反传网络、感知器、自组织映射、Hopfield网络、波耳兹曼机、适应谐振理论等.

根据连接的拓扑结构,神经网络模型可以分为:(1)Each neuron in the forward network network accepts the input of the previous stage,并输出到下一级,网络中没有反馈,可以用一个有向无环路图表示.

这种网络实现信号从输入空间到输出空间的变换,它的信息处理能力来自于简单非线性函数的多次复合.网络结构简单,易于实现.反传网络是一种典型的前向网络.

(2)Feedback network There is feedback between neurons in the network,可以用一个无向的完备图表示.这种神经网络的信息处理是状态的变换,可以用动力学系统理论处理.系统的稳定性与联想记忆功能有密切关系.

Hopfield网络、波耳兹曼机均属于这种类型.学习是神经网络研究的一个重要内容,它的适应性是通过学习实现的.根据环境的变化,对权值进行调整,改善系统的行为.

由Hebb提出的Hebb学习规则为神经网络的学习算法奠定了基础.Hebb规则认为学习过程最终发生在神经元之间的突触部位,突触的联系强度随着突触前后神经元的活动而变化.

在此基础上,人们提出了各种学习规则和算法,以适应不同网络模型的需要.

有效的学习算法,使得神经网络能够通过连接权值的调整,构造客观世界的内在表示,形成具有特色的信息处理方法,信息存储和处理体现在网络的连接中.

根据学习环境不同,神经网络的学习方式可分为监督学习和非监督学习.

在监督学习中,将训练样本的数据加到网络输入端,同时将相应的期望输出与网络输出相比较,得到误差信号,以此控制权值连接强度的调整,经多次训练后收敛到一个确定的权值.

当样本情况发生变化时,经学习可以修改权值以适应新的环境.使用监督学习的神经网络模型有反传网络、感知器等.非监督学习时,事先不给定标准样本,直接将网络置于环境之中,学习阶段与工作阶段成为一体.

此时,学习规律的变化服从连接权值的演变方程.非监督学习最简单的例子是Hebb学习规则.竞争学习规则是一个更复杂的非监督学习的例子,它是根据已建立的聚类进行权值调整.

自组织映射、适应谐振理论网络等都是与竞争学习有关的典型模型.

研究神经网络的非线性动力学性质,主要采用动力学系统理论、非线性规划理论和统计理论,来分析神经网络的演化过程和吸引子的性质,探索神经网络的协同行为和集体计算功能,了解神经信息处理机制.

为了探讨神经网络在整体性和模糊性方面处理信息的可能,混沌理论的概念和方法将会发挥作用.混沌是一个相当难以精确定义的数学概念.

一般而言,“混沌”是指由确定性方程描述的动力学系统中表现出的非确定性行为,或称之为确定的随机性.

“确定性”是因为它由内在的原因而不是外来的噪声或干扰所产生,而“随机性”是指其不规则的、不能预测的行为,只可能用统计的方法描述.

混沌动力学系统的主要特征是其状态对初始条件的灵敏依赖性,混沌反映其内在的随机性.

混沌理论是指描述具有混沌行为的非线性动力学系统的基本理论、概念、方法,它把动力学系统的复杂行为理解为其自身与其在同外界进行物质、能量和信息交换过程中内在的有结构的行为,而不是外来的和偶然的行为,混沌状态是一种定态.

混沌动力学系统的定态包括:静止、平稳量、周期性、准同期性和混沌解.混沌轨线是整体上稳定与局部不稳定相结合的结果,称之为奇异吸引子.

一个奇异吸引子有如下一些特征:(1)奇异吸引子是一个吸引子,但它既不是不动点,也不是周期解;(2)奇异吸引子是不可分割的,即不能分为两个以及两个以上的吸引子;(3)它对初始值十分敏感,不同的初始值会导致极不相同的行为.

Development trend The unique nonlinear adaptive information processing ability of artificial neural network,克服了传统人工智能方法对于直觉,如模式、语音识别、非结构化信息处理方面的缺陷,使之在神经专家系统、模式识别、智能控制、组合优化、预测等领域得到成功应用.

人工神经网络与其它传统方法相结合,将推动人工智能和信息处理技术不断发展.

近年来,人工神经网络正向模拟人类认知的道路上更加深入发展,与模糊系统、遗传算法、进化机制等结合,形成计算智能,成为人工智能的一个重要方向,将在实际应用中得到发展.

将信息几何应用于人工神经网络的研究,为人工神经网络的理论研究开辟了新的途径.神经计算机的研究发展很快,已有产品进入市场.光电结合的神经计算机为人工神经网络的发展提供了良好条件.

What foundations do you need to have to learn deep learning??

If you want to go in the direction of deep learning in the future,In fact, the courses of the undergraduate mathematics department are basically sufficient.,如果不够的话,Just look at some materials and books to check the gaps and fill in the gaps.No need to go to a graduate degree in mathematics.推荐《DeepLearning》这本书.

作者是IanGoodfellow、YoshuaBengio和AaronCourvillethree bulls.The Chinese version of this book is in2017年7月22号上市.The book was completed by many translators.

《深度学习》This book introduces basic mathematics knowledge from the simple to the deep、机器学习经验以及现阶段深度学习的理论和发展,Whether you are an artificial intelligence technology enthusiast,Or practitioners use the book is very good.

另外,Readers who want to familiarize themselves with some mathematical knowledge,This book also introduces some,包括矩阵,Derivatives and other basic content.Readers can read from beginning to end.

《深度学习》A major feature of this book is the introduction to the nature of deep learning algorithms,The logic behind the algorithm is given out of the specific code implementation,Don't write code of the people also can see.

为了方便读者阅读,The author specially draws the content organization chart of this book,pointed out the whole book20Correlation between chapter content.Readers can choose according to their own background or needs,read at will.

official Chinese versionGitHub链接在此:Deep Learning JD.com¥151.20to buy other than that,还有一本书《动手学深度学习》.本书旨在向读者交付有关深度学习的交互式学习体验.

书中不仅阐述深度学习的算法原理,还演示它们的实现和运行.与传统图书不同,本书的每一节都是一个可以下载并运行的Jupyter记事本,它将文字、公式、图像、代码和运行结果结合在了一起.

此外,读者还可以访问并参与书中内容的讨论.

全书的内容分为3个部分:第一部分介绍深度学习的背景,提供预备知识,并包括深度学习基础的概念和技术;第二部分描述深度学习计算的重要组成部分,还解释近年来令深度学习在多个领域大获成功的卷积神经网络和循环神经网络;第三部分评价优化算法,检验影响深度学习计算性能的重要因素,并分别列举深度学习在计算机视觉和自然语言处理中的重要应用.

本书同时覆盖深度学习的方法和实践,主要面向在校大学生、技术人员和研究人员.阅读本书需要读者了解基本的Python编程或附录中描述的线性代数、微分和概率基础.

Hands-on deep learning JD.com¥76.50To buy if you feel mathematical knowledge is not enough,可以看这一本《深度学习的数学》.The book is based on the rich graphic and concrete examples,An easy-to-understand introduction to mathematics related to deep learning.

第1Chapter Introduction to Neural Networks;第2Chapter introduces the mathematical fundamentals needed to understand neural networks;第3Chapter Introduction to Optimization of Neural Networks;第4Chapter Introduction to Neural Networks and Error Backpropagation;第5Chapter Introduction to Deep Learning and Convolutional Neural Networks.

书中使用ExcelCarry out theoretical verification,Help readers intuitively experience the principles of deep learning.

人工神经网络,人工神经网络是什么意思

.

一、Artificial Neural Network Concept Artificial Neural Network(ArtificialNeuralNetwork,ANN)简称神经网络(NN),是基于生物学中神经网络的基本原理,在理解和抽象了人脑结构和外界刺激响应机制后,以网络拓扑知识为理论基础,模拟人脑的神经系统对复杂信息的处理机制的一种数学模型.

该模型以并行分布的处理能力、高容错性、智能化和自学习等能力为特征,将信息的加工和存储结合在一起,以其独特的知识表示方式和智能化的自适应学习能力,引起各学科领域的关注.

它实际上是一个有大量简单元件相互连接而成的复杂网络,具有高度的非线性,能够进行复杂的逻辑操作和非线性关系实现的系统.神经网络是一种运算模型,由大量的节点(或称神经元)之间相互联接构成.

每个节点代表一种特定的输出函数,称为激活函数(activationfunction).

每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重(weight),神经网络就是通过这种方式来模拟人类的记忆.网络的输出则取决于网络的结构、网络的连接方式、权重和激活函数.

而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达.神经网络的构筑理念是受到生物的神经网络运作启发而产生的.

人工神经网络则是把对生物神经网络的认识与数学统计模型相结合,借助数学统计工具来实现.

另一方面在人工智能学的人工感知领域,我们通过数学统计学的方法,使神经网络能够具备类似于人的决定能力和简单的判断能力,这种方法是对传统逻辑学演算的进一步延伸.

人工神经网络中,神经元处理单元可表示不同的对象,例如特征、字母、概念,或者一些有意义的抽象模式.网络中处理单元的类型分为三类:输入单元、输出单元和隐单元.

输入单元接受外部世界的信号与数据;输出单元实现系统处理结果的输出;隐单元是处在输入和输出单元之间,不能由系统外部观察的单元.

神经元间的连接权值反映了单元间的连接强度,信息的表示和处理体现在网络处理单元的连接关系中.

人工神经网络是一种非程序化、适应性、大脑风格的信息处理,其本质是通过网络的变换和动力学行为得到一种并行分布式的信息处理功能,并在不同程度和层次上模仿人脑神经系统的信息处理功能.

神经网络,是一种应用类似于大脑神经突触连接结构进行信息处理的数学模型,它是在人类对自身大脑组织结合和思维机制的认识理解基础之上模拟出来的,它是根植于神经科学、数学、思维科学、人工智能、统计学、物理学、计算机科学以及工程科学的一门技术.

二、The development of artificial neural networks The development of neural networks has a long history.其发展过程大致可以概括为如下4个阶段.

1.第一阶段----启蒙时期(1)、M-P神经网络模型:20世纪40年代,人们就开始了对神经网络的研究.

1943年,美国心理学家麦克洛奇(Mcculloch)和数学家皮兹(Pitts)提出了M-P模型,此模型比较简单,但是意义重大.

在模型中,通过把神经元看作个功能逻辑器件来实现算法,从此开创了神经网络模型的理论研究.

(2)、Hebb规则:1949年,心理学家赫布(Hebb)出版了《TheOrganizationofBehavior》(行为组织学),他在书中提出了突触连接强度可变的假设.

这个假设认为学习过程最终发生在神经元之间的突触部位,突触的连接强度随之突触前后神经元的活动而变化.这一假设发展成为后来神经网络中非常著名的Hebb规则.

这一法则告诉人们,神经元之间突触的联系强度是可变的,这种可变性是学习和记忆的基础.Hebb法则为构造有学习功能的神经网络模型奠定了基础.

(3)、感知器模型:1957年,罗森勃拉特(Rosenblatt)以M-P模型为基础,提出了感知器(Perceptron)模型.

感知器模型具有现代神经网络的基本原则,并且它的结构非常符合神经生理学.

这是一个具有连续可调权值矢量的MP神经网络模型,经过训练可以达到对一定的输入矢量模式进行分类和识别的目的,它虽然比较简单,却是第一个真正意义上的神经网络.

Rosenblatt证明了两层感知器能够对输入进行分类,他还提出了带隐层处理元件的三层感知器这一重要的研究方向.

Rosenblatt的神经网络模型包含了一些现代神经计算机的基本原理,从而形成神经网络方法和技术的重大突破.

(4)、ADALINE网络模型:1959年,美国著名工程师威德罗(B.Widrow)和霍夫(M.Hoff)等人提出了自适应线性元件(Adaptivelinearelement,简称Adaline)和Widrow-Hoff学习规则(又称最小均方差算法或称δ规则)的神经网络训练方法,并将其应用于实际工程,成为第一个用于解决实际问题的人工神经网络,促进了神经网络的研究应用和发展.

ADALINE网络模型是一种连续取值的自适应线性神经元网络模型,可以用于自适应系统.

2.第二阶段----One of the founders of artificial intelligence during the low tideMinsky和Papert对以感知器为代表的网络系统的功能及局限性从数学上做了深入研究,于1969年发表了轰动一时《Perceptrons》一书,指出简单的线性感知器的功能是有限的,它无法解决线性不可分的两类样本的分类问题,如简单的线性感知器不可能实现“异或”的逻辑关系等.

这一论断给当时人工神经元网络的研究带来沉重的打击.开始了神经网络发展史上长达10年的低潮期.

(1)、自组织神经网络SOM模型:1972年,芬兰的KohonenT.教授,提出了自组织神经网络SOM(Self-Organizingfeaturemap).

后来的神经网络主要是根据KohonenT.的工作来实现的.SOM网络是一类无导师学习网络,主要用于模式识别﹑语音识别及分类问题.

它采用一种“胜者为王”的竞争学习算法,与先前提出的感知器有很大的不同,同时它的学习训练方式是无指导训练,是一种自组织网络.

这种学习训练方式往往是在不知道有哪些分类类型存在时,用作提取分类信息的一种训练.

(2)、自适应共振理论ART:1976年,美国Grossberg教授提出了著名的自适应共振理论ART(AdaptiveResonanceTheory),其学习过程具有自组织和自稳定的特征.

3.第三阶段----复兴时期(1)、Hopfield模型:1982年,美国物理学家霍普菲尔德(Hopfield)提出了一种离散神经网络,即离散Hopfield网络,从而有力地推动了神经网络的研究.

在网络中,它首次将李雅普诺夫(Lyapunov)函数引入其中,后来的研究学者也将Lyapunov函数称为能量函数.证明了网络的稳定性.

1984年,Hopfield又提出了一种连续神经网络,将网络中神经元的激活函数由离散型改为连续型.

1985年,Hopfield和Tank利用Hopfield神经网络解决了著名的旅行推销商问题(TravellingSalesmanProblem).Hopfield神经网络是一组非线性微分方程.

Hopfield的模型不仅对人工神经网络信息存储和提取功能进行了非线性数学概括,提出了动力方程和学习方程,还对网络算法提供了重要公式和参数,使人工神经网络的构造和学习有了理论指导,在Hopfield模型的影响下,大量学者又激发起研究神经网络的热情,积极投身于这一学术领域中.

因为Hopfield神经网络在众多方面具有巨大潜力,所以人们对神经网络的研究十分地重视,更多的人开始了研究神经网络,极大地推动了神经网络的发展.

(2)、Boltzmann机模型:1983年,Kirkpatrick等人认识到模拟退火算法可用于NP完全组合优化问题的求解,这种模拟高温物体退火过程来找寻全局最优解的方法最早由Metropli等人1953年提出的.

1984年,Hinton与年轻学者Sejnowski等合作提出了大规模并行网络学习机,并明确提出隐单元的概念,这种学习机后来被称为Boltzmann机.

Hinton和Sejnowsky利用统计物理学的感念和方法,首次提出的多层网络的学习算法,称为Boltzmann机模型.

(3)、BP神经网络模型:1986年,儒默哈特(melhart)等人在多层神经网络模型的基础上,提出了多层神经网络权值修正的反向传播学习算法----BP算法(ErrorBack-Propagation),解决了多层前向神经网络的学习问题,证明了多层神经网络具有很强的学习能力,它可以完成许多学习任务,解决许多实际问题.

(4)、并行分布处理理论:1986年,由Rumelhart和McCkekkand主编的《ParallelDistributedProcessing:ExplorationintheMicrostructuresofCognition》,该书中,他们建立了并行分布处理理论,主要致力于认知的微观研究,同时对具有非线性连续转移函数的多层前馈网络的误差反向传播算法即BP算法进行了详尽的分析,解决了长期以来没有权值调整有效算法的难题.

可以求解感知机所不能解决的问题,回答了《Perceptrons》一书中关于神经网络局限性的问题,从实践上证实了人工神经网络有很强的运算能力.

(5)、细胞神经网络模型:1988年,Chua和Yang提出了细胞神经网络(CNN)模型,它是一个细胞自动机特性的大规模非线性计算机仿真系统.

Kosko建立了双向联想存储模型(BAM),它具有非监督学习能力.(6)、Darwinism模型:Edelman提出的Darwinism模型在90年代初产生了很大的影响,他建立了一种神经网络系统理论.

(7)、1988年,Linsker对感知机网络提出了新的自组织理论,并在Shanon信息论的基础上形成了最大互信息理论,从而点燃了基于NN的信息应用理论的光芒.

(8)、1988年,Broomhead和Lowe用径向基函数(Radialbasisfunction,RBF)提出分层网络的设计方法,从而将NN的设计与数值分析和线性适应滤波相挂钩.

(9)、1991年,Haken把协同引入神经网络,在他的理论框架中,他认为,认知过程是自发的,并断言模式识别过程即是模式形成过程.

(10)、1994年,廖晓昕关于细胞神经网络的数学理论与基础的提出,带来了这个领域新的进展.

通过拓广神经网络的激活函数类,给出了更一般的时滞细胞神经网络(DCNN)、Hopfield神经网络(HNN)、双向联想记忆网络(BAM)模型.

(11)、90年代初,Vapnik等提出了支持向量机(Supportvectormachines,SVM)和VC(Vapnik-Chervonenkis)维数的概念.

经过多年的发展,已有上百种的神经网络模型被提出.

边栏推荐

- mindspore如何实现每50个epoch检测一次psnr

- 期货开户最低的是交易所手续费不加佣金

- HDRP shader 获取阴影(Custom Pass)

- WordpressCMS主题开发01-首页制作

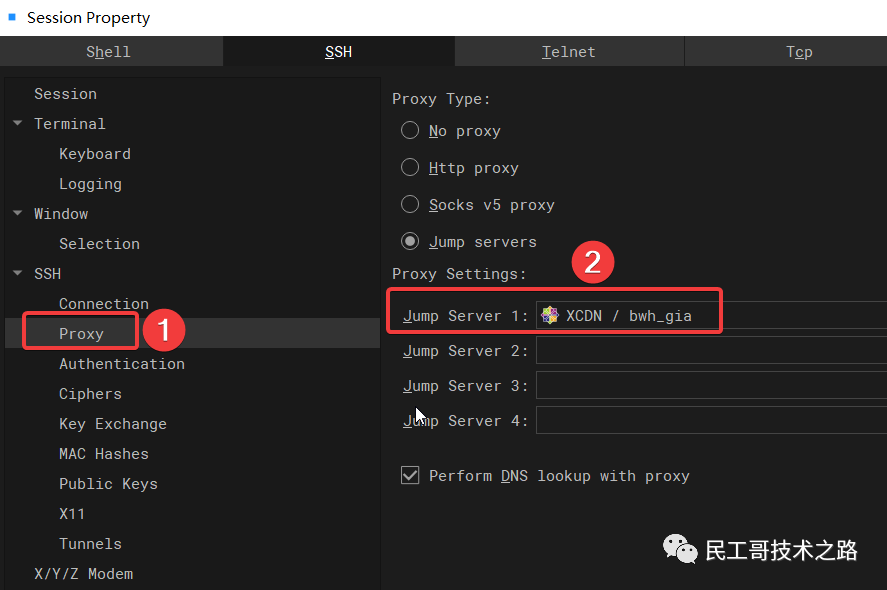

- Primavera P6 Professional 21.12 Login exception case sharing

- WooCommerce Ecommerce WordPress Plugin - Make American Money

- wordpress插件开发02-首页文章自动摘要插件开发

- 深度学习100例 —— 卷积神经网络(CNN)识别验证码

- Typescript基本类型---上篇

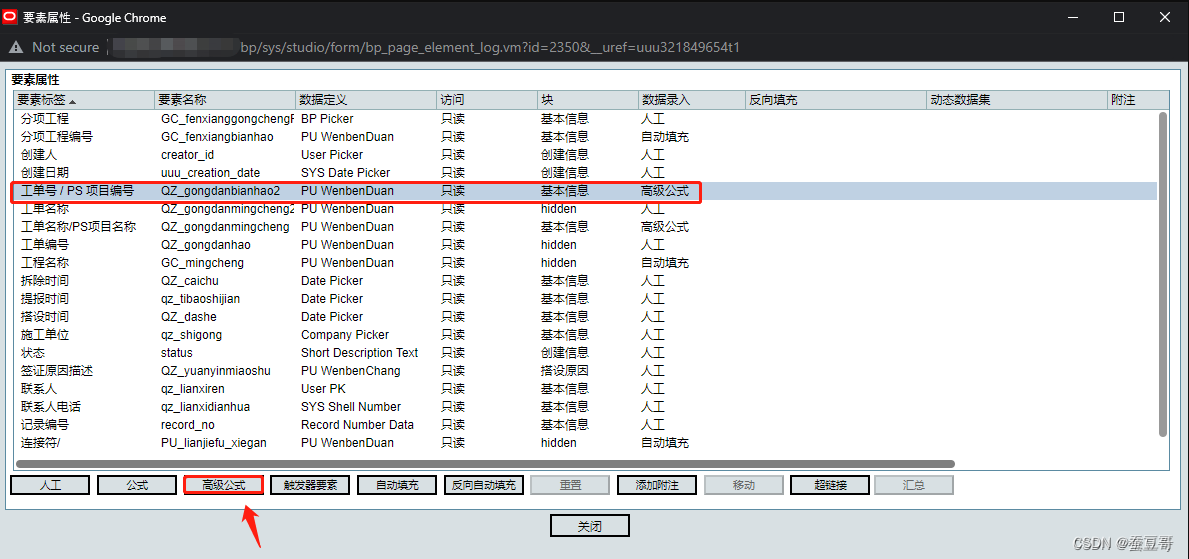

- Primavera Unifier advanced formula usage sharing

猜你喜欢

随机推荐

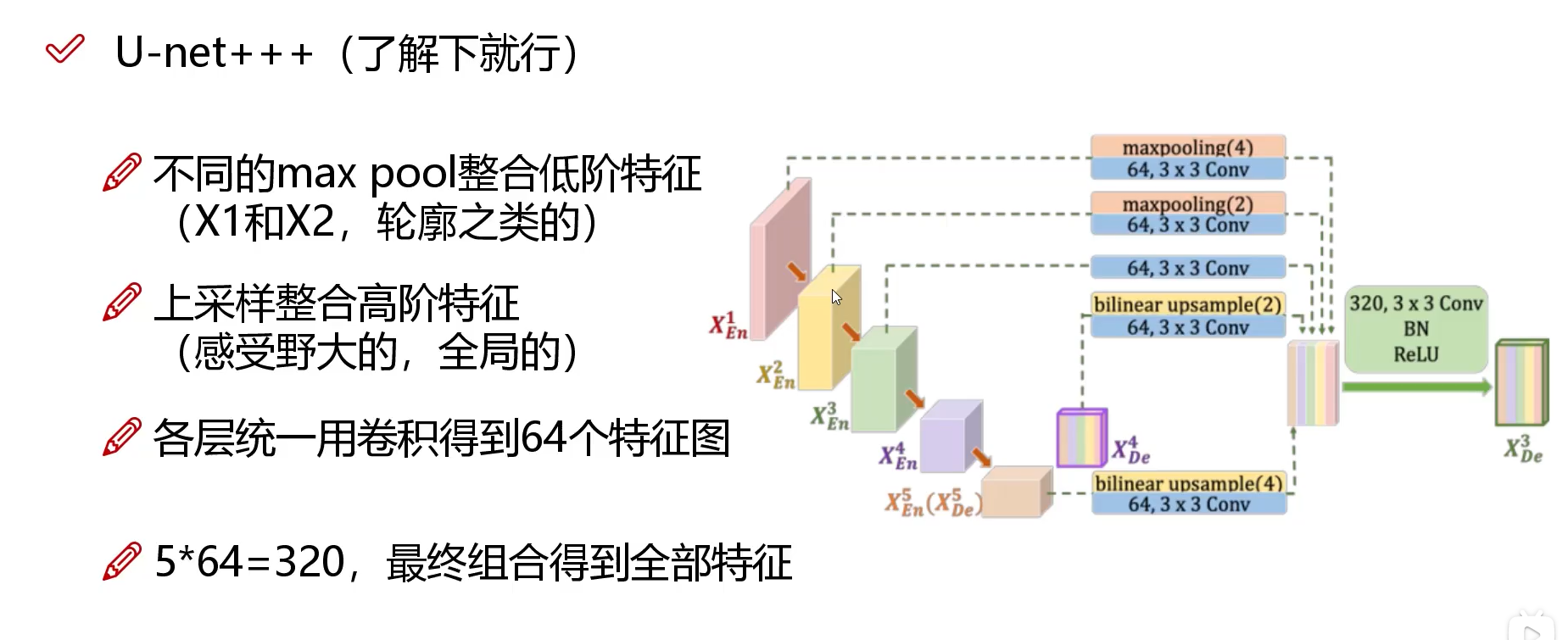

网络模型(U-net,U-net++, U-net+++)

The no-code platform helps Zhongshan Hospital build an "intelligent management system" to realize smart medical care

Adobe LiveCycle Designer report designer

零基础创作专业wordpress网站12-设置标签栏图标(favicon)

单元测试系统化讲解之PowerMock

database transaction

Inventorying Four Entry-Level SSL Certificates

Network Models (DeepLab, DeepLabv3)

Design of Cluster Gateway in Game Server

数据中台方案分析和发展方向

canvas图像阴影处理

qspi 接口与普通四线SPI 接口什么区别?

Song of the Cactus - Massive Rapid Expansion (1)

关于ts中的指针问题call,bind, apply

数据库事务

基于 VIVADO 的 AM 调制解调(3)仿真验证

5分钟快速为OpenHarmony提交PR(Web)

Redis的客户端连接的可视化管理工具

Halcon算子解释

mindspore中MindDataset读取mindrecord文件问题