当前位置:网站首页>bp神经网络反向传播原理,BP神经网络反向传播

bp神经网络反向传播原理,BP神经网络反向传播

2022-08-10 16:34:00 【阳阳2013哈哈】

BP神经网络(误差反传网络)

虽然每个人工神经元很简单,但是只要把多个人工神经元按一定方式连接起来就构成了一个能处理复杂信息的神经网络。采用BP算法的多层前馈网络是目前应用最广泛的神经网络,称之为BP神经网络。

它的最大功能就是能映射复杂的非线性函数关系。

对于已知的模型空间和数据空间,我们知道某个模型和他对应的数据,但是无法写出它们之间的函数关系式,但是如果有大量的一一对应的模型和数据样本集合,利用BP神经网络可以模拟(映射)它们之间的函数关系。

一个三层BP网络如图8.11所示,分为输入层、隐层、输出层。它是最常用的BP网络。理论分析证明三层网络已经能够表达任意复杂的连续函数关系了。只有在映射不连续函数时(如锯齿波)才需要两个隐层[8]。

图8.11中,X=(x1,…,xi,…,xn)T为输入向量,如加入x0=-1,可以为隐层神经元引入阀值;隐层输出向量为:Y=(y1,…,yi,…,ym)T,如加入y0=-1,可以为输出层神经元引入阀值;输出层输出向量为:O=(o1,…,oi,…,ol)T;输入层到隐层之间的权值矩阵用V表示,V=(V1,…,Vj,…,Vl)T,其中列向量Vj表示隐层第j个神经元的权值向量;隐层到输出层之间的权值矩阵用W表示,W=(W1,…,Wk,…,Wl)T,其中列向量Wk表示输出层第k个神经元的权值向量。

图8.11三层BP网络[8]BP算法的基本思想是:预先给定一一对应的输入输出样本集。学习过程由信号的正向传播与误差的反向传播两个过程组成。

正向传播时,输入样本从输入层传入,经过各隐层逐层处理后,传向输出层。若输出层的实际输出与期望的输出(教师信号)不符,则转入误差的反向传播。

将输出误差以某种形式通过隐层向输入层逐层反传,并将误差分摊给各层的所有神经元,获得各层的误差信号,用它们可以对各层的神经元的权值进行调整(关于如何修改权值参见韩立群著作[8]),循环不断地利用输入输出样本集进行权值调整,以使所有输入样本的输出误差都减小到满意的精度。

这个过程就称为网络的学习训练过程。当网络训练完毕后,它相当于映射(表达)了输入输出样本之间的函数关系。

在地球物理勘探中,正演过程可以表示为如下函数:d=f(m)(8.31)它的反函数为m=f-1(d)(8.32)如果能够获得这个反函数,那么就解决了反演问题。

一般来说,难以写出这个反函数,但是我们可以用BP神经网络来映射这个反函数m=f-1(d)。

对于地球物理反问题,如果把观测数据当作输入数据,模型参数当作输出数据,事先在模型空间随机产生大量样本进行正演计算,获得对应的观测数据样本,利用它们对BP网络进行训练,则训练好的网络就相当于是地球物理数据方程的反函数。

可以用它进行反演,输入观测数据,网络就会输出它所对应的模型。BP神经网络在能够进行反演之前需要进行学习训练。训练需要大量的样本,产生这些样本需要大量的正演计算,此外在学习训练过程也需要大量的时间。

但是BP神经网络一旦训练完毕,在反演中的计算时间可以忽略。要想使BP神经网络比较好地映射函数关系,需要有全面代表性的样本,但是由于模型空间的无限性,难以获得全面代表性的样本集合。

用这样的样本训练出来的BP网络,只能反映样本所在的较小范围数据空间和较小范围模型空间的函数关系。对于超出它们的观测数据就无法正确反演。

目前BP神经网络在一维反演有较多应用,在二维、三维反演应用较少,原因就是难以产生全面代表性的样本空间。

如何理解神经网络里面的反向传播算法

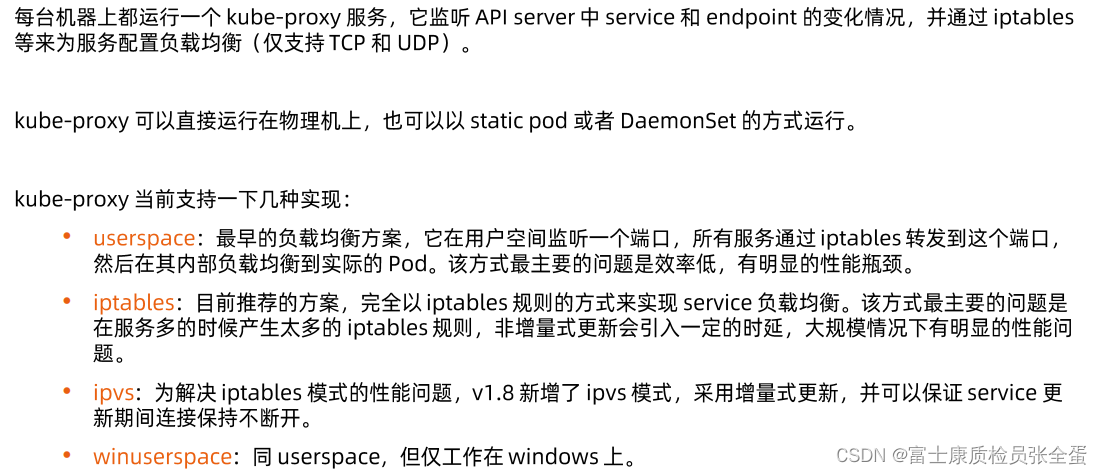

反向传播算法(BP算法)主要是用于最常见的一类神经网络,叫多层前向神经网络,本质可以看作是一个generalnonlinearestimator,即输入x_1...x_n输出y,视图找到一个关系y=f(x_1...x_n)(在这里f的实现方式就是神经网络)来近似已知数据。

为了得到f中的未知参数的最优估计值,一般会采用最小化误差的准则,而最通常的做法就是梯度下降,到此为止都没问题,把大家困住了很多年的就是多层神经网络无法得到显式表达的梯度下降算法!

BP算法实际上是一种近似的最优解决方案,背后的原理仍然是梯度下降,但为了解决上述困难,其方案是将多层转变为一层接一层的优化:只优化一层的参数是可以得到显式梯度下降表达式的;而顺序呢必须反过来才能保证可工作——由输出层开始优化前一层的参数,然后优化再前一层……跑一遍下来,那所有的参数都优化过一次了。

但是为什么说是近似最优呢,因为数学上除了很特殊的结构,step-by-step的优化结果并不等于整体优化的结果!不过,好歹现在能工作了,不是吗?

至于怎么再改进(已经很多改进成果了),或者采用其他算法(例如智能优化算法等所谓的全局优化算法,就算是没有BP这个近似梯度下降也只是局部最优的优化算法)那就是新的研究课题了。

反向传播算法的算法简介

反向传播算法(backpropagation)是目前用来训练人工神经网络(artificialneuralnetwork,ann)的最常用且最有效的算法。

其主要思想是:(1)将训练集数据输入到ann的输入层,经过隐藏层,最后达到输出层并输出结果,这是ann的前向传播过程;(2)由于ann的输出结果与实际结果有误差,则计算估计值与实际值之间的误差,并将该误差从输出层向隐藏层反向传播,直至传播到输入层;(3)在反向传播的过程中,根据误差调整各种参数的值;不断迭代上述过程,直至收敛。

反向传播算法的思想比较容易理解,但具体的公式则要一步步推导,因此本文着重介绍公式的推导过程。1.变量定义上图是一个三层人工神经网络,layer1至layer3分别是输入层、隐藏层和输出层。

如图,先定义一些变量:表示第层的第个神经元连接到第层的第个神经元的权重;表示第层的第个神经元的偏置;表示第层的第个神经元的输入,即:表示第层的第个神经元的输出,即:其中表示激活函数。

2.代价函数代价函数被用来计算ann输出值与实际值之间的误差。

常用的代价函数是二次代价函数(quadraticcostfunction):其中,表示输入的样本,表示实际的分类,表示预测的输出,表示神经网络的最大层数。

3.公式及其推导本节将介绍反向传播算法用到的4个公式,并进行推导。如果不想了解公式推导过程,请直接看第4节的算法步骤。

首先,将第层第个神经元中产生的错误(即实际值与预测值之间的误差)定义为:本文将以一个输入样本为例进行说明,此时代价函数表示为:公式1(计算最后一层神经网络产生的错误):其中,表示hadamard乘积,用于矩阵或向量之间点对点的乘法运算。

公式1的推导过程如下:公式2(由后往前,计算每一层神经网络产生的错误):推导过程:公式3(计算权重的梯度):推导过程:公式4(计算偏置的梯度):推导过程:4.反向传播算法伪代码输入训练集对于训练集中的每个样本x,设置输入层(inputlayer)对应的激活值:前向传播:,计算输出层产生的错误:

什么是反向传播算法

反向传播算法适合于多层神经元网络的一种学习算法,它建立在梯度下降法的基础上。

反向传播算法网络的输入输出关系实质上是一种映射关系:一个n输入m输出的BP神经网络所完成的功能是从n维欧氏空间向m维欧氏空间中一有限域的连续映射,这一映射具有高度非线性。

反向传播算法主要由两个环节(激励传播、权重更新)反复循环迭代,直到网络的对输入的响应达到预定的目标范围为止。反向传播算法的信息处理能力来源于简单非线性函数的多次复合,因此具有很强的函数复现能力。

这是BP算法得以应用的基础。反向传播算法被设计为减少公共子表达式的数量而不考虑存储的开销。反向传播避免了重复子表达式的指数爆炸。

扩展资料:BP算法(即反向传播算法)适合于多层神经元网络的一种学习算法,它建立在梯度下降法的基础上。

BP网络的输入输出关系实质上是一种映射关系:一个n输入m输出的BP神经网络所完成的功能是从n维欧氏空间向m维欧氏空间中一有限域的连续映射,这一映射具有高度非线性。

它的信息处理能力来源于简单非线性函数的多次复合,因此具有很强的函数复现能力。这是BP算法得以应用的基础。

bp算法是什么?

误差反向传播算法:BP算法的基本思想是,学习过程包括两个过程:信号前向传播和误差后向传播。(1)前向传播:输入样本->输入层->各隐层(处理)->输出层。

(2)错误反向传播:输出错误(某种形式)->隐藏层(逐层)->输入层。BP算法基本介绍:多层隐含层前馈网络可以极大地提高神经网络的分类能力,但长期以来一直没有提出解决权值调整问题的博弈算法。

1986年,Rumelhart和McCelland领导的科学家团队出版了《并行分布式处理》一书,详细分析了具有非线性连续传递函数的多层前馈网络的误差反向比例(BP)算法,实现了Minsky关于多层网络的思想。

由于误差的反向传播算法常用于多层前馈网络的训练,人们常直接称多层前馈网络为BP网络。

BP人工神经网络方法

(一)方法原理人工神经网络是由大量的类似人脑神经元的简单处理单元广泛地相互连接而成的复杂的网络系统。理论和实践表明,在信息处理方面,神经网络方法比传统模式识别方法更具有优势。

人工神经元是神经网络的基本处理单元,其接收的信息为x1,x2,…,xn,而ωij表示第i个神经元到第j个神经元的连接强度或称权重。

神经元的输入是接收信息X=(x1,x2,…,xn)与权重W={ωij}的点积,将输入与设定的某一阈值作比较,再经过某种神经元激活函数f的作用,便得到该神经元的输出Oi。

常见的激活函数为Sigmoid型。

人工神经元的输入与输出的关系为地球物理勘探概论式中:xi为第i个输入元素,即n维输入矢量X的第i个分量;ωi为第i个输入与处理单元间的互联权重;θ为处理单元的内部阈值;y为处理单元的输出。

常用的人工神经网络是BP网络,它由输入层、隐含层和输出层三部分组成。BP算法是一种有监督的模式识别方法,包括学习和识别两部分,其中学习过程又可分为正向传播和反向传播两部分。

正向传播开始时,对所有的连接权值置随机数作为初值,选取模式集的任一模式作为输入,转向隐含层处理,并在输出层得到该模式对应的输出值。每一层神经元状态只影响下一层神经元状态。

此时,输出值一般与期望值存在较大的误差,需要通过误差反向传递过程,计算模式的各层神经元权值的变化量。这个过程不断重复,直至完成对该模式集所有模式的计算,产生这一轮训练值的变化量Δωij。

在修正网络中各种神经元的权值后,网络重新按照正向传播方式得到输出。实际输出值与期望值之间的误差可以导致新一轮的权值修正。正向传播与反向传播过程循环往复,直到网络收敛,得到网络收敛后的互联权值和阈值。

(二)BP神经网络计算步骤(1)初始化连接权值和阈值为一小的随机值,即W(0)=任意值,θ(0)=任意值。(2)输入一个样本X。

(3)正向传播,计算实际输出,即根据输入样本值、互联权值和阈值,计算样本的实际输出。

其中输入层的输出等于输入样本值,隐含层和输出层的输入为地球物理勘探概论输出为地球物理勘探概论式中:f为阈值逻辑函数,一般取Sigmoid函数,即地球物理勘探概论式中:θj表示阈值或偏置;θ0的作用是调节Sigmoid函数的形状。

较小的θ0将使Sigmoid函数逼近于阈值逻辑单元的特征,较大的θ0将导致Sigmoid函数变平缓,一般取θ0=1。

(4)计算实际输出与理想输出的误差地球物理勘探概论式中:tpk为理想输出;Opk为实际输出;p为样本号;k为输出节点号。

(5)误差反向传播,修改权值地球物理勘探概论式中:地球物理勘探概论地球物理勘探概论(6)判断收敛。若误差小于给定值,则结束,否则转向步骤(2)。

(三)塔北雅克拉地区BP神经网络预测实例以塔北雅克拉地区S4井为已知样本,取氧化还原电位,放射性元素Rn、Th、Tc、U、K和地震反射构造面等7个特征为识别的依据。

构造面反映了局部构造的起伏变化,其局部隆起部位应是油气运移和富集的有利部位,它可以作为判断含油气性的诸种因素之一。

在该地区投入了高精度重磁、土壤微磁、频谱激电等多种方法,一些参数未入选为判别的特征参数,是因为某些参数是相关的。

在使用神经网络方法判别之前,还采用K-L变换(Karhaem-Loeve)来分析和提取特征。S4井位于测区西南部5线25点,是区内唯一已知井。

该井在5390.6m的侏罗系地层获得40.6m厚的油气层,在5482m深的震旦系地层中获58m厚的油气层。

取S4井周围9个点,即4~6线的23~25点作为已知油气的训练样本;由于区内没有未见油的钻井,只好根据地质资料分析,选取14~16线的55~57点作为非油气的训练样本。

BP网络学习迭代17174次,总误差为0.0001,学习效果相当满意。以学习后的网络进行识别,得出结果如图6-2-4所示。

图6-2-4塔北雅克拉地区BP神经网络聚类结果(据刘天佑等,1997)由图6-2-4可见,由预测值大于0.9可得5个大封闭圈远景区,其中测区南部①号远景区对应着已知油井S4井;②、③号油气远景区位于地震勘探所查明的托库1、2号构造,该两个构造位于沙雅隆起的东段,其西段即为1984年钻遇高产油气流的Sch2井,应是含油气性好的远景区;④、⑤号远景区位于大涝坝构造,是yh油田的组成部分。

BP算法首先要解决哪两个问题?

边栏推荐

- PC软件问题二[Win10系统将UltraEdit添加到右键菜单的方法]

- cube-studio配置镜像仓库并允许

- 数学基础(五)最优化理论(最优化,无约束,有约束,拉格朗日乘子的意义,KKT条件)

- Bitwarden:免费、开源的密码管理服务

- Gif动图制作怎么在线操作?一招教你快速完成gif在线制作

- The sword refers to OfferⅡ 045. The bottommost leftmost value of the binary tree dfs

- x64汇编代码测试 用户模式和内核模式

- 解决mpi4py导入报错ImportError: libmpi.so.40: cannot open shared object file: No such file or directory

- Go+:首个顺应 “三位一体” 发展潮流的编程语言

- 清理空的 Jetpack Compose 应用程序模板

猜你喜欢

随机推荐

MySQL的使用演示及操作,MySQL数据字符集的设置

C语言各种符号如何使用

Copper lock password library

网页分析和一些基础题目

I met a 25k+ from Tencent, he let me see what kind of basic ceiling

C专家编程 第10章 再论指针 10.5 使用指针向函数传递一个多维数组

How to realize full backup and incremental backup of MySQL database

如何修改gif图片尺寸?教你一键裁剪gif尺寸

直播预告|从新手村到魔王城,高效默契的敏捷团队如何炼成

如何将静图变gif动图?教你jpg合成gif的方法

为什么某互联网企业开200w年薪大家都支持,但是中金开100w年薪大家都在骂?...

雷达人体存在感应器,人体感知控制应用,为客户提供真实的感知方案

promise笔记(四)

超宽带uwb精准定位,厘米级室内定位技术,实时高精度方案应用

cmake tips record

LabView---双通道示波器(内含信号发生器)

被大厂面试官参考的Redis笔记,堪称Redis面试天花板

在Istio中,到底怎么获取 Envoy 访问日志?

一张图快速了解 Istio 的 EnvoyFilter

cmake 小技巧 记录