当前位置:网站首页>【概率论】正态分布的由来——从大一同学的视角出发

【概率论】正态分布的由来——从大一同学的视角出发

2022-08-09 11:15:00 【临淮郡人】

- 数学系大佬勿喷,本文以非数同学的视角出发

0.启发与思考

正态分布平时常常遇到,无论是在概率论中的“中心极限定理”,还是平时在学习ML中遇到的“高斯混合模型”,或者是在深度学习中,常常将一些数据假设为正态分布的情况。我们平时可能由于知到中心极限定理,因此默认正态分布是一个很好的分布。但是,这为什么不能是平均分布呢?二项分布呢?泊松分布?或者是其它抽样分布?

- 接下来我们将简要探讨正态分布的由来:

1. 背景

- 我们要对某个真实值 μ \mu μ进行 n n n次观测,得到了观测值 x 1 , x 2 , . . . , x n x_1,x_2,...,x_n x1,x2,...,xn,我们需要根据这n次观测推断 μ \mu μ,我们一般会怎么办呢?

- 试想我们进行物理实验的时候,对测量某个物体的长度,我们可能会测多次,然后取平均值。即我们认为 μ ˉ = ∑ i = 1 n x i n \bar{\mu}={\sum_{i=1}^n x_i \over n} μˉ=n∑i=1nxi可以用来估计真实值 μ \mu μ。背后,我们为什么会通过去取平均值来估计真实值呢?为什么不是通过求“几何平均”、“调和平均”或者“平方平均”呢?

p.s. 很多同学其实并没有意识到什么是 “调和平均”,试想一下并联电阻,是不是就明白啦?另外通过作图也可以理解几个平均数的含义。 - 事实上,我们假设观测误差 e i = x i − μ e_i=x_i-\mu ei=xi−μ是“关于0对称”的;换句话说 e i = c e_i=c ei=c与 e i = − c e_i=-c ei=−c的概率是相同的。

- 此外,我们学过了线性代数。在最小二乘的意义下, l o s s = 1 n ∑ i = 1 n ( x i − μ ˉ ) 2 loss={1 \over n }\sum_{i=1}^n (x_i-\bar{\mu})^2 loss=n1i=1∑n(xi−μˉ)2,可见当 μ ˉ = ∑ i = 1 n x i n \bar{\mu}={\sum_{i=1}^n x_i \over n} μˉ=n∑i=1nxi时,上述的误差代价最小,我们可以认为真实值是 μ ˉ \bar{\mu} μˉ

2. 步入正题:

我们学过极大似然估计的思想,即我们可以认为当前出现的事件,具有较大的概率。由于各次观测是独立的,因此 n n n次观察的误差情况 ( x 1 − μ , x 2 − μ , . . . , x n − μ ) (x_1-\mu,x_2-\mu,...,x_n-\mu) (x1−μ,x2−μ,...,xn−μ)的联合概率 P P P可以写为 ∏ i = 1 n p ( x i − μ ) \prod^n_{i=1}p(x_i-\mu) i=1∏np(xi−μ),其中 p ( x ) p(x) p(x)是关于随机变量误差 e e e的概率密度函数。其中,我们要求 μ \mu μ的估计值 μ ˉ \bar{\mu} μˉ。即当 μ \mu μ的估计值取为 μ ˉ \bar{\mu} μˉ时, P P P能取最大值。我们根据背景部分的假设,可得

- p(x)关于x=0对称

事实上,我们还可以给一个较强的假设方便计算: - p(x)有二阶连续的导函数

以下我们将从极大似然法的角度,证明:p(x)为高斯函数,即 p ( x ) = e a ( x − b ) 2 的 形 式 p(x)=e^{a(x-b)^2}的形式 p(x)=ea(x−b)2的形式

2.1. 从极大似然法的角度出发

考虑极大似然函数

L ( μ ) = l o g P = ∑ i = 1 n l o g ( p ( x i − μ ) ) L(\mu)=logP=\sum_{i=1}^nlog(p(x_i-\mu)) L(μ)=logP=i=1∑nlog(p(xi−μ))其取最大值的情况。其取最大值的必要条件是:

∂ L ( μ ) ∂ μ ∣ μ = μ ˉ = 0 {\partial L(\mu) \over \partial \mu } | _{\mu=\bar{\mu}}=0 ∂μ∂L(μ)∣μ=μˉ=0

其中:

∂ L ( μ ) ∂ μ ∣ μ = μ ˉ = − ∑ i = 1 n p ′ ( x i − μ ˉ ) p ( x i − μ ˉ ) {\partial L(\mu) \over \partial \mu } | _{\mu=\bar{\mu}} =- \sum_{i=1}^n {p'(x_i-\bar\mu) \over p(x_i-\bar\mu)} ∂μ∂L(μ)∣μ=μˉ=−i=1∑np(xi−μˉ)p′(xi−μˉ)

2.2 变形,讨论函数性质:

设 g ( x ) = p ′ ( x i − μ ) p ( x i − μ ) g(x)={p'(x_i-\mu) \over p(x_i-\mu)} g(x)=p(xi−μ)p′(xi−μ),则我们由1中的表达式,可得到:

∑ i = 1 n g ( x i − μ ˉ ) = 0 \sum_{i=1}^ng(x_i-\bar{\mu})=0 i=1∑ng(xi−μˉ)=0

其中

μ ˉ = ∑ i = 1 n x i n \bar{\mu}={\sum_{i=1}^n x_i \over n} μˉ=n∑i=1nxi

这是因为我们假设n次观察的误差应该是均匀的,即 ∑ i = 1 n ( x i − μ ˉ ) = 0 \sum_{i=1}^n (x_i-\bar\mu)=0 ∑i=1n(xi−μˉ)=0

以下我们将讨论函数 g ( x ) g(x) g(x)的性质,以便于求出 p ( x ) p(x) p(x)的性质。

- 我们利用

数学归纳法的思想,先考虑简单情况:n=2的情况,此时我们根据2中的表达式,可以得到 g ( x ) g(x) g(x)满足

g ( x ) + g ( − x ) = 0 , g(x)+g(-x)=0, g(x)+g(−x)=0,

即g(x)是奇函数; - 我们再考虑n=3的情况,此时:

g ( x 1 − μ ) + g ( x 2 − μ ) + g ( x 3 − μ ) = 0 g(x_1-\mu)+g(x_2-\mu)+g(x_3-\mu)=0 g(x1−μ)+g(x2−μ)+g(x3−μ)=0

其中 x 1 , x 2 , x 3 x_1,x_2,x_3 x1,x2,x3都是观测所得的,具有任意性,又由于 g g g为奇函数,因此得到以下式子

g ( x ) + g ( y ) = g ( x + y ) g(x)+g(y)=g(x+y) g(x)+g(y)=g(x+y)

这个函数方程被称为柯西函数方程。其实凭借着同学们大一所学到高等数学知识,已经可以求解 g ( x ) g(x) g(x)形式。

由于我们假设 p ( x ) p(x) p(x)有二阶连续导函数,因此 g ( x ) g(x) g(x)的函数也是连续的(其实这个条件有点强了)

2.3 具体求解

首先由 2 g ( 0 ) = g ( 0 ) 2g(0)=g(0) 2g(0)=g(0),得 g ( 0 ) = 0 g(0)=0 g(0)=0;

其次,由于 2 g ( x ) = g ( 2 x ) 2g(x)=g(2x) 2g(x)=g(2x),我们对 x x x求导得到:

g ′ ( x ) = g ′ ( 2 x ) g'(x)=g'(2x) g′(x)=g′(2x)

则由于 g ′ ( x ) g'(x) g′(x)连续,我们可得:

g ′ ( x ) = g ′ ( 2 n x ) = g ′ ( 1 2 n x ) lim n → ∞ g ′ ( x ) = lim n → ∞ g ′ ( 1 2 n x ) = g ′ ( lim n → ∞ 1 2 n x ) = g ′ ( 0 ) g'(x)=g'(2^nx)=g'({1 \over 2^n }x)\\ \lim\limits_{n\to \infty} g'(x)=\lim\limits_{n\to \infty} g'({1 \over 2^n }x) =g'(\lim\limits_{n\to \infty} {1 \over 2^n }x)=g'(0) g′(x)=g′(2nx)=g′(2n1x)n→∞limg′(x)=n→∞limg′(2n1x)=g′(n→∞lim2n1x)=g′(0)

可见 g ′ ( x ) = g ′ ( 0 ) = a g'(x)=g'(0)=a g′(x)=g′(0)=a, a a a为常数,则 g ( x ) = a x g(x)=ax g(x)=ax。现在我们已知 p ′ ( x i ) p ( x i ) = a x {p'(x_i) \over p(x_i)}=ax p(xi)p′(xi)=ax

此即微分方程: a x d x = 1 y d y axdx={1 \over y}dy axdx=y1dy

我们可以得到 l n y = 1 2 a x 2 + C lny={1 \over 2}ax^2+C lny=21ax2+C,即 p ( x ) = C e 1 2 a x 2 p(x)=Ce^{ {1 \over 2}ax^2} p(x)=Ce21ax2,其中C为待定系数,a为 g ′ ( 0 ) g'(0) g′(0)为常数。

根据p(x)的归一性, ∫ − ∞ + ∞ p ( x ) d x = 1 \int_{-\infty}^{+\infty}p(x)dx=1 ∫−∞+∞p(x)dx=1

又由于我们知到(升维变为二维积分后可得):

I ( a ) = ∫ − ∞ + ∞ e a 2 x 2 d x = 2 π a I(a)=\int_{-\infty}^{+\infty} e^{ {a \over 2}x^2}dx=\sqrt{2 \pi \over a} I(a)=∫−∞+∞e2ax2dx=a2π

可得到 C = a 2 π C=\sqrt{a \over 2 \pi} C=2πa

如果我们令 a = 1 σ 2 a={1 \over \sigma ^2} a=σ21,就得到了我们一般的均值为 0 0 0的正态分布形式:

p ( x ) = 1 2 π σ e x 2 2 σ 2 p(x)= {1\over {\sqrt {2 \pi}} \sigma}e^{x^2 \over {2 \sigma ^2}} p(x)=2πσ1e2σ2x2

得之。

- 实际上,出于严谨的考量,可以回头代入考察 g ( x ) g(x) g(x)函数的性质,因为以上结论的得出是我们通过考虑个例才得到的。

- 我们可以看见,这个函数是符合我们的假设的,它使得概率误差是关于0对称的。如果不是关于0对称的现象,我们也可以通过平移得到相应的结果,这里就不进行深入地讨论了。

- 此外,我们也可以看到,当误差数值越大,其概率越小,这也是符合我们直观的。

结语:

一个好的建模,在于建立合适的假设,进行正确的推导,所得到的结果能够很好的反映现实现象,能够很好地运用到生活问题的解决中。比如为什么我们需要很多近似的模型,因为近似的方法使得我们可以深入分析问题,使得计算成为了可能。

- 在本问题中,

极大似然的思想和对称的思想是非常重要的。 - 最小二乘法、正态分布分别从

线性代数的"投影"角度,和概率论的极大似然角度看,具有相似的含义。这里就不进行深入地讨论啦。

边栏推荐

猜你喜欢

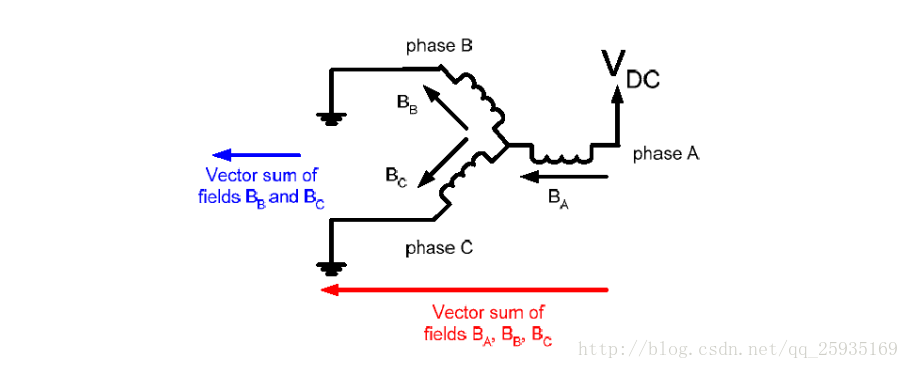

无刷无霍尔BLCD电机控制

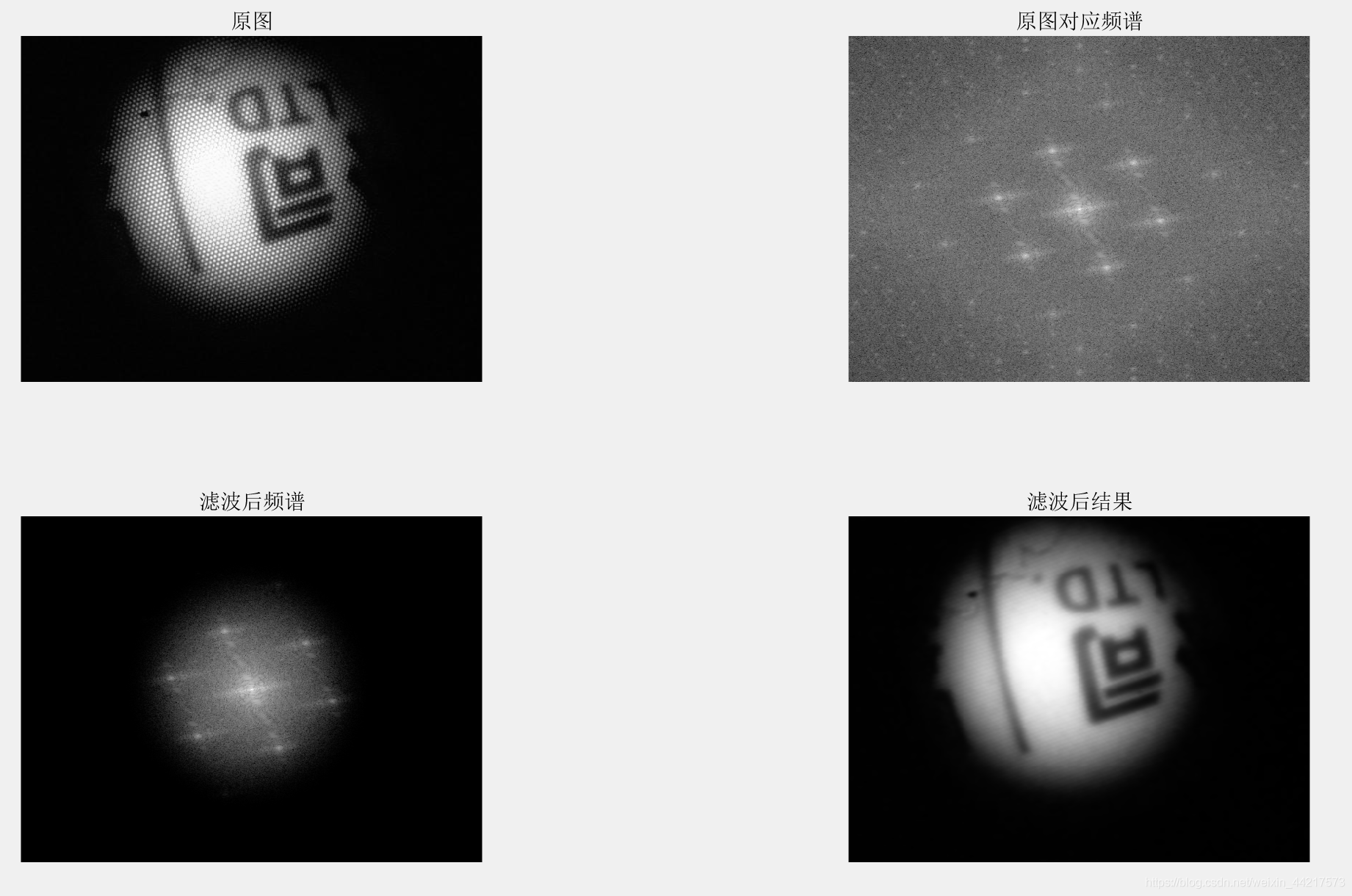

去除蜂窝状的噪声(matlab实现)

PTA 实验7-5 输出大写英文字母(10 分)

![[现代控制理论]2_state-space状态空间方程](/img/e4/5cf4be5e366278d0508d5aead3ef8e.png)

[现代控制理论]2_state-space状态空间方程

![[现代控制理论]3_Phase_portrait 相图 相轨迹](/img/45/255a6a62f8be320c663f5fcad1ad1b.png)

[现代控制理论]3_Phase_portrait 相图 相轨迹

![[现代控制理论]4_PhasePortrait爱情故事动态系统分析](/img/cd/dc1266addc58c3cd3e087f168bebf9.png)

[现代控制理论]4_PhasePortrait爱情故事动态系统分析

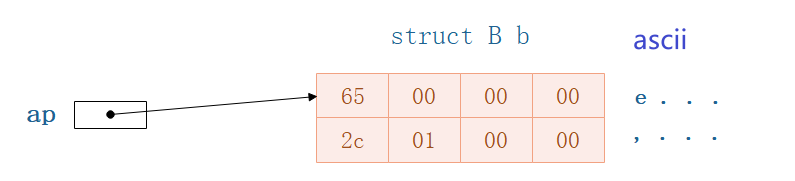

【精华文】C语言结构体特殊情况分析:结构体指针 / 基本数据类型指针,指向其他结构体

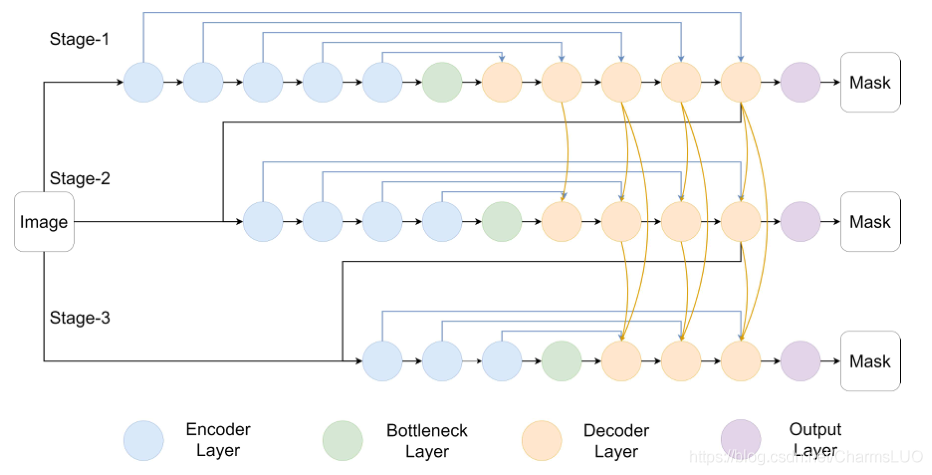

【Subpixel Dense Refinement Network for Skeletonization】CVPR2020论文解读

golang 三种指针类型具体类型的指针、unsafe.Pointer、uintptr作用

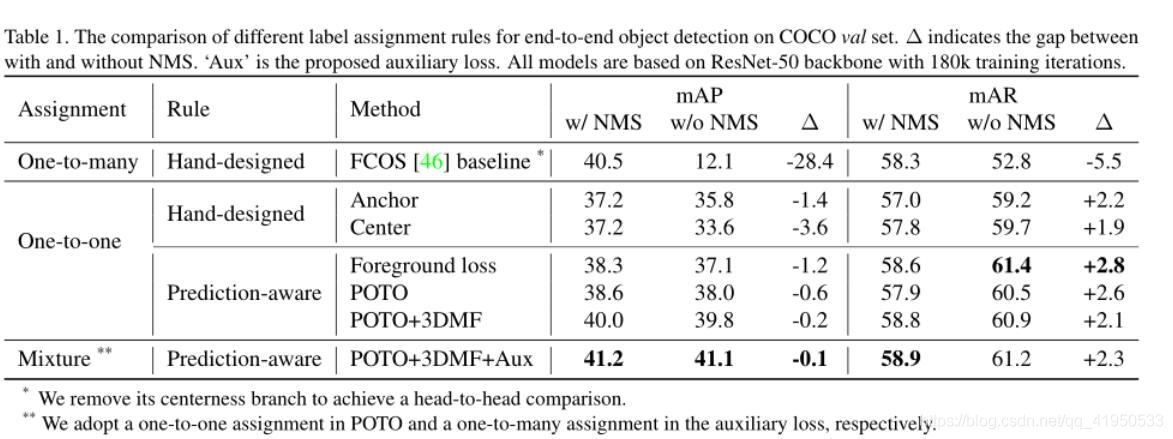

End-to-End Object Detection with Fully Convolutional Network学习笔记

随机推荐

OC-NSTimer

uni-app 自带的picker封装一个日期-时间选择器

【Subpixel Dense Refinement Network for Skeletonization】CVPR2020论文解读

Antdv+Asp.net WebApi开发学生信息管理系统(一)

ZOJ1298(单源最短路径)

mysql8.0和navicat premium15下载安装

bit、byte、KB、M、G、T相互关系

ACM最长不下降子序列问题

matlab fcnchk 函数用法

∘(空心的点乘)的数学含义

Qt读写.ini配置文件

focusablejs

ECCV 2022 Oral | CCPL: 一种通用的关联性保留损失函数实现通用风格迁移

去除蜂窝状的噪声(matlab实现)

PAT章节

[现代控制理论]5_系统的可控性_controllability

x86异常处理与中断机制(2)中断向量表

redis的线程模型

VS Code有趣插件

【精华文】C语言结构体特殊情况分析:结构体指针 / 基本数据类型指针,指向其他结构体