当前位置:网站首页>视频理解-Video Understanding

视频理解-Video Understanding

2022-04-23 19:23:00 【隔壁老瓦】

视频理解是计算机视觉中的重要任务,近年来随着深度学习特别是监督学习的应用视频理解取得了飞速的发展,例如视频行为分类和视频片段总结等任务都取得了令人瞩目的成果。

不过,现实生活中很多场景的应用视频片段需要不止一个标签来提供足够的信息。举个例子,机器人往杯子里倒水,一个简单的“倾倒液体”标签不足以预测出杯子何时倒满,机器人需要逐帧追踪杯中的水量。再比如说,在运动分析领域,棒球教练不仅仅想要看到投球的动作,而是想精确地分析投手投出棒球离手的一瞬间,单一的视频标签不足以完成这样的视频检索任务。这意味着视频理解模型需要逐帧理解视频的能力。

然而如果使用监督学习的方法将会使学习成本变得非常昂贵,这需要针对视频里每一帧的动作进行细粒度的标注,训练不同的动作还需要新的标注来提供监督信号。但从机器人到运动分析等领域,细粒度的视频理解有着很强的需求,那么如何在不需要大量标签的情况下对视频进行学习以理解细粒度的信息呢?

来自谷歌的研究人员们提出了一种称为时间循环一致性学习(Temporal Cycle-Consistency Learning,TCC)的自监督方法。通过学习不同样本相似过程的表示来实现细粒度的时域视频理解,为逐帧视频检索、动作分析、视频同步和多模态迁移提供了新的解决方案。

理解视频中的动态行为是AI未来发展的关键方向。

视频行为理解包括视频分类、动作识别、时序行为检测和视频摘要生成等。

最近整理了一下所看的论文,主要是视频分类、动作识别和视频数据集方面的,列举了相关数据集上的最佳水平,分享在GitHub。

HMDB51数据集上,DOVF+MIFS方法最高水平的准确度为75%,在该数据集上还有较大的性能提升空间;

UCF101数据集上,TLE方法达到最高水平的准确率为95.6%;

ActivityNet数据集上,UntrimmedNet (hard)方法获得最高水平为91.3%;

Sports-1M数据集上,LSTM+Pretrained on YT-8M方法获得最高水平的[email protected]和[email protected],分别为74.2%和92.4%,mAP为67.6%;

YouTube-8M数据集上,WILLOW团队的方法获得最高水平的84.967%。

Awesome Video Understanding

2. 对视频内容的语义进行关键词提取;

1) 对视频的帧截图:

l 有的是截每一帧;

l 有的是镜头转换时再截,如何判断视频的镜头是否转换呢?计算前后两个图片的差距,差的很多,说明镜头换了,需要再截图。

2) 对截图进行语义识别;

3) 将视频的语音转换成文字;

4) 对文字进行语义识别

5) 将上述截图得到的语义和文字得到的语义综合在一起,就是这个视频的语义;

版权声明

本文为[隔壁老瓦]所创,转载请带上原文链接,感谢

https://blog.csdn.net/wxb880114/article/details/124365106

边栏推荐

- 高层次人才一站式服务平台开发 人才综合服务平台系统

- Android Development: the client obtains the latest value in the database in real time and displays it on the interface

- Regular expressions for judging positive integers

- ArcMap publishing slicing service

- OpenHarmony开源开发者成长计划,寻找改变世界的开源新生力!

- White screen processing method of fulter startup page

- Build intelligent garbage classification applet based on Zero

- SQL Server database in clause and exists clause conversion

- Pit encountered using camera x_ When onpause, the camera is not released, resulting in a black screen when it comes back

- FTP, SSH Remote Access and control

猜你喜欢

mysql通过binlog恢复或回滚数据

OpenHarmony开源开发者成长计划,寻找改变世界的开源新生力!

The platinum library cannot search the debug process records of some projection devices

FTP、ssh远程访问及控制

Openharmony open source developer growth plan, looking for new open source forces that change the world!

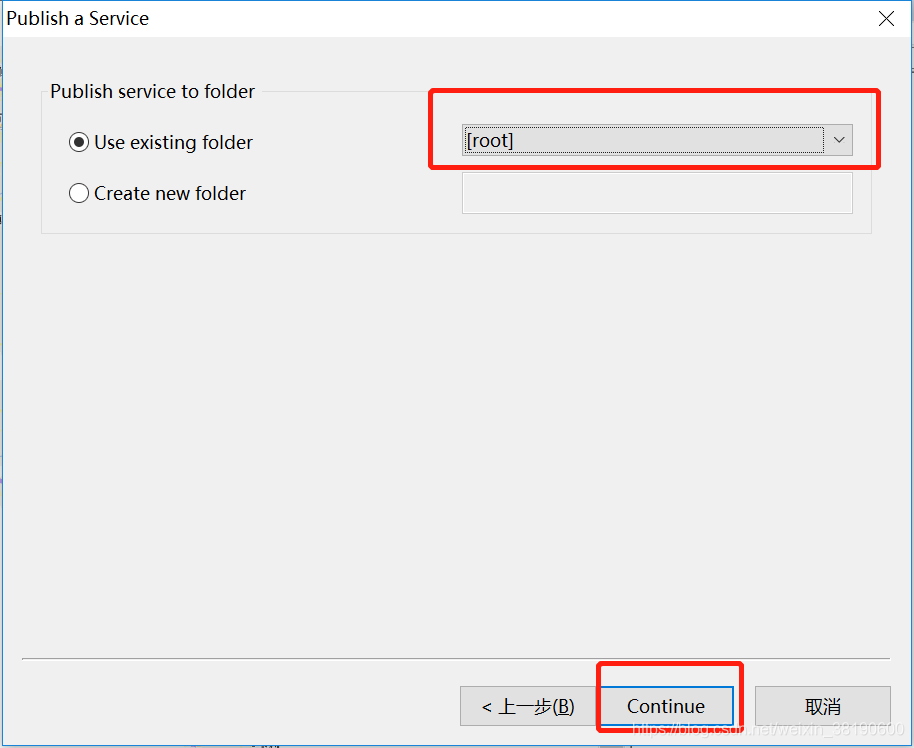

ArcMap publishing slicing service

MySQL syntax collation (2)

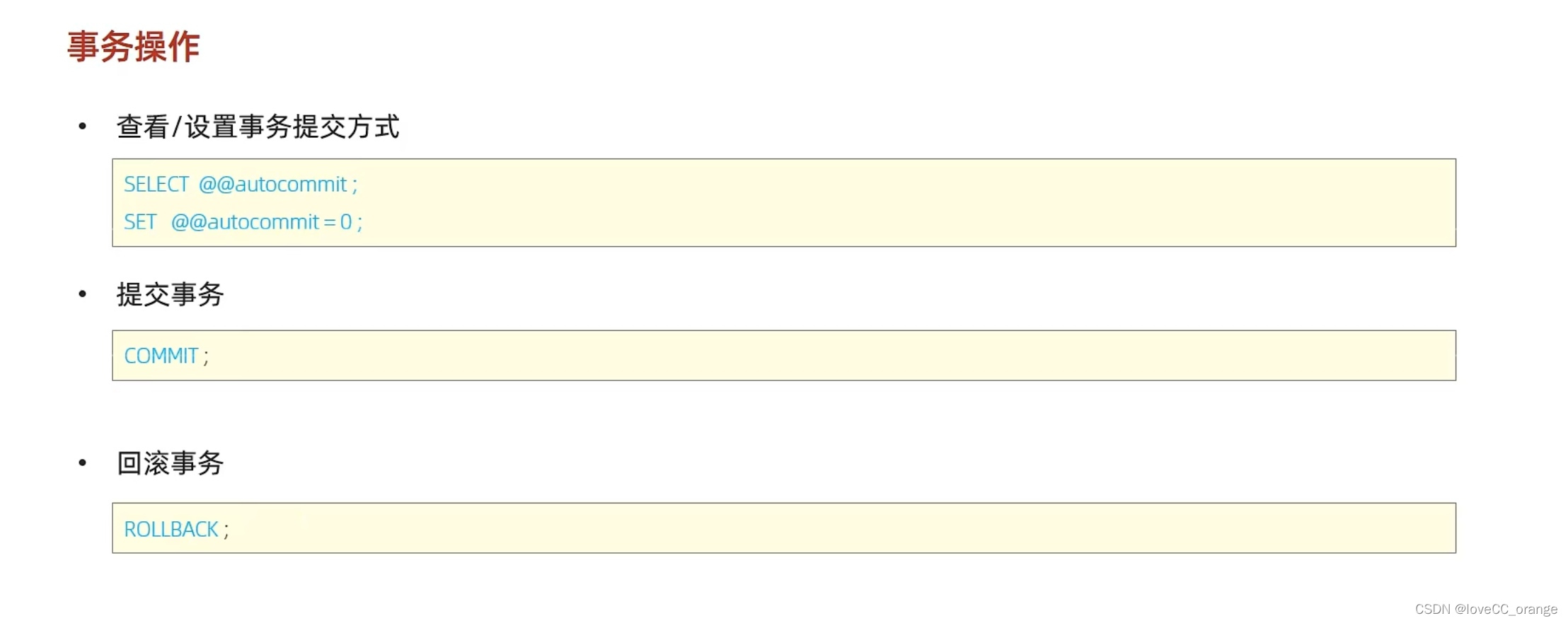

The fifth bullet of MySQL learning -- detailed explanation of transaction and its operation characteristics

Pdf reference learning notes

開關電源設計分享及電源設計技巧圖解

随机推荐

On the forced conversion of C language pointer

Codeworks round 783 (Div. 2) d problem solution

Executor、ExecutorService、Executors、ThreadPoolExecutor、Future、Runnable、Callable

SSDB foundation 1

c1000k TCP 连接上限测试

MySQL syntax collation (2)

OpenHarmony开源开发者成长计划,寻找改变世界的开源新生力!

JVM的类加载过程

Installation, use and problem summary of binlog2sql tool

Reflection on the performance of some OpenGL operations in the past

Pit encountered using camera x_ When onpause, the camera is not released, resulting in a black screen when it comes back

[play with lighthouse] Tencent cloud lightweight server builds a full platform video analysis video download website

Partage de la conception de l'alimentation électrique de commutation et illustration des compétences en conception de l'alimentation électrique

命令-sudo

mysql通过binlog恢复或回滚数据

static类变量快速入门

openlayers 5.0 当地图容器大小改变时,重新加载地图

开关电源设计分享及电源设计技巧图解

openlayers 5.0 两种居中方式

MySQL syntax collation (5) -- functions, stored procedures and triggers