当前位置:网站首页>听声辨物,这是AI视觉该干的???|ECCV 2022

听声辨物,这是AI视觉该干的???|ECCV 2022

2022-08-09 11:55:00 【QbitAl】

衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

听到“唔哩——唔哩——”的警笛声,你可以迅速判断出声音来自路过的一辆急救车。

能不能让AI根据音频信号得到发声物完整的、精细化的掩码图呢?

来自合肥工业大学、商汤、澳国立、北航、英伟达、港大和上海人工智能实验室的研究者提出了一项新的视听分割任务(Audio-Visual Segmentation, AVS)。

视听分割,就是要分割出发声物,而后生成发声物的精细化分割图。

相应的,研究人员提出了第一个具有像素级标注的视听数据集AVSBench。

新任务、新的数据集,搞算法的又有新坑可以卷了。

据最新放榜结果,该论文已被ECCV 2022接受。

精准锁定发声物

听觉和视觉是人类感知世界中最重要的两个传感器。生活里,声音信号和视觉信号往往是互补的。

视听表征学习(audio-visual learning)已经催生了很多有趣的任务,比如视听通信(AVC)、视听事件定位(AVEL)、视频解析(AVVP)、声源定位(SSL)等。

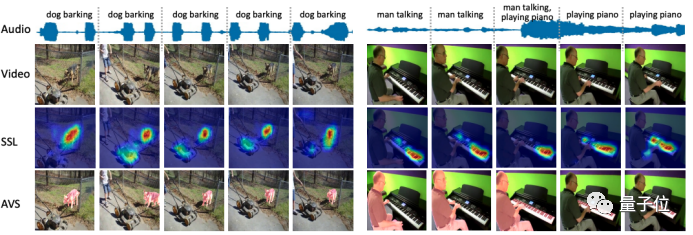

这里面既有判定音像是否描述同一事件/物体的分类任务,也有以热力图可视化大致定位发声物的任务。

但无论哪一种,离精细化的视听场景理解都差点意思。

△ AVS 任务与 SSL 任务的比较

视听分割“迎难而上”,提出要准确分割出视频帧中正在发声的物体全貌——

即以音频为指导信号,确定分割哪个物体,并得到其完整的像素级掩码图。

AVSBench 数据集

要怎么研究这个新任务呢?

鉴于当前还没有视听分割的开源数据集,研究人员提出AVSBench 数据集,借助它研究了新任务的两种设置:

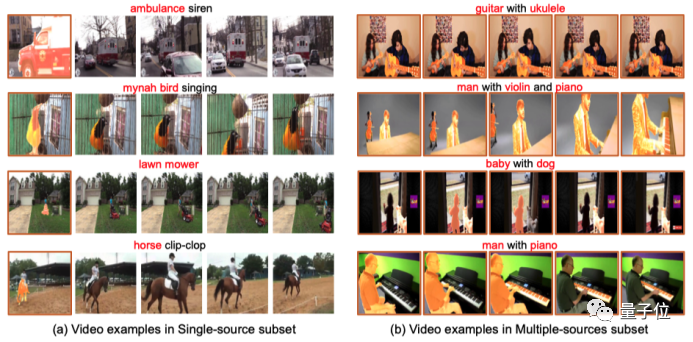

1、单声源(Single-source)下的视听分割

2、多声源(Multi-sources)下的视听分割

数据集中的每个视频时长5秒。

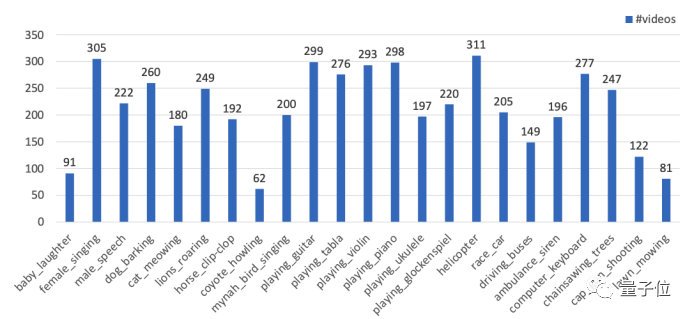

单声源子集包含23类,共4932个视频,包含婴儿、猫狗、吉他、赛车、除草机等与日常生活息息相关的发声物。

△AVSBench单源子集的数据分布

多声源子集则包含了424个视频。

结合难易情况,单声源子集在半监督条件下进行,多声源子集则以全监督条件进行。

研究人员对AVSBench里的每个视频等间隔采样5帧,然后人工对发声体进行像素级标注。

对于单声源子集,仅标注采样的第一张视频帧;对于多声源子集,5帧图像都被标注——这就是所谓的半监督和全监督。

△对单声源子集和多声源子集进行不同人工标注

这种像素级的标注,避免了将很多非发声物或背景给包含进来,从而增加了模型验证的准确性。

一个简单的baseline方法

有了数据集,研究人员还抛砖引玉,在文中给了个简单的baseline。

吸收传统语义分割模型的成功经验,研究人员提出了一个端到端的视听分割模型。

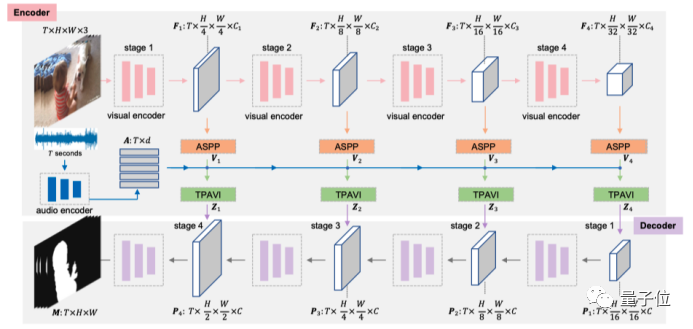

△视听分割框架图

这个模型遵循编码器-解码器的网络架构,输入视频帧,最终直接输出分割掩码。

另外,还有两个网络优化目标。

一是计算预测图和真实标签的损失。

而针对多声源情况,研究人员提出了掩码视听匹配损失函数,用来约束发声物和音频特征在特征空间中保持相似分布。

部分实验结果

光说不练假把式,研究人员进行了广泛实验。

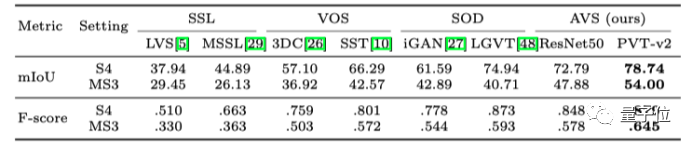

首先,将视听分割与相关任务的6种方法进行了比较,研究人员选取了声源定位(SSL)、视频物体分割(VOS)、显著性物体检测(SOD)任务上的各两个SOTA方法。

实验结果表明,视听分割在多个指标下取得了最佳结果。

△和来自相关任务方法进行视听分割的对比结果

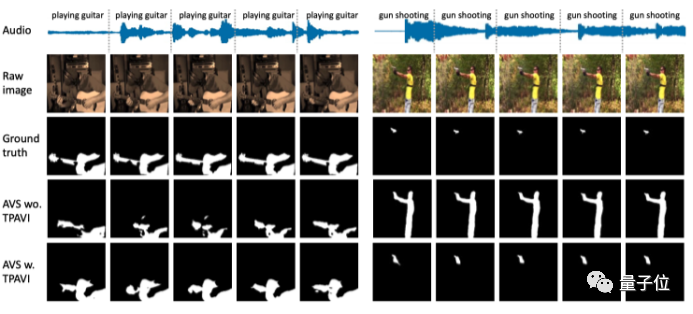

其次,研究人员进行了一系列消融实验,验证出,利用TPAVI模块,单声源和多声源设置下采用两种backbone的视听分割模型都能得到更大的提升。

△引入音频的TPAVI模块,可以更好地处理物体的形状细节(左图),并且有助于分割出正确的发声物(右图)

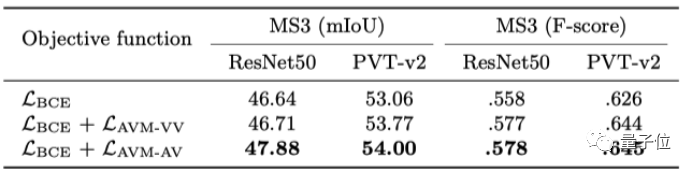

对于新任务的视听匹配损失函数,实验还验证了其有效性。

△视听匹配损失函数的有效性

One More Thing

文中还提到,AVSBench数据集不仅可以用于所提出的视听分割模型的训练、测试,其也可以用于验证声源定位模型。

研究人员在项目主页上表示,正在准备比AVSBench大10倍的AVSBench-v2。

一些视频的分割demo也上传在主页上。感兴趣的话可以前往查看~

论文地址:

https://arxiv.org/abs/2207.05042

GitHub地址:

https://github.com/OpenNLPLab/AVSBench

项目主页:

https://opennlplab.github.io/AVSBench/

边栏推荐

- 箭头函数和普通函数的常见区别

- [现代控制理论]6_稳定性_李雅普诺夫_Lyapunov

- MySQL查询性能优化七种武器之索引潜水

- The latest interview summary in 20022 brought by Ali senior engineer is too fragrant

- "Digital Economy Panorama White Paper" Special Analysis of Banking Industry Intelligent Marketing Application Released

- BISS绝对值编码器_TI方案_线路延迟补偿

- _main C:/ti/ccs1011/ccs/tools/compiler/ti-cgt-c2000_20.2.1.LTS/lib/rts2800_fpu32.lib<ar在线升级跳转疑问

- 学长告诉我,大厂MySQL都是通过SSH连接的

- 全面了解什么是TPS、QPS以及两者的区别

- 【Adobe Premiere Pro 2020】pr2020安装和基本操作【PR安装、新建项目流程、导入及管理素材项目文件、添加标记、创建出入点剪辑视频、快速剪接及自动音乐卡点的方法

猜你喜欢

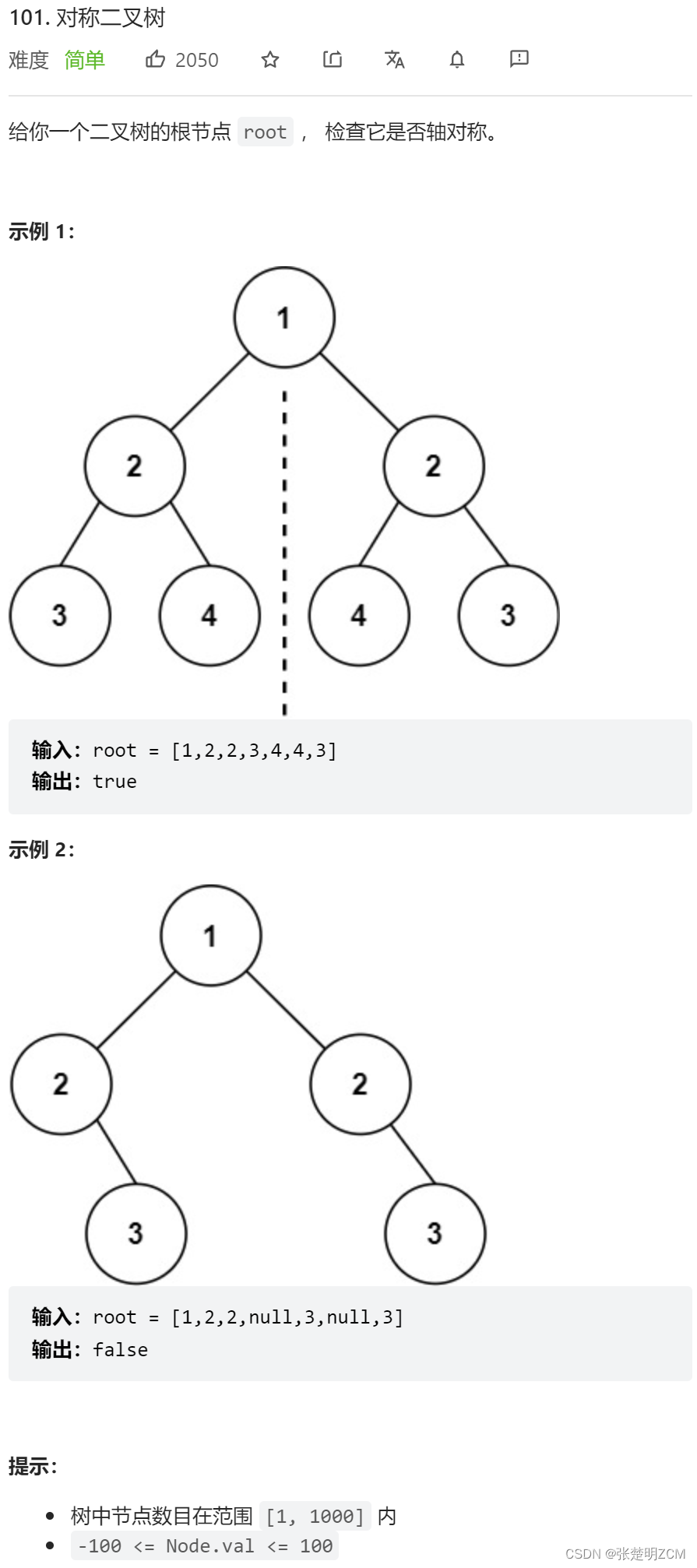

LeetCode #101. Symmetric Binary Tree

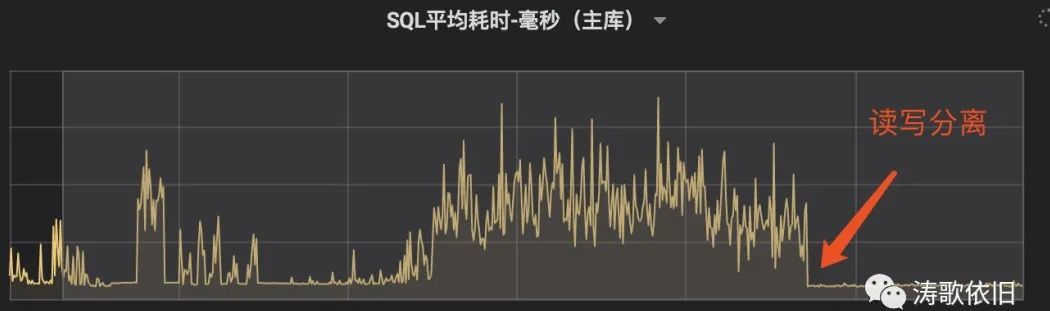

读写分离后,性能居然提升100%了呀

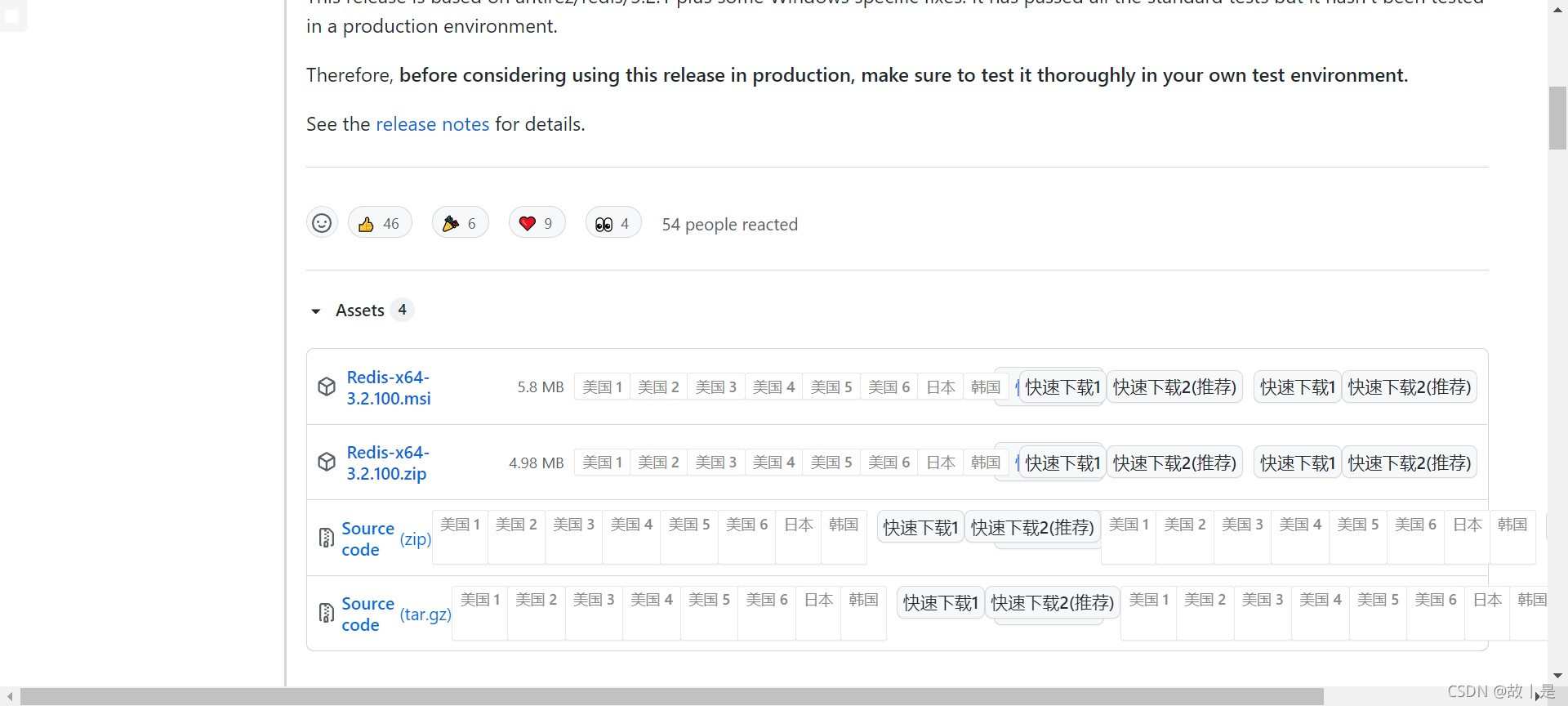

Redis的下载安装

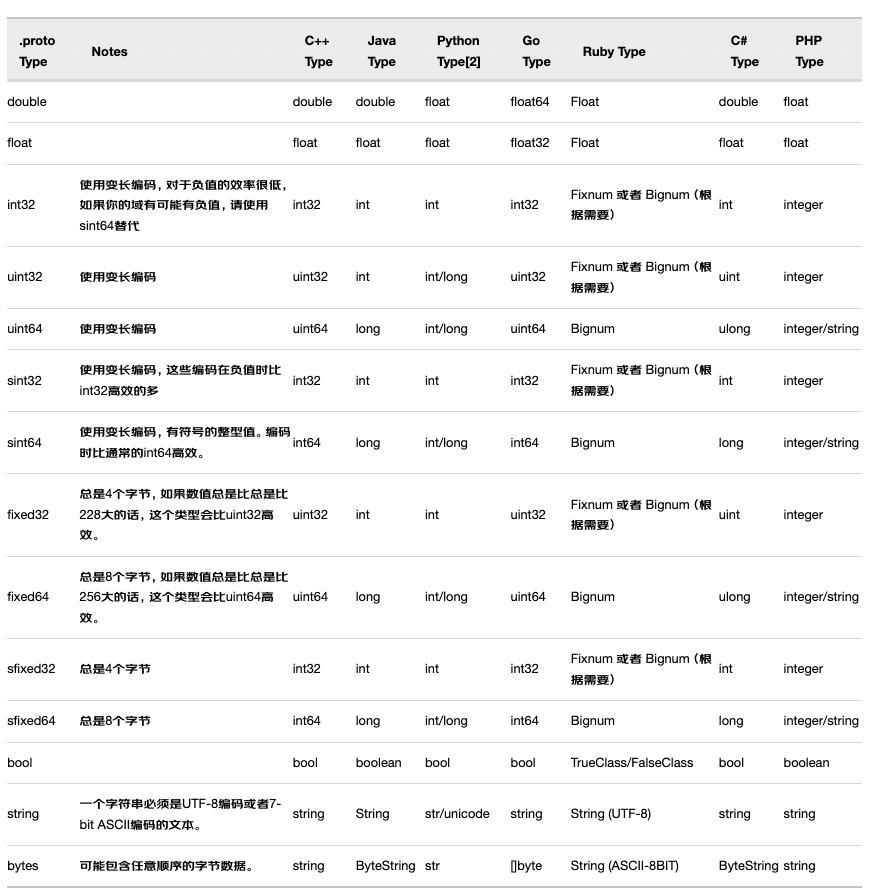

proto3-2语法

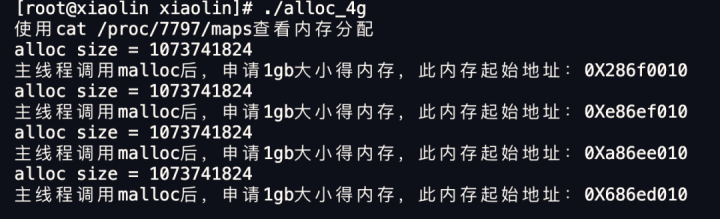

Here comes the question: Can I successfully apply for 8G memory on a machine with 4GB physical memory?

F280049库函数API编程、直接寄存器控制编程和混合编程方法

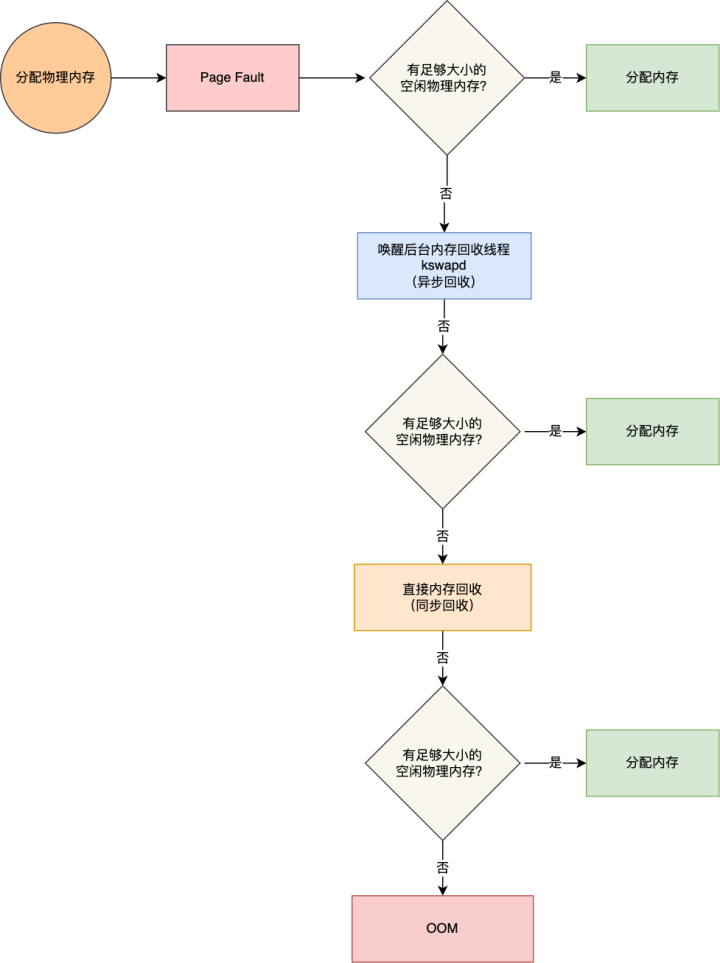

太卷了... 腾讯一面被问到内存满了,会发生什么?

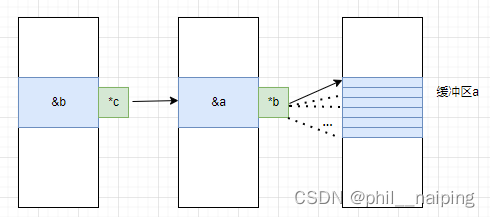

Double pointer - the role of char **, int **

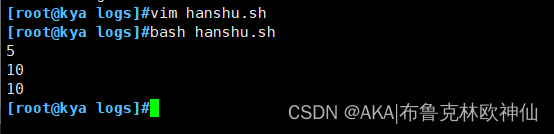

shell脚本------函数的格式,传参,变量,递归,数组

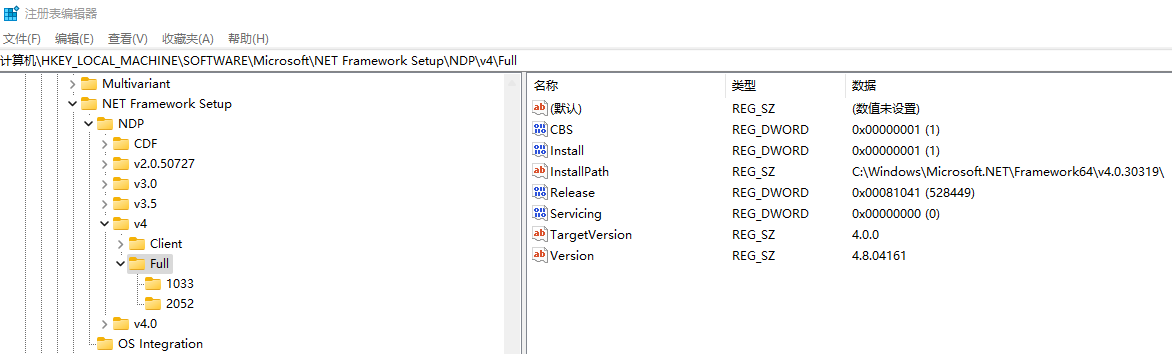

C# 获取系统已安装的.NET版本

随机推荐

微信一面:一致性哈希是什么,使用场景,解决了什么问题?

在北京参加UI设计培训到底怎么样?

LeetCode #101. 对称二叉树

Django cannot link mysql database

C# async 和 await 理解

网页控制台控制编辑框

阿里高工带来的20022最新面试总结太香了

Fapi_StatusType Fapi_issueProgrammingCommand使用注意事项

问题来了:4GB物理内存的机器上申请8G内存能成功吗?

元宇宙:下一代互联网启程(附元宇宙深度报告PDF)

专业人士使用的 11 种渗透测试工具

Experiment record: the process of building a network

OpenSSF的开源软件风险评估工具:Scorecards

研发需求的验收标准应该怎么写? | 敏捷实践

抗积分饱和 PID代码实现,matlab仿真实现

TIC2000调用API函数Flash擦除片上FLASH失败

The grep command Shell regular expressions, the three musketeers

LeetCode #101. Symmetric Binary Tree

WeChat payment development process

未来装备探索:数字孪生装备