当前位置:网站首页>Pytorch 固定部分参数训练

Pytorch 固定部分参数训练

2022-08-09 17:45:00 【为为为什么】

我们经常会用到预训练模型,并在预训练模型的基础上添加额外层。训练时先将预训练层参数固定,只训练额外添加的部分。本文记录 Pytorch 相关操作。

固定参数

- 固定参数即网络训练时不改变该部分的权重,而更新指定层的参数

- pytorch 固定参数主要通过两个设置完成

- 将

tensor的requires_grad属性设置为False仅将该属性设置为 False 网络仍会训练并修改参数,还需要堆 optimizer 的输入参数进行过滤 - 在

optimizer中过滤需要更新的变量

requires_grad

- 初始化变量时可以设置该值为 False

Variable(torch.randn(5,5),requires_grad=True)- 也可以手动设置模型中的层

for p in self.parameters():

p.requires_grad=Falseoptimizer

- 在 optimizer 的变量位置可以过滤需要更新的变量,得到迭代器:

optimizer.SGD (filter(lambda p:p.requires_grad,model.parameters()), lr=1e-3)操作示例

只训练部分层

class RESNET_attention(nn.Module):

def __init__(self, model, pretrained):

super(RESNET_attetnion, self).__init__()

self.resnet = model(pretrained)

for p in self.parameters():

p.requires_grad = False

self.f = nn.Conv2d(2048, 512, 1)

self.g = nn.Conv2d(2048, 512, 1)

self.h = nn.Conv2d(2048, 2048, 1)

self.softmax = nn.Softmax(-1)

self.gamma = nn.Parameter(torch.FloatTensor([0.0]))

self.avgpool = nn.AvgPool2d(7, stride=1)

self.resnet.fc = nn.Linear(2048, 10)- 这样就将 for 循环以上的参数固定, 只训练下面的参数。

- 注意需要在 optimizer 中添加上这样的一句话

filter(lambda p: p.requires_grad, model.parameters()。

optimizer = optim.Adam(filter(lambda p: p.requires_grad, model.parameters()), lr=0.0001, betas=(0.9, 0.999), eps=1e-08, weight_decay=1e-5)固定部分层参数

for k,v in model.named_parameters():

if k!='XXX':

v.requires_grad=False #固定参数检查部分参数是否固定

for k,v in model.named_parameters():

if k!='xxx.weight' and k!='xxx.bias' :

print(v.requires_grad) #理想状态下,所有值都是False查看可训练参数

for name, param in model.named_parameters():

if param.requires_grad:

print(name)查看网络总参数

net = Model()

print('# Model parameters:', sum(param.numel() for param in net.parameters()))不同层设置不同学习率

optim.SGD([

{'params': model.base.parameters()},

{params': model.classifier.parameters(),'lr':1e-3)],

lr=1e-2, momentum=0.9)这意味着 model.base 的参数将使用 1e-2 的默认学习率,model.classifier 的参数将使用 1e-3 的学习率,所有参数将使用 0.9 的动量。

PyTorch更新部分网络,其他不更新

- 假设有模型A和模型B,我们需要将A的输出作为B的输入,但训练时我们只训练模型B.那么可以这样做:

input_B = output_A.detach()- 它可以使两个计算图的梯度传递断开,从而实现我们所需的功能。

参考资料

边栏推荐

猜你喜欢

kakka rebalance解决方案

单片机编程-状态机

好的架构是进化来的,不是设计来的

A carnival of art and technology, cloud XR supports Anaya 2022 Sandbox Immersive Art Season

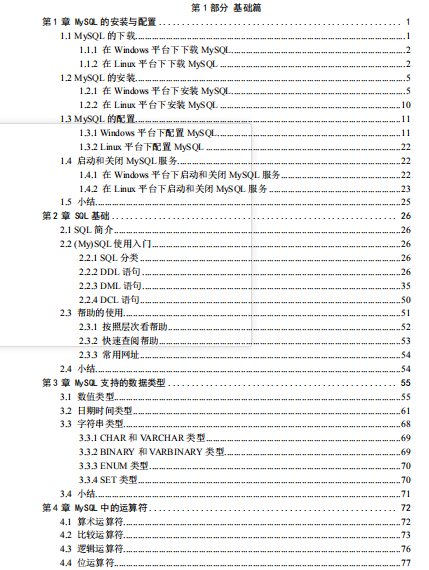

太厉害了!华为大牛终于把 MySQL 讲的明明白白(基础 + 优化 + 架构)

Wallys/QCA 9880/802.11ac Mini PCIe Wi-Fi Module, Dual Band, 2,4GHz / 5GHz advanced edition

华为发布「国产Copilot内核」PanGu-Coder,而且真的能用中文哦!

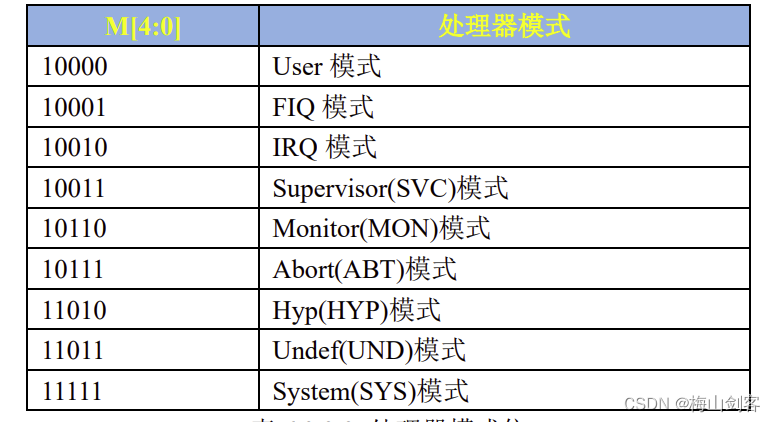

Cortex-A7 MPCore Architecture

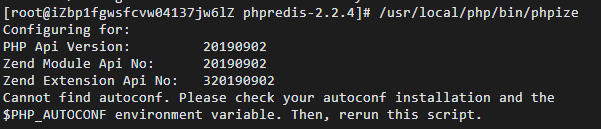

Linux上给PHP安装redis扩展

Detailed explanation of JVM memory model and structure (five model diagrams)

随机推荐

win10 uwp 手动锁Bitlocker

2022 全球 AI 模型周报

论文解读:Deep-4MCW2V:基于序列的预测指标,以鉴定大肠杆菌中的N4-甲基环胞嘧啶位点

IMX6ULL—汇编LED灯

JMeter压测时如何在达到给定错误数量后停止测试

【知识点合辑】numpy常用函数+jupyter小用法

不是吧,连公司里的卷王写代码都复制粘贴,这合理?

书单 | “推荐系统” 值得一读的五本书

程序健壮性

uniapp 实现底部导航栏tabbar

Linux上给PHP安装redis扩展

论文精读:VIT - AN IMAGE IS WORTH 16X16 WORDS: TRANSFORMERS FOR IMAGE RECOGNITION AT SCALE

字节二面:可重复读隔离级别下,这个场景会发生什么?

IMX6ULL—Assembly LED Lights

C语言知识补充

What is test development and why is it so popular now?

megacli磁盘阵列

URLError: <urlopen error [Errno 11004] getaddrinfo failed>调用seaborn-data无法使用

李乐园:iMetaLab Suite宏蛋白质组学数据分析与可视化(视频+PPT)

Ng DevUI 周下载量突破1000啦!