当前位置:网站首页>pyspark columns merge into one row

pyspark columns merge into one row

2022-08-10 18:19:00 【51CTO】

将 dataframe 利用 pyspark 列合并为一行,类似于 sql 的 GROUP_CONCAT 函数.例如如下 dataframe :

Need according to the same row d 将 s 合并,想要的结果为:

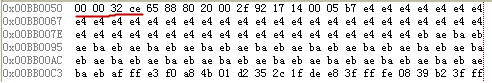

利用 groupby 去实现就好,spark 里面可以用 concat_ws 实现,可以看这个 Spark中SQL列合并为一行,而这里的 concat_ws The merger of strange, 官方文档的实例为:

The authors attempt to get:

不是想要的效果.而 collect_list 能得到相同的效果:

得到的结果为:

如果需要collect_list多列,那么可以这么写:

得到的结果为:

边栏推荐

- 痛苦的四大原因

- go语言的性能基准测试、性能优化测试和性能调优

- R语言ggplot2可视化:使用ggpubr包的ggscatter函数可视化分组散点图、stat_mean函数在分组数据点外侧绘制凸包并突出显示分组均值点、自定会均值点的大小以及透明度

- 测试接口出现“data“: “Full authentication is required to access this resource“凭证已过期

- 机器人控制器编程整理汇总-辞旧迎新-

- 三坐标雷达显示软件 SPx Viewer-3D

- 破解校园数字安全难点,联想推出智慧教育安全体系

- R语言检验时间序列的平稳性:使用fUnitRoots包中的adfTest函数检验时间序列数据是否具有平稳性(设置参数type为nc时、既不去除趋势也不进行中心化处理)

- CSV(Comma-Separate-Values)逗号分隔值文件

- Interpretation of ZLMediaKit server source code---RTSP push and pull

猜你喜欢

Wuling Hongguang MINI EV, the only drawback is safety

Toronto Research Chemicals农药检测丨Naled-d6

【2011】【论文笔记】用THz-TDS观察水树——

直播回顾|多云时代,如何建设企业级云管理平台?(附建设指南下载)

FFmpeg extract H264 nalu from the mp4

瑞虎8 PRO产品性能分析,一文读懂究竟何为“全域动力科技旗舰”

兼具外观、性能、屏幕!华硕灵耀X 14火热抢购中

基于AWS构建云上数仓第二步:AWS常见服务简介

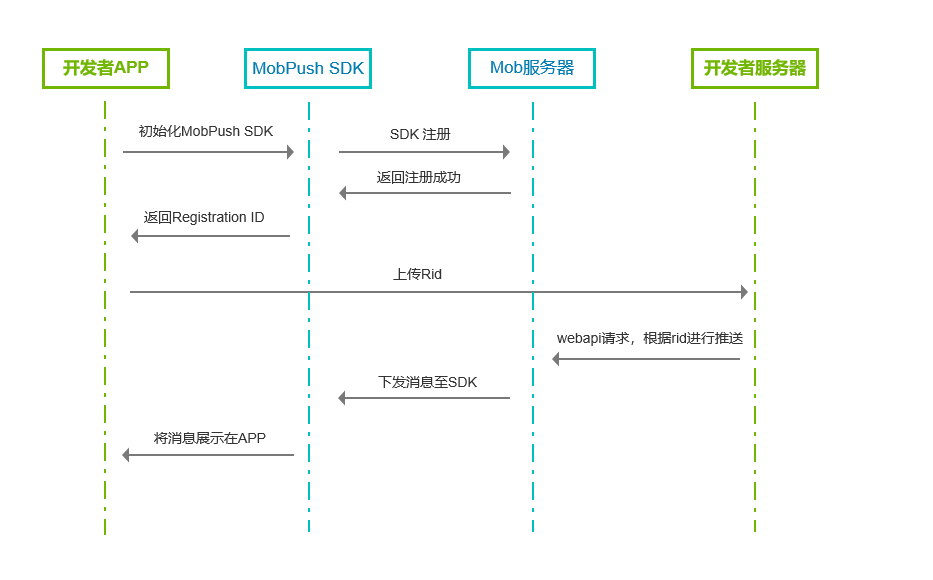

产品说明丨Android端使用MobPush快速集成方法

Toronto Research Chemicals 对乙酰氧基苯乙酮说明书

随机推荐

Your local docbook2man was found to work with SGML rather than XML

Selenium - 如何操作鼠标进行悬停、右击、双击、拖拽?

【HMS core】【FAQ】Analytics Kit、Push Kit典型问题合集3

Toronto Research Chemicals 双(乙酰丙酮)铂(II)

FFmpeg Huaping solution (modify source code, discard incomplete frames)

容器化 | 在 S3 实现定时备份

函数柯里化(curry)

redis分布式锁

Making Pre-trained Language Models Better Few-Shot Learners

WebRTC source code analysis nack detailed explanation

Go 语言快速入门指南:第四篇 与数据为舞之数组

【数据存储精讲】整型和浮点型有什么区别?为什么会精度丢失?

Toronto Research Chemicals萜烯分析丨反式植物醇

期货开户手续费加1分已经是常态

老板加薪!看我做的WPF Loading!!!

瑞虎8 PRO产品性能分析,一文读懂究竟何为“全域动力科技旗舰”

21天打卡挑战学习MySQL——《MySQL表管理》第二周 第五篇

接口测试进阶接口脚本使用—apipost(预/后执行脚本)

6月各手机银行活跃用户较快增长,创半年新高

基于AWS构建云上数仓第二步:AWS常见服务简介