当前位置:网站首页>《论文阅读》PLATO: Pre-trained Dialogue Generation Model with Discrete Latent Variable

《论文阅读》PLATO: Pre-trained Dialogue Generation Model with Discrete Latent Variable

2022-08-10 14:07:00 【365JHWZGo】

《论文阅读》PLATO: Pre-trained Dialogue Generation Model with Discrete Latent Variable

数据集:多轮对话数据集

外加标签:无

模型:预训练模型(在对话语料上)

时间:2019年

本文带来Siqi Bao, Huang He, Fan Wang, Hua Wu and Haifeng Wang共同创作的文章

简介

预训练模型已被证明对广泛的自然语言处理任务有效。受此启发,我们提出了一种新颖的对话生成预训练框架来支持各种对话,包括闲聊、基于知识的对话和对话式问答。在这个框架中,我们采用灵活的注意力机制来充分利用双向上下文和语言生成的单向特性。我们还引入了离散潜在变量来解决响应生成中固有的一对多映射问题。响应生成和潜在行为识别这两个交互任务在共享网络中同时设计和执行。对三个公开可用的数据集的综合实验验证了所提出框架的有效性和优越性。

边栏推荐

- CodeForces - 811A

- 这一次,话筒给你:向自由软件之父斯托曼 提问啦!

- A method that can make large data clustering 2000 times faster

- Lack of comparators, op amps come to the rescue!(Op amp is recorded as a comparator circuit)

- awk的简单使用

- leetcode 739. Daily Temperatures Daily Temperatures (Moderate)

- @RequestBody的使用[通俗易懂]

- MySQL interview questions

- C#实现访问OPC UA服务器

- 日志@Slf4j介绍使用及配置等级

猜你喜欢

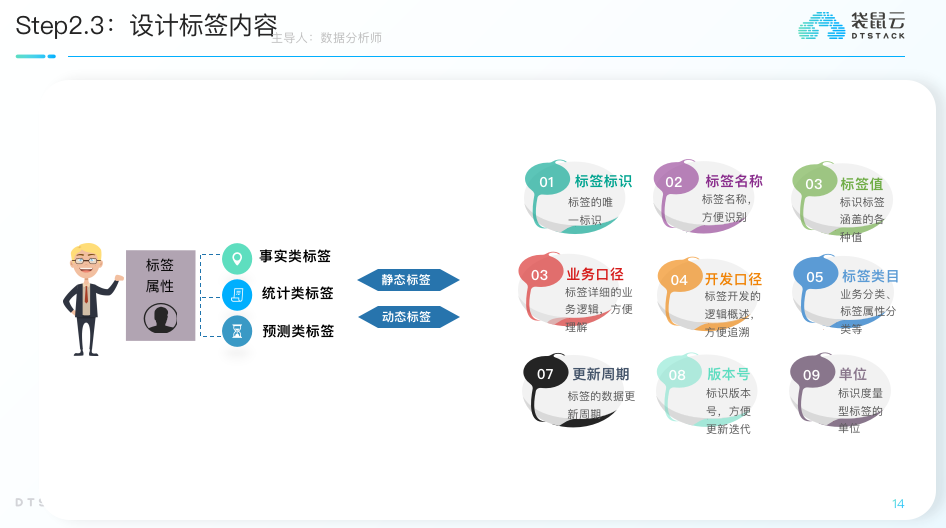

从洞察到决策,一文解读标签画像体系建设方法论

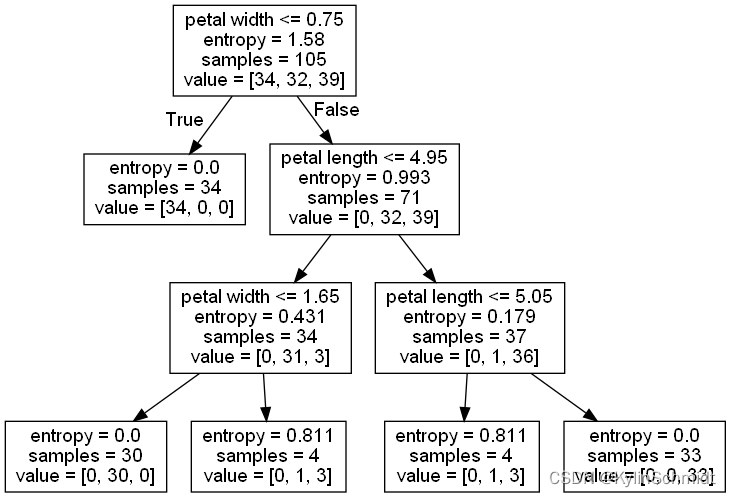

使用决策树对鸢尾花进行分类

这一次,话筒给你:向自由软件之父斯托曼 提问啦!

![[JS Advanced] Creating sub-objects and replacing this_10 in ES5 standard specification](/img/3e/14a1d7c2837c896eaa0ca625eaa040.png)

[JS Advanced] Creating sub-objects and replacing this_10 in ES5 standard specification

![[target detection] small script: extract training set images and labels and update the index](/img/9d/0f88b484cee1b85df6bc1153d9b6b4.png)

[target detection] small script: extract training set images and labels and update the index

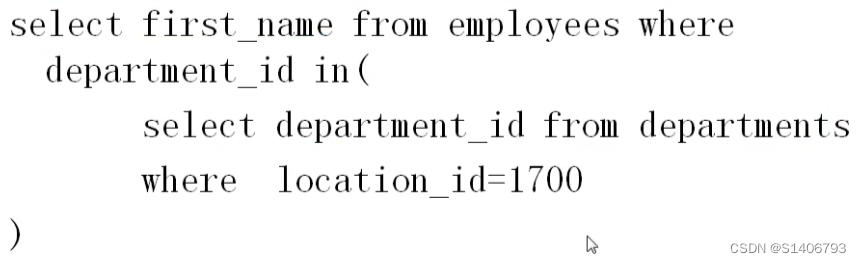

SQL学习(基础)

Error: Rule can only have one resource source (provided resource and test + include + exclude)

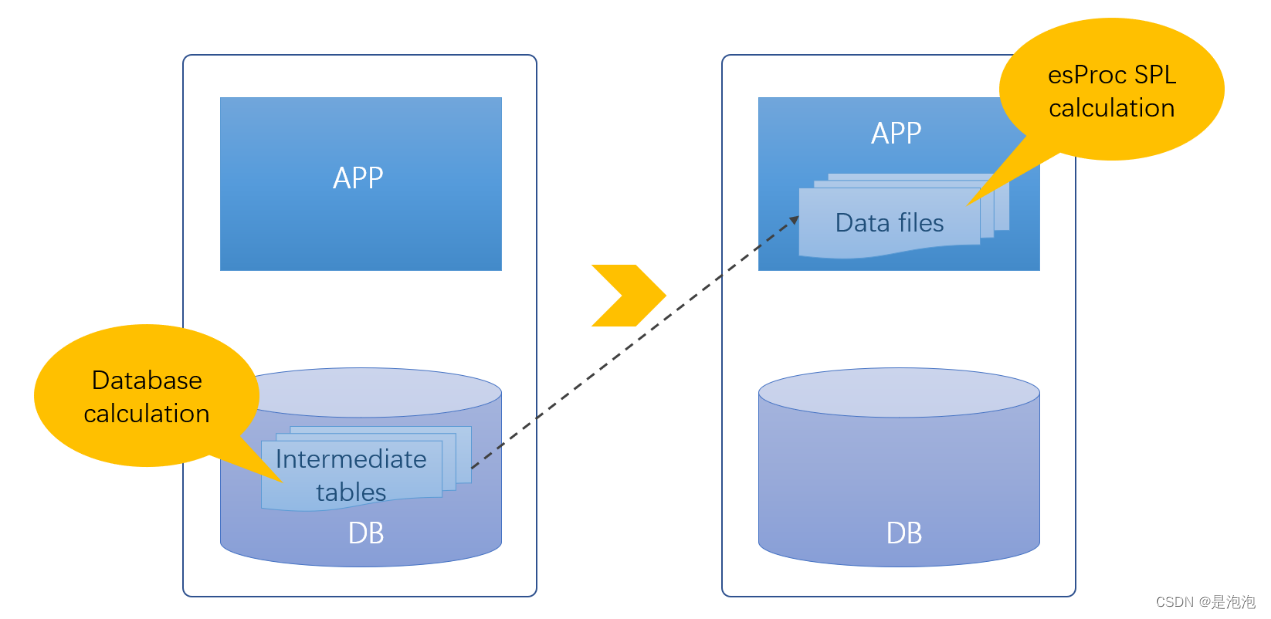

Open source SPL wipes out tens of thousands of database intermediate tables

使用mysq语句操作数据库

注意力模型---Attention Model

随机推荐

2012年下半年 系统架构设计师 下午试卷 II

usb转rs485测试软件,usb转rs485「建议收藏」

data product manager

领域驱动实践总结(基本理论总结与分析V+架构分析与代码设计+具体应用设计分析)

什么?你还不会JVM调优?

锂电池技术

vivado闪退或者message无显示

A can make large data clustering method of 2000 times faster, don't poke

d为何用模板参数

记录几道整型提升的题目

系统的安全和应用(不会点安全的东西你怎么睡得着?)

Redis上云迁移实践

日志@Slf4j介绍使用及配置等级

学习日记8

the height of the landscape

sql语句 异常 Err] 1064 – You have an error in your SQL syntax; check the manual that corresponds to your

C#实现访问OPC UA服务器

开源SPL消灭数以万计的数据库中间表

Existing in the rain of PFAS chemical poses a threat to the safety of drinking water

FPN详解