随着越来越多的机器学习应用场景的出现,而现有表现比较好的监督学习需要大量的标注数据,标注数据是一项枯燥无味且花费巨大的任务,所以迁移学习受到越来越多的关注。本次论文分享介绍了三篇基于迁移学习的论元关系提取。

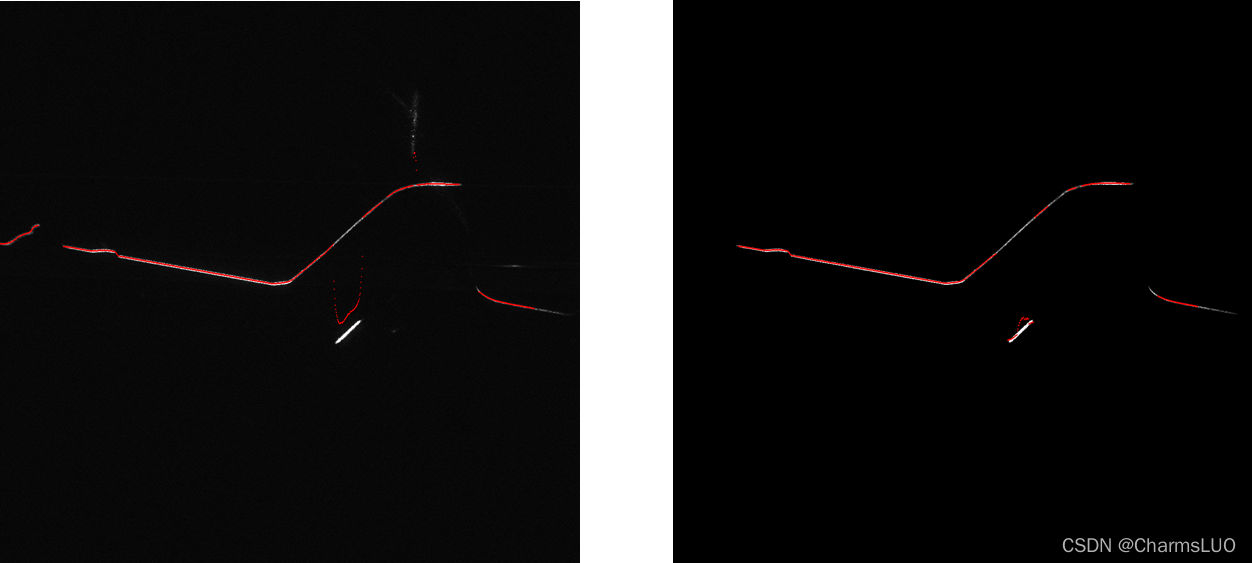

数据概览

基于迁移学习和主动学习的论元关系提取(Efficient Argument Structure Extraction with Transfer Learning and Active Learning)

论文地址:https://arxiv.org/pdf/2204.00707

该篇文章针对提取论元关系提出了基于Transformer的上下文感知论元关系预测模型,该模型在五个不同的领域中显著优于依赖特征或仅编码有限上下文的模型。为了解决数据标注的困难,作者通过迁移学习利用现有的注释好的数据来提高新目标域中的模型性能,以及通过主动学习来识别少量样本进行注释。

一个用于集成论辩挖掘任务的大规模数据集(IAM: A Comprehensive and Large-Scale Dataset for Integrated Argument Mining Tasks)

论文地址:https://arxiv.org/pdf/2203.12257

该篇文章为了使论辩中繁琐的过程自动化,提出了一个大规模数据集IAM,该数据集可用于一系列论辩挖掘任务,包括主张提取、立场分类、证据提取等。之后进一步提出了与论辩准备过程相关的两个新的论辩挖掘任务:(1)基于立场分类的主张提取,(2)主张-证据对提取。对每个集成任务分别采用流水线方法和端到端方法进行试验。

社会讨论中的无监督知识迁移有助于论辩挖掘吗?(Can Unsupervised Knowledge Transfer from Social Discussions Help Argument Mining?)

论文地址:https://arxiv.org/pdf/2203.12881

虽然基于Transformer的预训练语言模型可以在许多NLP任务中取得最好的结果,但是标注数据的缺乏和论证高度依赖领域的本质限制了此类模型的性能。文章提出了一种迁移学习的策略来解决,利用CMV做为数据集,微调选择性掩码语言模型,并且提出了基于prompt的策略来预测论元间的关系。