当前位置:网站首页>Pytorch GPU模型推理时间探讨

Pytorch GPU模型推理时间探讨

2022-08-10 16:37:00 【pip install USART】

前言

最近对pytorch的模型推理(inference)时间产生了兴趣,于是想着写一个小程序来观察一下现象。遂以此文记之。

实验配置

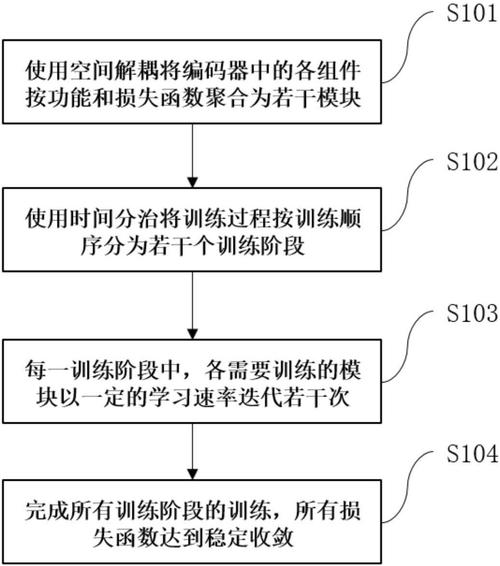

主要思路:

- 创建多个不同规格的模型,每个模型只有一个简单的卷积层。

- 以卷积的各种不同参数作为模型的区别。

- 以随机数来生成一批数据,用***[B,C,W,H]***来表示。

- 每个模型进行100次推理,分10批次完成,记录这10批次的时间和平均时间。

硬件配置

影响一个模型的推理速度的硬件应该主要就是这些了,还有一个带宽问题。

显卡:RTX 2080ti

内存:16G 2666MHz

CPU:Intel i5-9400F

系统:win10

主板:忘了

实验结果

具体的网络规格这里就略去了,都是随便举的例子,没啥信息量。直接看结果吧。

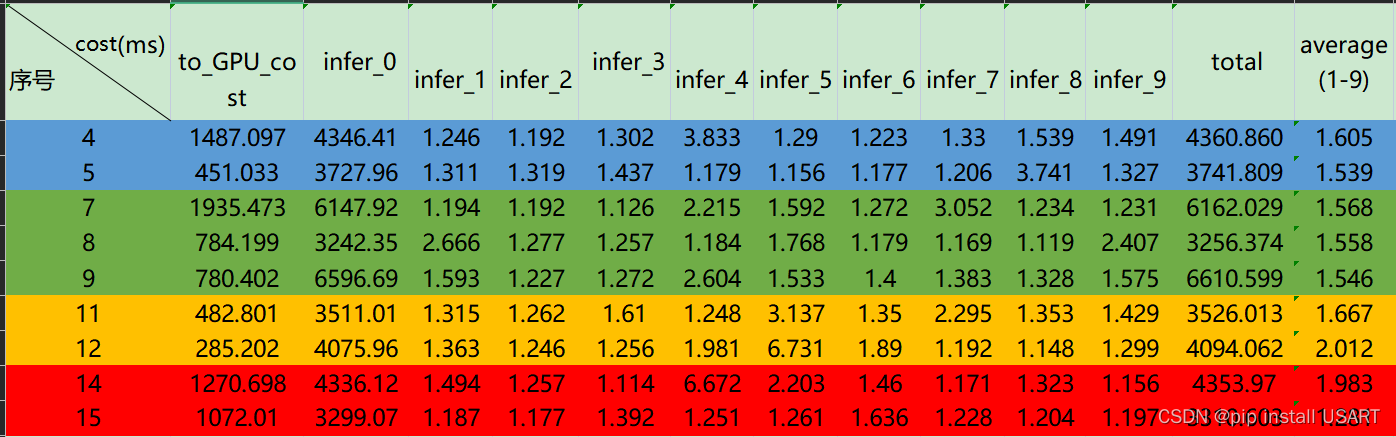

如上图所示,其中的序号表示模型序号,可以得到几个现象:

1.每个模型的每轮10次推理中,第一轮总是相对来说很慢的

2.这些模型的平均推理时间相差不大,也就是还没达到显卡的算力门槛。

3.平均推理时间相差不大的情况下,to_GPU_cost的区别较大。

解释与猜想

理论上每次推理时间应该是一样的,但就表格数据来看,1-9次的区别有些也很大。

这一现象可能是由于计时方法产生的,所用计时方法是time库的perf_counter方法,该方法是由CPU来执行的,而显卡计算后通知CPU,这之间还有通信差距。

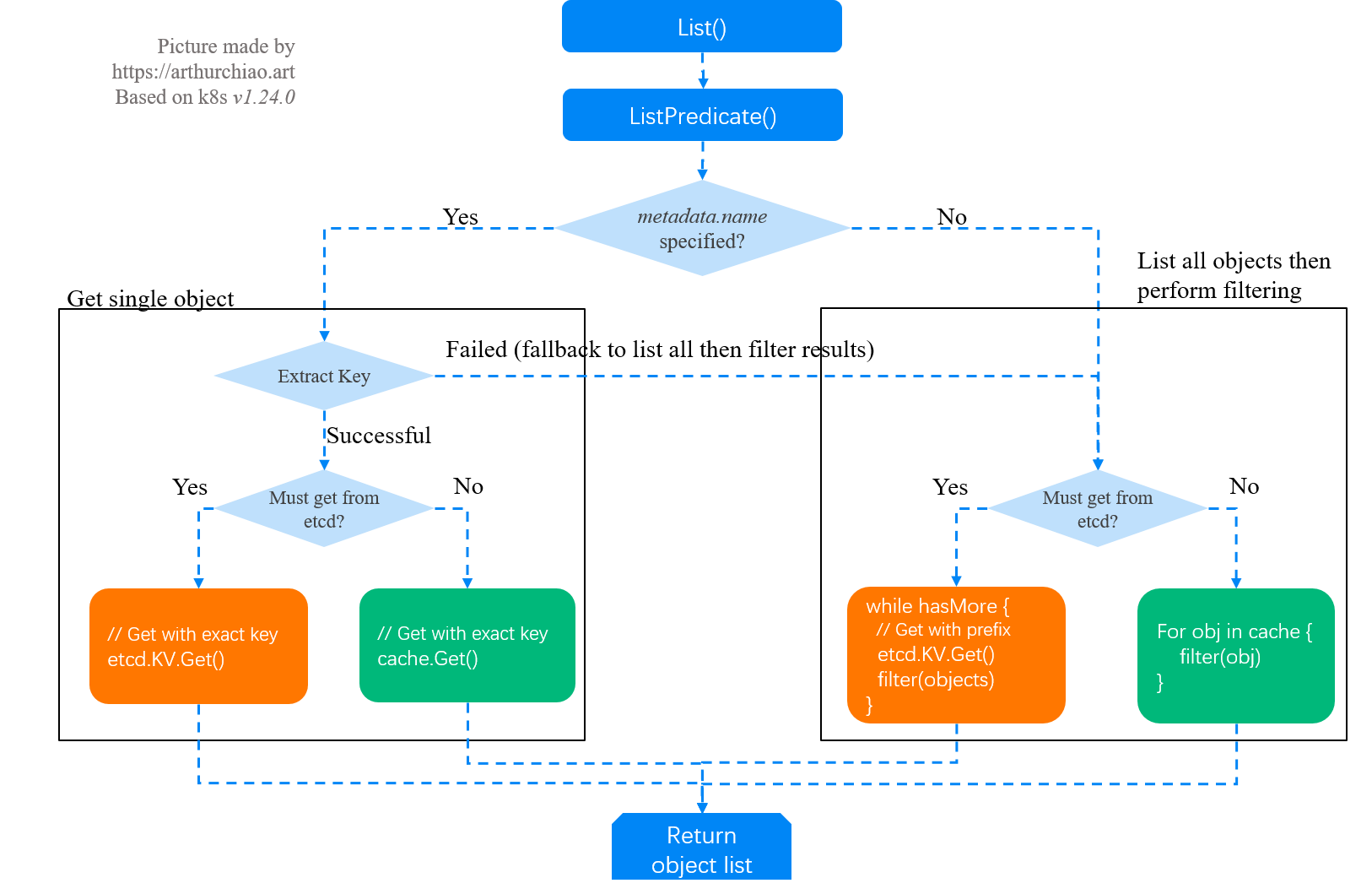

每次的第一轮推理都很慢可能是因为GPU第一次做推理需要进行模型参数的初始化。

中间还有一个小插曲,一开始我是在一个py程序里多次调用testModel这个方法,不同的模型作为参数传递进去,但是发现只有第一次调用时(也就是第一个模型的第一轮10次推理)才会用那么多时间,于是我改了一下代码,将模型参数作为main的参数,重写了一个bat(windows的批处理文件)来依次执行多个模型。

暂时先记录到这里,目前已经有了初步的认识,等后续再进一步研究研究

边栏推荐

- I met a 25k+ from Tencent, he let me see what kind of basic ceiling

- MySQL的使用演示及操作,MySQL数据字符集的设置

- JWT 实现登录认证 + Token 自动续期方案

- 【荣耀智慧服务】快捷服务开发指南

- 让页面滚动到指定位置

- C专家编程 第10章 再论指针 10.7 使用指针创建和使用动态数组

- How to realize full backup and incremental backup of MySQL database

- FTXUI基础笔记(hello world)

- How to use bitwise operators in C language

- shell中判断文件目录是否存在

猜你喜欢

随机推荐

数据可视化:Metabase

C语言按位运算符如何使用

Redis存储验证码

如何搭建知识库,让您的内容更丰富?

【硬件架构的艺术】学习笔记(4)流水线的艺术

shell中判断文件目录是否存在

shell获取前n天的日期

自助服务知识库是什么?

C专家编程 第10章 再论指针 10.6 使用指针从函数返回一个数组

解决mpi4py导入报错ImportError: libmpi.so.40: cannot open shared object file: No such file or directory

华为-求int型正整数在内存中存储时1的个数

年薪60万+?这份10万字的面试突击宝典涵盖阿里 P5 工程师~P7 所有技术栈

WIZnet 物联网设计大赛 - WizFi360大赛延迟通知

I met a 25k+ from Tencent, he let me see what kind of basic ceiling

LeetCode-922. Sort Array By Parity II

PC软件问题二[Win10系统将UltraEdit添加到右键菜单的方法]

轮询以及webSocket与socket.io原理

MySQL数据库完全备份与增量备份怎么实现

华为-坐标移动

LeetCode-1. Two Sum

![PC软件问题二[Win10系统将UltraEdit添加到右键菜单的方法]](/img/4f/f3856e135302bcf5902bf987b7ed4d.png)