当前位置:网站首页>CVPR2022 | 基于知识蒸馏的高效预训练

CVPR2022 | 基于知识蒸馏的高效预训练

2022-04-23 21:44:00 【智源社区】

论文链接:https://arxiv.org/abs/2203.05180

版权声明

本文为[智源社区]所创,转载请带上原文链接,感谢

https://hub.baai.ac.cn/views/16630

边栏推荐

- Some thoughts on super in pytorch, combined with code

- setInterval、setTimeout、requestAnimationFrame

- ROS学习笔记-----ROS的使用教程

- [leetcode refers to offer 47. Maximum value of gift (medium)]

- Detailed explanation of basic assembly instructions of x86 architecture

- Question brushing plan - depth first search (II)

- Centos7 builds MySQL master-slave replication from scratch (avoid stepping on the pit)

- Assertionerror: invalid device ID and runtimeerror: CUDA error: invalid device ordinal

- Minecraft 1.12.2模组开发(四十三) 自定义盾牌(Shield)

- 危机即机遇,远程办公效率为何会提升?

猜你喜欢

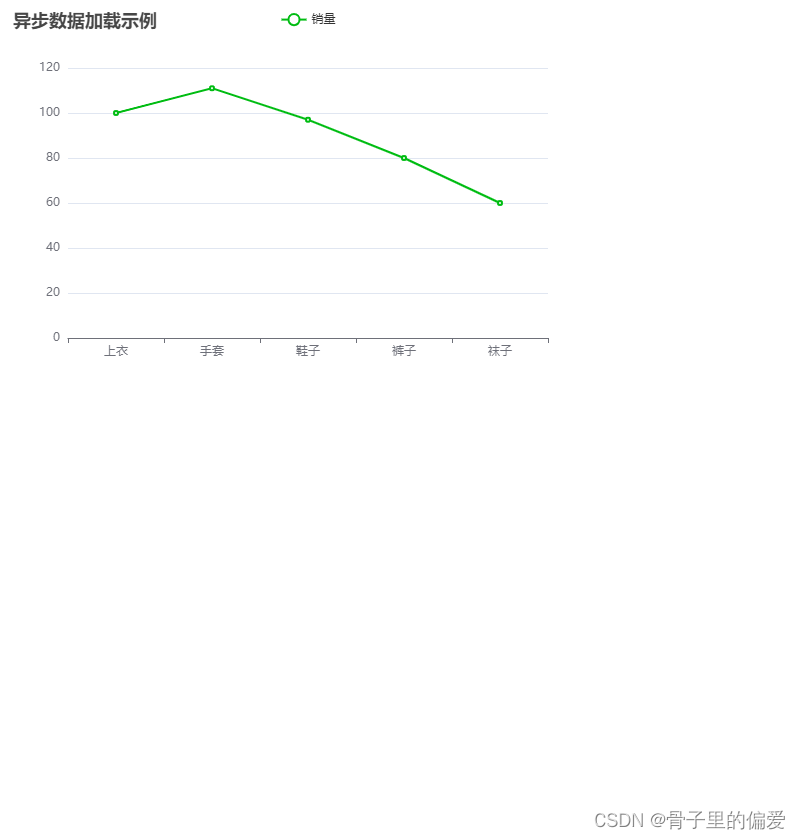

thinkphp5+数据大屏展示效果

![[leetcode sword finger offer 10 - II. Frog jumping steps (simple)]](/img/ab/698810f6fe169adffc3bec5e0dc13f.png)

[leetcode sword finger offer 10 - II. Frog jumping steps (simple)]

一文解决浏览器跨域问题

![[※ leetcode refers to offer 48. The longest substring without repeated characters (medium)]](/img/fa/99b64267fd890c6c40847548f077b3.png)

[※ leetcode refers to offer 48. The longest substring without repeated characters (medium)]

![[leetcode refers to offer 52. The first common node of two linked lists (simple)]](/img/bc/cd9c6ec29ecfef74940200e196aed3.png)

[leetcode refers to offer 52. The first common node of two linked lists (simple)]

Flomo software recommendation

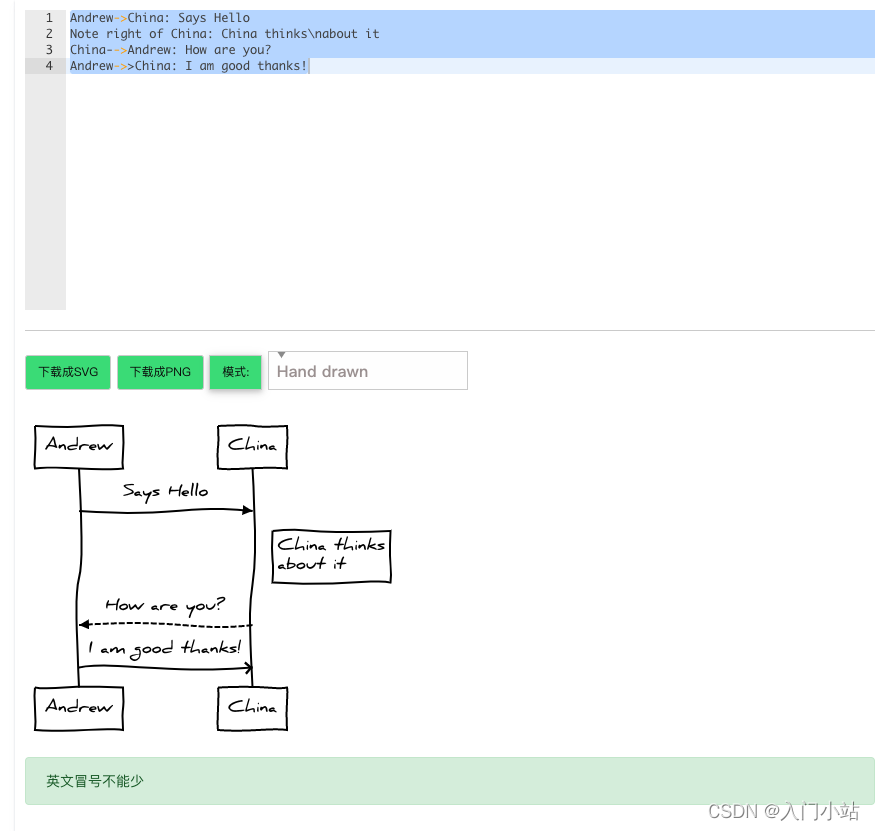

在线时序流程图制作工具

1. Finishing huazi Mianjing -- 1

2. Finishing huazi Mianjing -- 2

随机推荐

DW basic tutorial (I)

Use 3080ti to run tensorflow GPU = 1 X version of the source code

[leetcode refers to offer 25. Merge two sorted linked lists (simple)]

C reads excel specific data into specific columns of DataGridView

How to make Jenkins job run automatically after startup

DeNO 1.13.2 release

Some thoughts on super in pytorch, combined with code

Sklearn function: Train_ Test_ Split (split training set and test set)

[leetcode refers to offer 32 - III. print binary tree III from top to bottom (medium)]

Problem brushing plan -- dynamic programming (III)

DW basic course (II)

Thinking after learning to type

Detailed explanation of basic assembly instructions of x86 architecture

[leetcode sword finger offer 10 - II. Frog jumping steps (simple)]

Reference of custom message in ROS function pack failed

Introduction to tensorrt

Leaf Smecta

Plato Farm元宇宙IEO上线四大,链上交易颇高

Question brushing plan - depth first search DFS (I)