当前位置:网站首页>【机器学习】降维代码练习

【机器学习】降维代码练习

2022-08-09 07:17:00 【51CTO】

本课程是中国大学慕课《机器学习》的“降维”章节的课后代码。

课程地址:

https://www.icourse163.org/course/WZU-1464096179

课程完整代码:

https://github.com/fengdu78/WZU-machine-learning-course

代码修改并注释:黄海广,[email protected]

Principal component analysis(主成分分析)

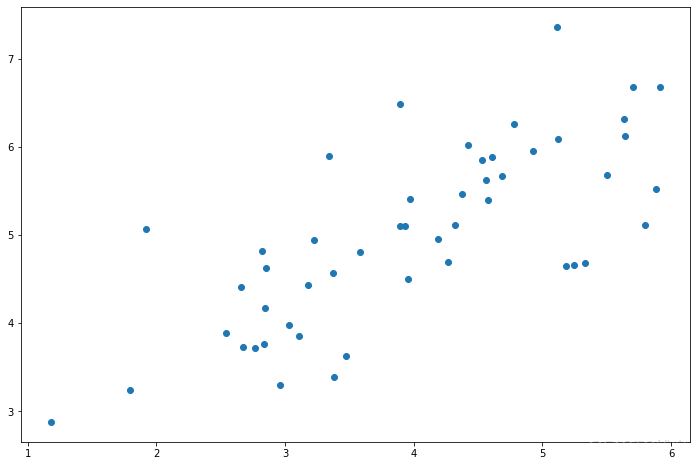

PCA是在数据集中找到“主成分”或最大方差方向的线性变换。它可以用于降维。在本练习中,我们首先负责实现PCA并将其应用于一个简单的二维数据集,以了解它是如何工作的。我们从加载和可视化数据集开始。

X1 | X2 | |

0 | 3.381563 | 3.389113 |

1 | 4.527875 | 5.854178 |

2 | 2.655682 | 4.411995 |

3 | 2.765235 | 3.715414 |

4 | 2.846560 | 4.175506 |

PCA的算法相当简单。在确保数据被归一化之后,输出仅仅是原始数据的协方差矩阵的奇异值分解。

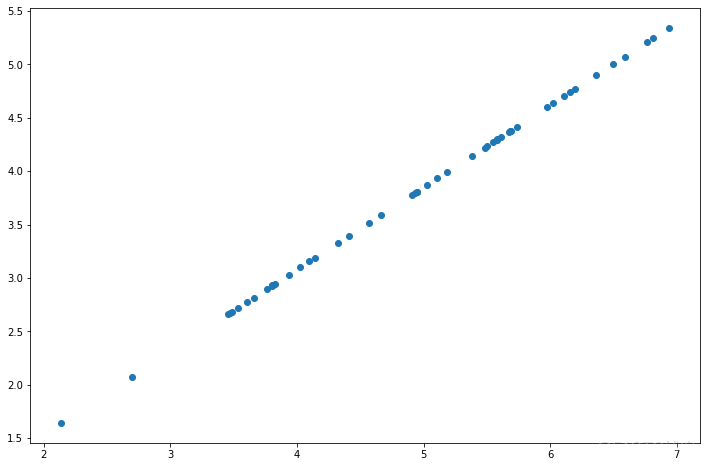

现在我们有主成分(矩阵U),我们可以用这些来将原始数据投影到一个较低维的空间中。对于这个任务,我们将实现一个计算投影并且仅选择顶部K个分量的函数,有效地减少了维数。

我们也可以通过反向转换步骤来恢复原始数据。

请注意,第一主成分的投影轴基本上是数据集中的对角线。当我们将数据减少到一个维度时,我们失去了该对角线周围的变化,所以在我们的再现中,一切都沿着该对角线。

我们在此练习中的最后一个任务是将PCA应用于脸部图像。通过使用相同的降维技术,我们可以使用比原始图像少得多的数据来捕获图像的“本质”。

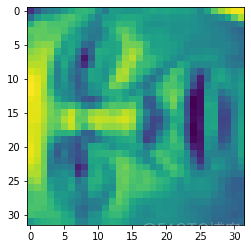

练习代码包括一个将渲染数据集中的前100张脸的函数。而不是尝试在这里重新生成,您可以在练习文本中查看他们的样子。我们至少可以很容易地渲染一个图像。

看起来很糟糕。这些只有32 x 32灰度的图像(它也是侧面渲染,但我们现在可以忽略)。我们的下一步是在面数据集上运行PCA,并取得前100个主要特征。

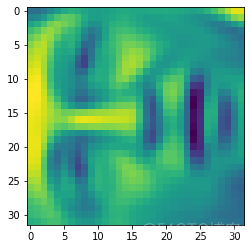

现在我们可以尝试恢复原来的结构并再次渲染。

我们可以看到:数据维度减少,但细节并没有怎么损失。

参考

- Prof. Andrew Ng. Machine Learning. Stanford University

边栏推荐

猜你喜欢

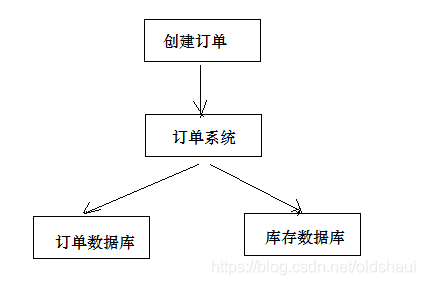

什么是分布式事务

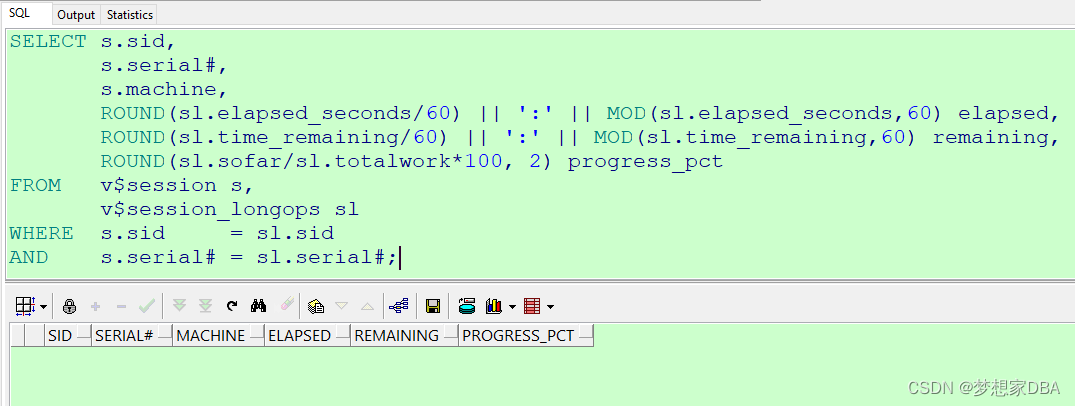

Flexible and easy-to-use sql monitoring script part7

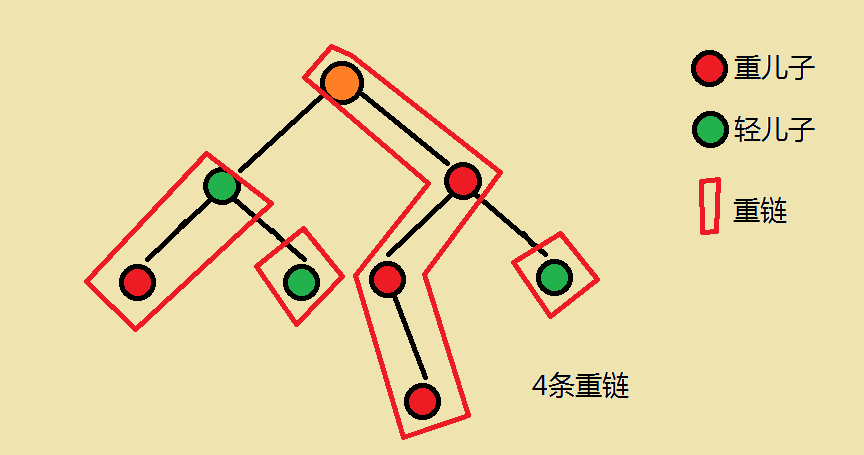

【Template】Tree Chain Segmentation P3384

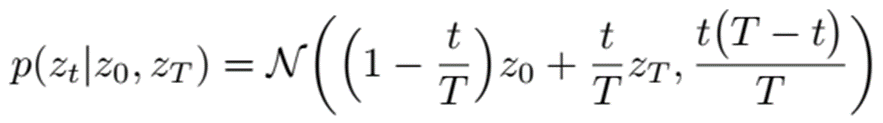

基于布朗运动的文本生成方法-LANGUAGE MODELING VIA STOCHASTIC PROCESSES

c语言位段

Tkinter可以选择的颜色

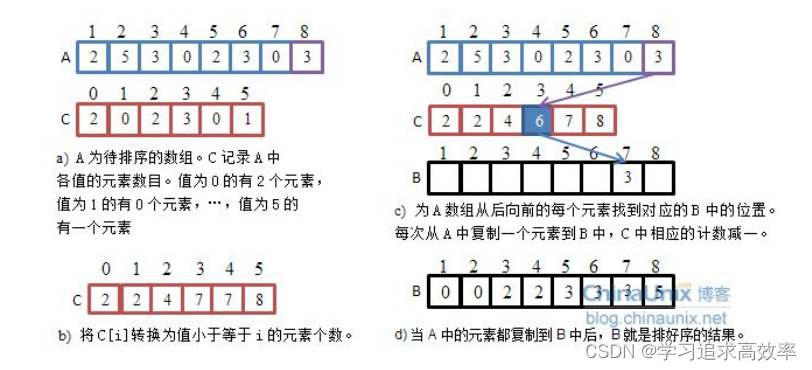

(本章节完结)排序第五节——非比较排序(计数排序+基数排序+桶排序)(附有自己的视频讲解)

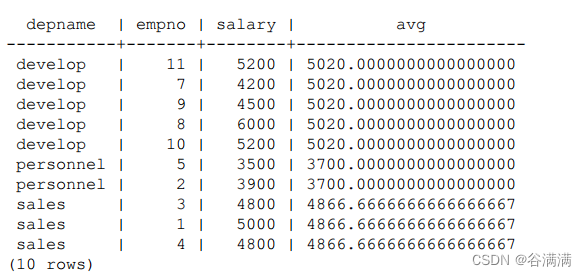

postgresql窗口功能

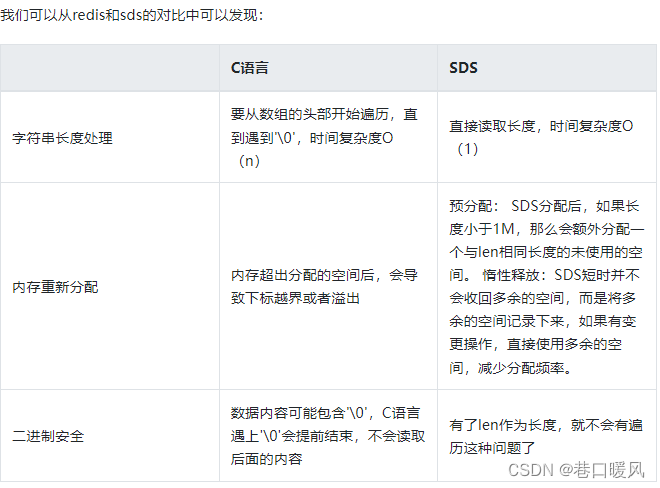

redis学习笔记

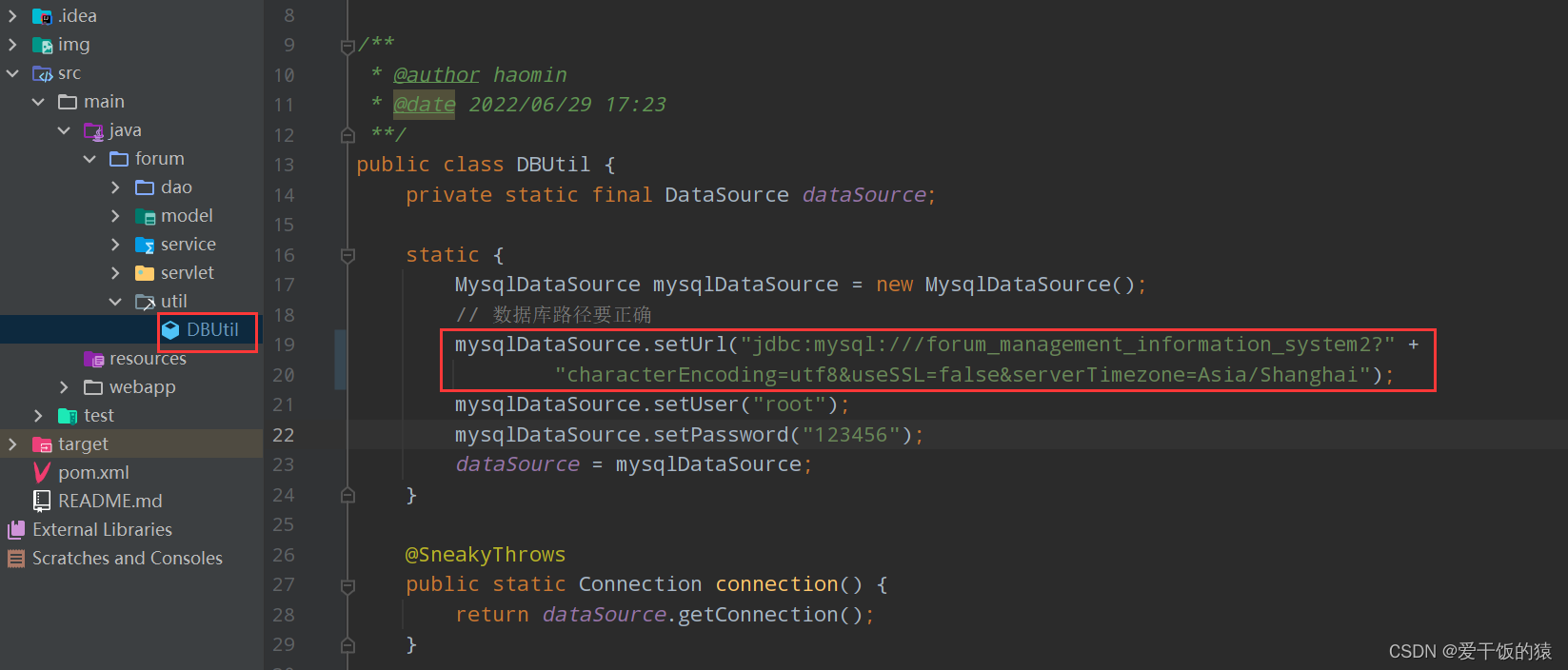

【报错】Root Cause com.mysql.jdbc.exceptions.jdbc4.CommunicationsException: Communications link failure

随机推荐

【修电脑】系统重装但IP不变后VScode Remote SSH连接失败解决

list与string转换

Learning Notes---Machine Learning

链表专项练习(三)

es6 基础知识详解 变量 字符串 解构赋值 函数 对象 从入门到精通

【转载】Deep Learning(深度学习)学习笔记整理

低成本、大容量、高交互…Polkadot 引领 GameFi 实现新突破

rsync:recv_generator: mkdir (in backup) failed:Permission denied (13) |failed to set times on '.'

类和结构体

常见的分布式事务解决方案

【模板】树链剖分 P3384

bzoj 5333 [Sdoi2018]荣誉称号

物理层课后作业

list and string conversion

MUV LUV EXTRA 2019CCPC秦皇岛站J题 KMP

stm32定时器之简单封装

高项 04 项目整体管理

当酷雷曼VR直播遇上视频号,会摩擦出怎样的火花?

TCP段重组PDU

Lottie系列二:高级属性