当前位置:网站首页>机器学习--线性回归(Linear Regression)

机器学习--线性回归(Linear Regression)

2022-08-09 10:15:00 【AI_孟菜菜】

线性回归:

- 最小二乘法:

- 从概率角度来看

- 线性回归正则化(L1,L2)

首先我们来看一个数据:

有这么一组样本点,线性回归就是找出一条拟合样本点的线。

样本:

一般我们说线性回归的表达式:

Y = wTX + b

最小二乘推导:

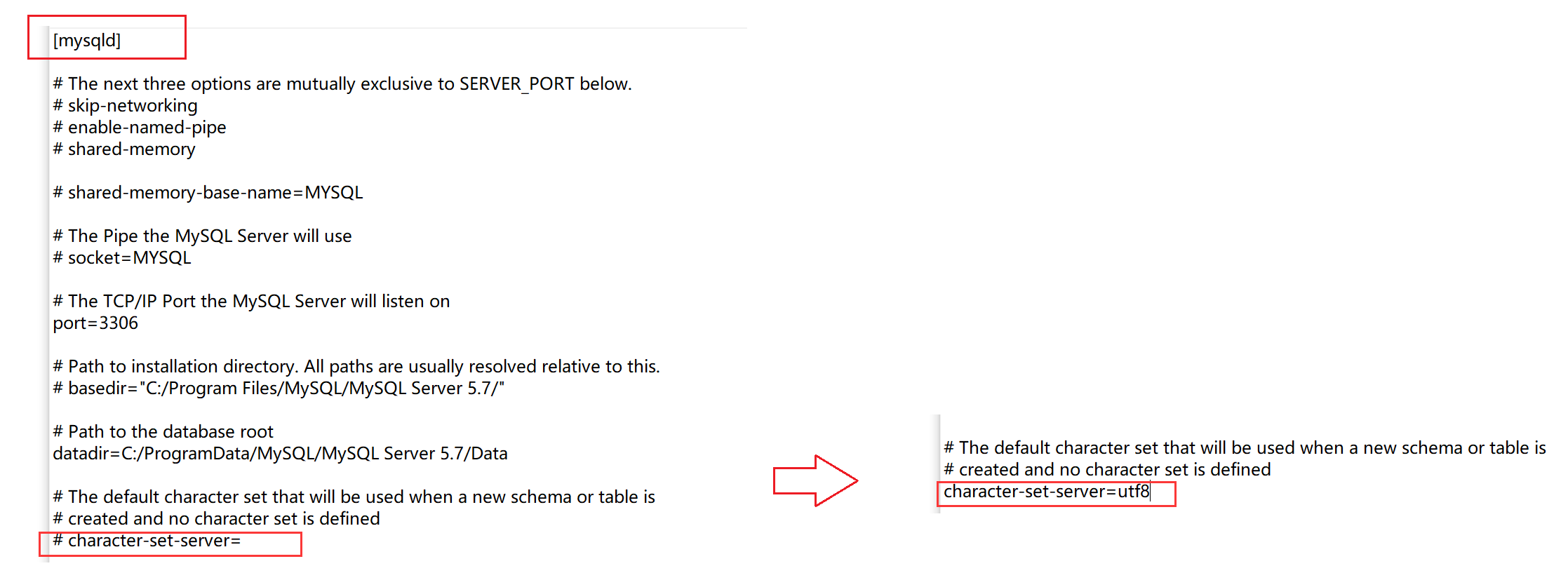

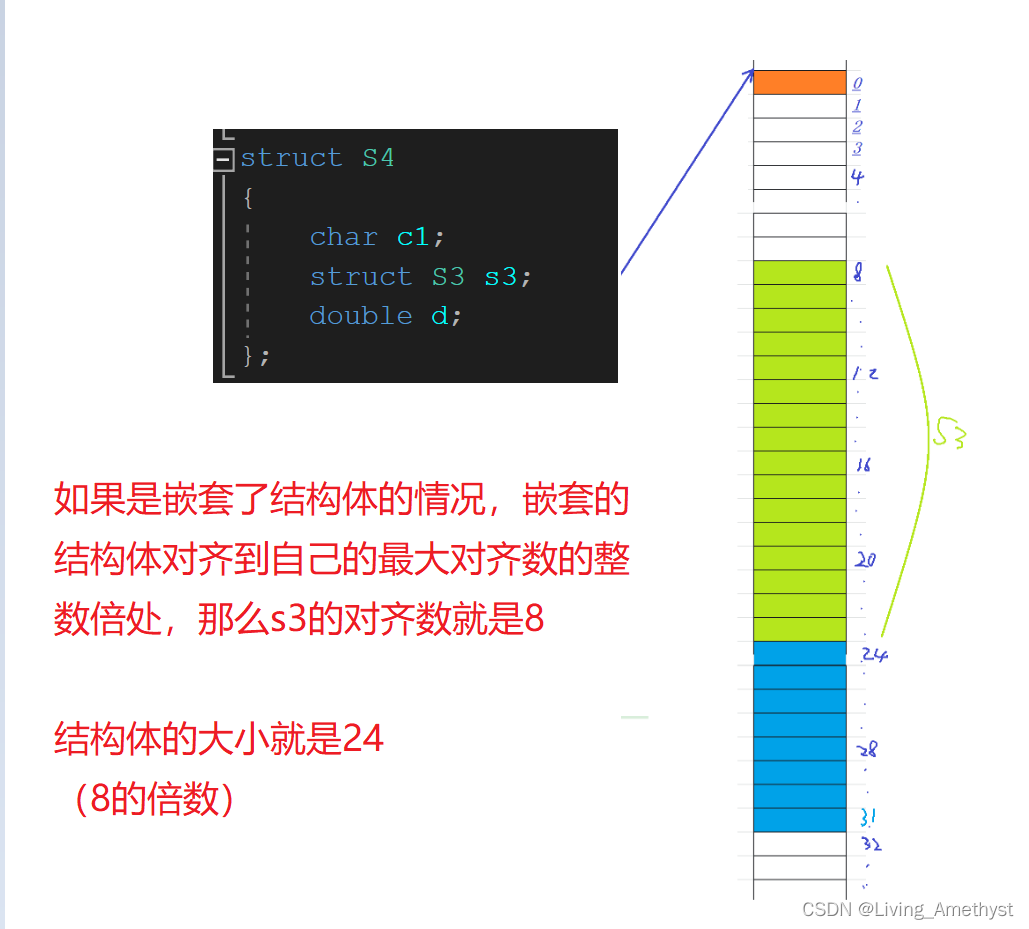

当然我们直接看结果发现有求逆的过程,但是在现实生活中我们会发现也有矩阵不可逆的情况,因此我们要引入正则化,从矩阵的角度来说,解决矩阵不可逆,从模型来说,为了防止过拟合,例如一个样本点,p维的一个数据,那么那是不是有无数条拟合的直线,因此很容易就陷入了过拟合。

解决过拟合的方法:1.增加数据,2.降维(特征选择,特征提取)3.正则化

正则化其实就是对代价函数加上一个约束:

L(w)【loss】 + λP(w)【惩罚项】

L1 :lasso :p(w)=||w||1 L1范数

L2 :ridge(岭回归) :p(w)= ||w||2 L2范数

L2正则化为什么可以防止过拟合并且矩阵求逆?

我们观察岭回归的出来的解析解,是不是多了一个λI(对角矩阵),半正定矩阵+对角矩阵就一定是一个可逆的矩阵。

中心极限定理:

给定一个任意的分布,从中抽取m次,每次抽取n个样本,然后把这些m组样本求平均值,这些平均值是接近正态分布的。

回归问题的评估方法:

MSE均方误差方法:mean_squared_error

计算每一个样本得预测值和真实值之间得差得平方,然后求和再平均

方法:mean_absolute_error

方法:r2_score()

1.![]() ,

, ![]() ,

, ![]() 可以准确的计算出预测结果和真实的结果的误差大小,但却无法衡量模型的好坏程度。但是这些指标可以指导我们的模型改进工作,如调参,特征选择等。

可以准确的计算出预测结果和真实的结果的误差大小,但却无法衡量模型的好坏程度。但是这些指标可以指导我们的模型改进工作,如调参,特征选择等。

2.![]() 的结果可以很清楚的说明模型的好坏,该值越接近于1,表明模型的效果越好。该值越接近于0,表明模型的效果越差。

的结果可以很清楚的说明模型的好坏,该值越接近于1,表明模型的效果越好。该值越接近于0,表明模型的效果越差。

多项式回归:

多项式回归是线性回归的一种扩展,它可以使我们对非线性关系进行建模。线性回归使用直线来拟合数据,如一次函数y = k x + b等。而多项式回归则使用曲线来拟合数据,如二次函数y=ax^2+bx+c,三次函数y=ax^3+bx^2+cx+d。

多项式回归得作用:

有时直线难以拟合全部的数据,需要曲线来适应数据,如二次模型、三次模型等等。

次数的选择:

多项式函数有多种,一般来说,需要先观察数据的形状,再去决定选用什么形式的多项式函数来处理问题。比如,从数据的散点图观察,如果有一个“弯”,就可以考虑用二次多项式;有两个“弯”,可以考虑用三次多项式;有三个“弯”,则考虑用四次多项式,以此类推。

虽然真实的回归函数不一定是某个次数的多项式,但只要拟合的好,用适当的多项式来近似模拟真实的回归函数是可行的。

Pipline包,PolynomialFeatures包,StandardScaler包归一化:

作用:

- 归一化后加快了梯度下降求最优解的速度;

- 归一化有可能提高精度;

标准差标准化(standardScale)使得经过处理的数据符合标准正态分布,即均值为0,标准差为1,其转化函数为:

其中μ为所有样本数据的均值,σ为所有样本数据的标准差。

边栏推荐

猜你喜欢

随机推荐

字符串函数和内存函数

xmms的歌词显示及音量控制OK

Redis 缓存主动更新策略

[项目配置] 配置Qt函数库和ui界面库的封装并调用的项目

antd的Table列选择、列拓展

【 size_t is unsigned integer (1 > 10) - > 1.

用Word写代码

极域Killer 1.0代码

Attentional Feature Fusion

Demand side power load forecasting (Matlab code implementation)

10000以内素数表(代码块)

上传张最近做的E2用的xmms的界面的截图

Win7 远程桌面限制IP

从源码分析UUID类的常用方法

实现下拉加载更多

编程技术提升

多线程案例——阻塞式队列

[Machine Learning] Detailed explanation of web crawler combat

使用.NET简单实现一个Redis的高性能克隆版(四、五)

【八大排序④】归并排序、不基于比较的排序(计数排序、基数排序、桶排序)

![[Halcon&定位] 解决Roi区域外的模板匹配成功](/img/ad/549c7e6336ef62469a7c71e6bfcb42.png)