当前位置:网站首页>关于训练过程中损失函数出现断崖式增长的问题

关于训练过程中损失函数出现断崖式增长的问题

2022-04-23 14:05:00 【想到的名字都被人用了】

训练过程中损失函数出现断崖式增长原因

(一). 由于损失函数是非凸函数,学习率设置的过大导致跳出了最优解的区间,我们可以选择动态改变学习率的优化算法,比如adam

(二) 当训练过程中出现梯度爆炸也会导致损失出现断崖式增长

梯度爆炸或消失出现的原因

根本原因:当我们采取不当的训练方法啊导致前面的层出现梯度消失后,模型会大幅度调整后几层的参数,导致梯度过大,最后出现梯度爆炸

注意:梯度消失出现在前几层,梯度爆炸出现在后几层

解决措施

注意:梯度截断法也是防止梯度爆炸的重要手段

1. 选择合适的分布去初始化参数,w过大容易导致梯度爆炸或消失,比如使用tanh激活函数时候,w过大导致z过大,再求导时导数却趋于0

2. 采用BN方式,尽可能的使得输入输出保持同分布,减缓梯度消失得出现也能避免梯度爆炸或消失产生(非常好用)

3. 根据链式法则,当我们w的值较小时,a的导数也会较小,a的导数越小前一层w的梯度也就越小,所以我们可以采用L1、L2正则化的方式来减缓梯度爆炸

4. 选择合适的激活函数,relu就是我们最常用的激活函数

5. 效果差不多的情况下,神经网络越简单越不容易出现梯度爆炸和梯度消失

版权声明

本文为[想到的名字都被人用了]所创,转载请带上原文链接,感谢

https://blog.csdn.net/qq_42861526/article/details/124021989

边栏推荐

猜你喜欢

Mock测试

As a junior college student, I studied hard in closed doors for 56 days, won Ali offer with tears, five rounds of interviews and six hours of soul torture

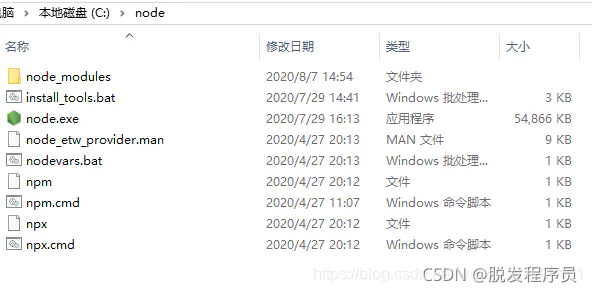

Nodejs安装及环境配置

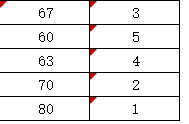

帆软报表设置单元格填报以及根据值的大小进行排名方法

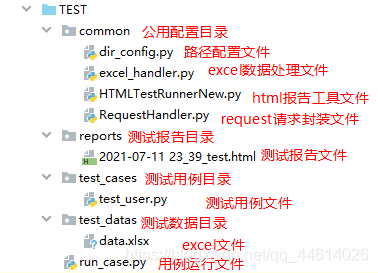

DDT+Excel进行接口测试

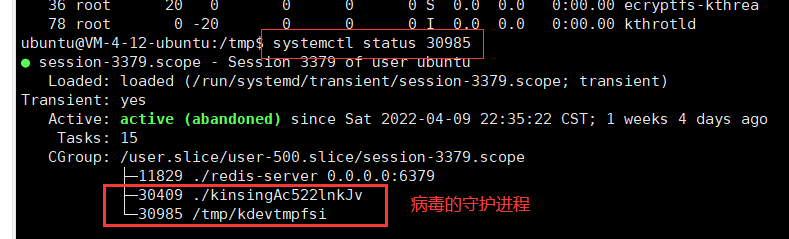

There is a mining virus in the server

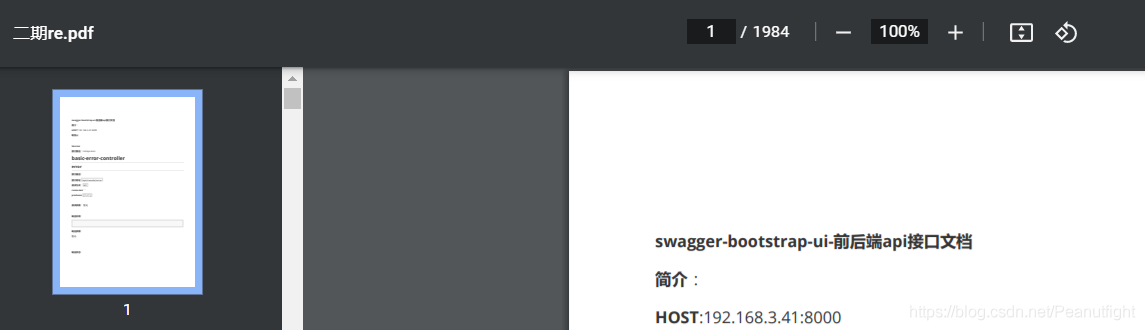

使用itextpdf实现截取pdf文档第几页到第几页,进行分片

Call wechat customer service applet

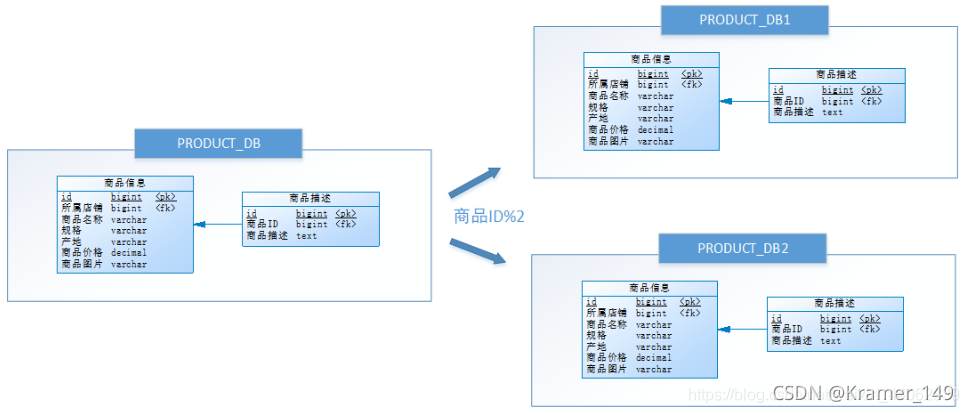

分库分表 & ShardingSphere

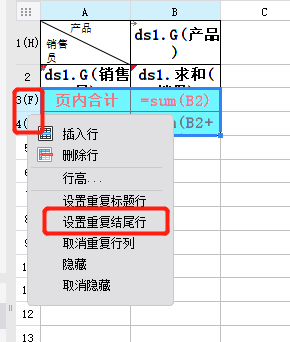

帆软实现分页时第一行和最后两行冻结方式

随机推荐

RobotFramework 之 文件上传和下载

对List集合进行分页

程序编译调试学习记录

RobotFramework 之 公共变量

Program compilation and debugging learning record

poi操作word模板替换数据并且导出word

帆软调用动态传参的方法,在标题中设置参数

Three point positioning based on ibeacons (wechat applet)

Promtail + Loki + Grafana 日志监控系统搭建

微信小程序通过低功耗蓝牙设备进行定位及测距(二)

PyMySQL

There is a mining virus in the server

全局变量能否放在头文件中定义

Un modèle universel pour la construction d'un modèle d'apprentissage scikit

Subscription number development of wechat applet (message push)

mysql通过binlog文件恢复数据

分库分表 & ShardingSphere

关于pthread多线程一些好文章

Cdh6 based on CM management 3.2 cluster integration atlas 2 one

Wechat applet input hidden and inoperable settings