1、相关术语名词解释

1、RDD (Resilient Distributed DataSet)

o 弹性分布式数据集,是对数据集在 spark 存储和计算过程中的一种抽

象。

o 是一组只读、可分区的的分布式数据集合。

o 一个 RDD 包含多个分区 Partition(类似于 MapReduce 中的

InputSplit),分区是依照一定的规则的,将具有相同规则的属性的数

据记录放在一起。

o 横向上可切分并行计算,以分区 Partition 为切分后的最小存储和计

算单元。

o 纵向上可进行内外存切换使用,即当数据在内存不足时,可以用外存

磁盘来补充。

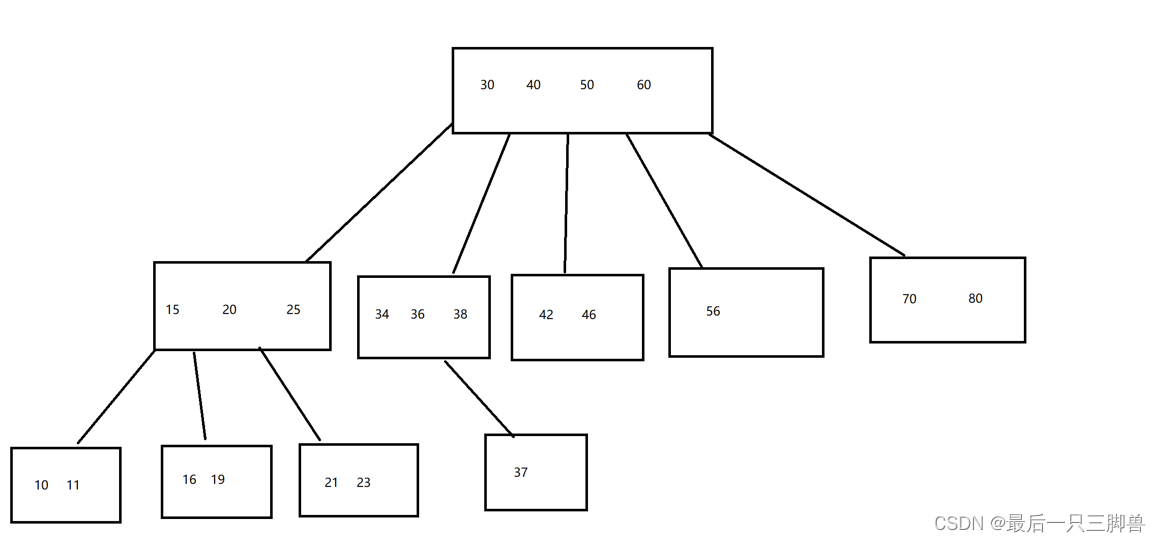

2、Partition(分区)o Partition 类似 hadoop 的 Split,计算是以 partition 为单位进行

的,提供了一种划分数据的方式。

o partition 的划分依据有很多,常见的有 Hash 分区、范围分区等,也

可以自己定义的,像 HDFS 文件,划分的方式就和 MapReduce 一样,以

文件的 block 来划分不同的 partition。

o 一个 Partition 交给一个 Task 去计算处理

3、算子

o 英文简称:Operator,简称 op

o 广义上讲,对任何函数进行某一项操作都可以认为是一个算子

o 通俗上讲,算子即为映射、关系、变换。

o MapReduce 算子,主要分为两个,即为 Map 和 Reduce 两个主要操作的

算子,导致灵活可用性比较差。

o Spark 算子,分为两大类,即为 Transformation 和 Action 类,合计有

80 多个。

4、Transformation 类算子

o 操作是延迟计算的,也就是说从一个 RDD 转换生成另一个 RDD 的转换

操作不是马上执行,需要等到有 Action 操作的时候才会真正触发运

算。

o 细分类

Value 数据类型的 Transformation 算子

Key-Value 数据类型的 Transfromation 算子

5、Action 类算子

o 会触发 Spark 提交作业(Job),并将数据输出 Spark 系统。

6、窄依赖

o 如果一个父 RDD 的每个分区只被子 RDD 的一个分区使用 ----> 一对一

关系

7、宽依赖

o 如果一个父 RDD 的每个分区要被子 RDD 的多个分区使用 ----> 一对多

关系

8、Application

o Spark Application 的概念和 MapReduce 中的 job 或者 yarn 中的

application 类似,指的是用户编写的 Spark 应用程序,包含了一个

Driver 功能的代码和分布在集群中多个节点上运行的 Executor 代码

o 一般是指整个 Spark 项目从开发、测试、布署、运行的全部。

9、Driver

o 运行 main 函数并且创建 SparkContext 的程序。o 称为驱动程序,Driver Program 类似于 hadoop 的 wordcount 程序中的

driver 类的 main 函数。

10、Cluster Manager

o 集群的资源管理器,在集群上获取资源的服务。如 Yarn、Mesos、

Spark Standalone 等。

o 以 Yarn 为例,驱动程序会向 Yarn 申请计算我这个任务需要多少的内

存,多少 CPU 等,后由 Cluster Manager 会通过调度告诉驱动程序可

以使用,然后驱动程序将任务分配到既定的 Worker Node 上面执行。

11、WorkerNode

o 集群中任何一个可以运行 spark 应用代码的节点。

o Worker Node 就是物理机器节点,可以在上面启动 Executor 进程。

12、Executor

o Application 运行在 Worker 节点上的一个进程,该进程负责运行

Task,并且负责将数据存在内存或者磁盘上,每个 Application 都有

各自独立专享的一批 Executor。

o Executor 即为 spark 概念的资源容器,类比于 yarn 的 container 容

器,真正承载 Task 的运行与管理,以多线程的方式运行 Task,更加高

效快速。

13、Task

o 与 Hadoop 中的 Map Task 或者 Reduce Task 是类同的。

o 分配到 executor 上的基本工作单元,执行实际的计算任务。

o Task 分为两类,即为 ShuffleMapTask 和 ResultTask。

ShuffleMapTask:即为 Map 任务和发生 Shuffle 的任务的操作,由

Transformation 操作组成,其输出结果是为下个阶段任务

(ResultTask)进行做准备,不是最终要输出的结果。

ResultTask:即为 Action 操作触发的 Job 作业的最后一个阶段任

务,其输出结果即为 Application 最终的输出或存储结果。

14、Job(作业)

o Spark RDD 里的每个 action 的计算会生成一个 job。

o 用户提交的 Job 会提交给 DAGScheduler(Job 调度器),Job 会被分解

成 Stage 去执行,每个 Stage 由一组相同计算规则的 Task 组成,该组

Task 也称为 TaskSet,实际交由 TaskScheduler 去调度 Task 的机器执

行节点,最终完成作业的执行。

15、Stage(阶段)

o Stage 是 Job 的组成部分,每个 Job 可以包含 1 个或者多个 Stage。

o Job 切分成 Stage 是以 Shuffle 作为分隔依据,Shuffle 前是一个

Stage,Shuffle 后是一个 Stage。即为按 RDD 宽窄依赖来划分

Stage。o 每个 Job 会被拆分很多组 Task,每组任务被称为 Stage,也可称

TaskSet,一个作业可以被分为一个或多个阶段

2 用户交互方式

1、spark-shell:spark 命令行方式来操作 spark 作业。

o 多用于简单的学习、测试、简易作业操作。

2、spark-submit:通过程序脚本,提交相关的代码、依赖等来操作 spark 作业。o 最多见的提交任务的交互方式,简单易用、参数齐全。

3、spark-sql:通过 sql 的方式操作 spark 作业。

o sql 相关的学习、测试、生产环境研发均可以使用该直接操作交互方

式。

4、spark-class:最低层的调用方式,其它调用方式多是最终转化到该方式中去提交。

o 直接使用较少

5、sparkR,sparkPython:通过其它非 java、非 scala 语言直接操作 spark 作业的方式。

o R、python 语言使用者的交互方式