当前位置:网站首页>论文理解:“PIAT: Physics Informed Adversarial Training for Solving Partial Differential Equations“

论文理解:“PIAT: Physics Informed Adversarial Training for Solving Partial Differential Equations“

2022-08-10 02:16:00 【RrS_G】

译:解偏微分方程的物理对抗训练

-- arxiv -- 2022

目录

4.1、Kuramoto–Sivashinsky (KS) equation

一、引言

为提高PINN的性能,作者首先引入权值衰减和高斯平滑。然后又提出了一种更广义的基于对抗性训练的非线性问题求解方法,称为PIAT。

利用该方法训练全连接神经网络解决各种维度的物理问题,使神经网络具有更好的鲁棒性,对测试数据具有泛化作用,而PINN可能不够有效。本文将该模型应用于三个PDE系统,Kuramoto-Sivashinsky方程、Sawada-Kotera方程和高维Allen-Cauhn方程。在所有情况下,训练数据的总数都相对较少,训练和测试数据是使用拉丁超立方体抽样(LHS)策略生成的。

二、高斯平滑和权值衰减

为了提高网络的泛化性,作者建议隐式地使解对小随机扰动具有鲁棒性,因此作者在训练中加入随机有界噪声作为增强,并应用权值衰减,以达到一个稳定的模型。

对带有高斯噪声的输入样本进行扰动,可以简单地这样做:

此外,利用权重衰减作为另一种有效的方法来防止过拟合和改善泛化。权值衰减是一种正则化项,它在损失函数中加入惩罚项以保持模型权值较小,如下所示:

三、PLAT

一般的优化目标是这样的:

使用上述目标的正常训练在许多任务中表现良好,但它导致的模型在对抗性例子(有扰动)面前很脆弱。使用权重衰减和高斯平滑的原因就是为了缓解这个问题。然而,仅依靠这些达不到应有的效果。

另一个解决这个问题的方法是对抗性训练,其包括两部分。在第一部分中,优化了一个小扰动δ,并将其加入到训练样本x中,使网络损失最大化。接下来,基于扰动样本(x, t) + δ上定义的损失函数的一次随机梯度更新来优化神经网络权值:

四、数值实验

4.1、Kuramoto–Sivashinsky (KS) equation

考虑四阶非线性Kuramoto-Sivashinsky(KS)方程的周期初值问题如下:

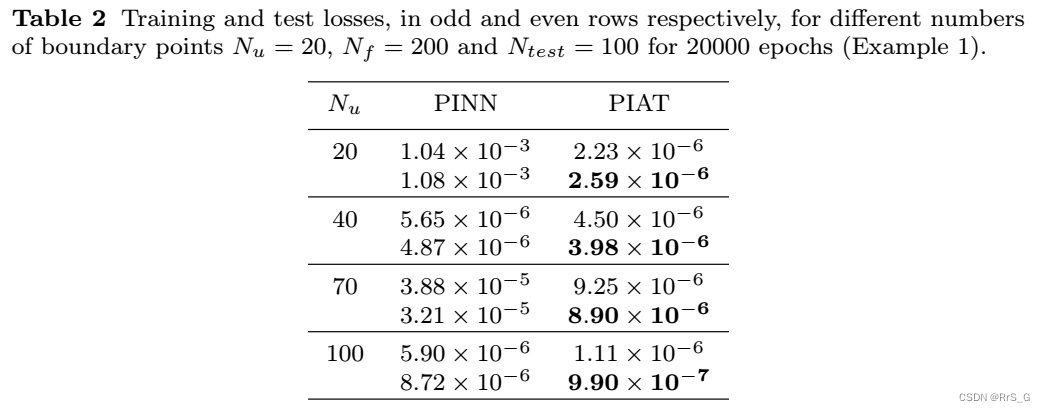

利用所提出的方法,用一个具有5个隐层、每隐层100个神经元和200个边界点的深度神经网络近似求解。表2给出了不同数量的边界点和配置点的解的训练和测试误差。

图3显示了训练和验证损失:

4.2、高维Allen-Cauhn方程

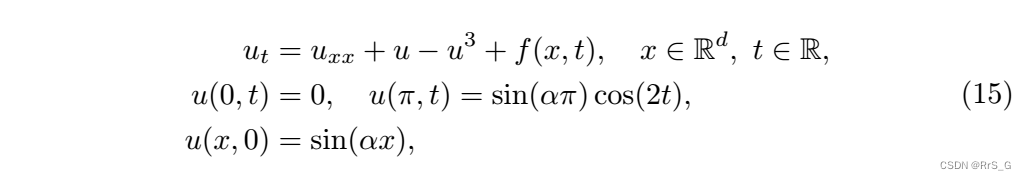

方程如下:

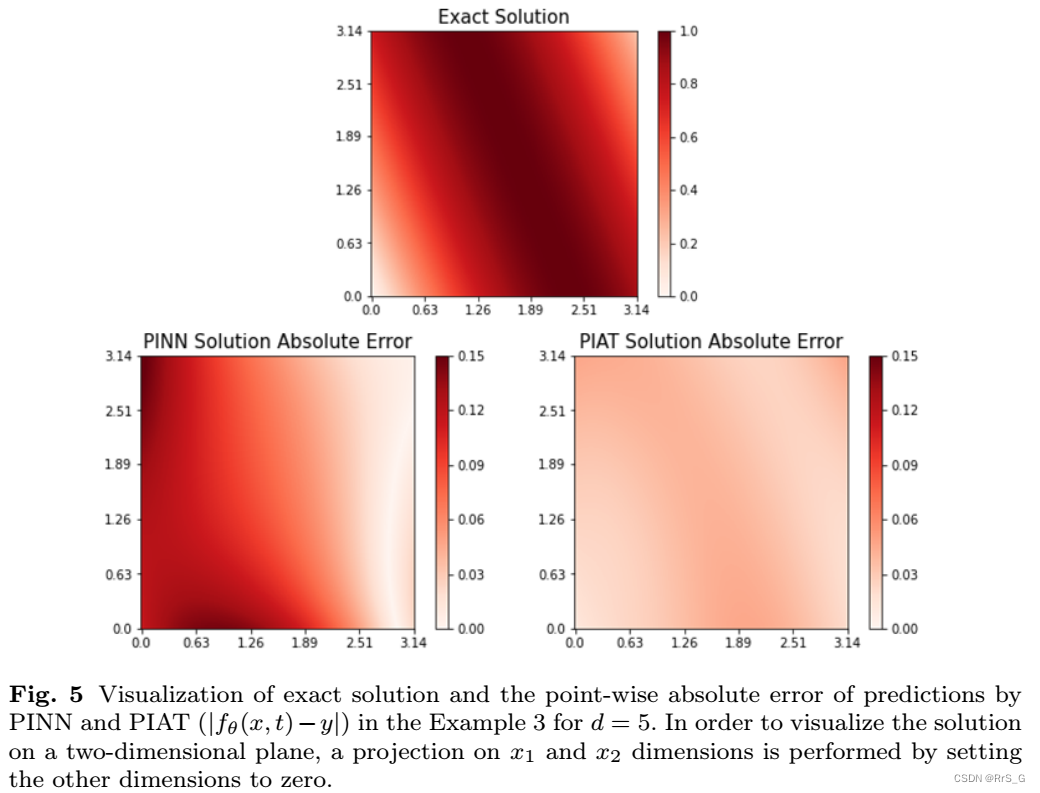

表12中的数值结果显示了PIAT在不同维度上与标准的PINN训练相比的效率

解的误差结果:

最后附上代码: https://github.com/rohban-lab/PIAT

边栏推荐

猜你喜欢

微生物是如何影响身体健康的

storage of data in memory

Difference Between Data Mining and Data Warehousing

FusionCompute产品介绍

【二叉树-困难】124. 二叉树中的最大路径和

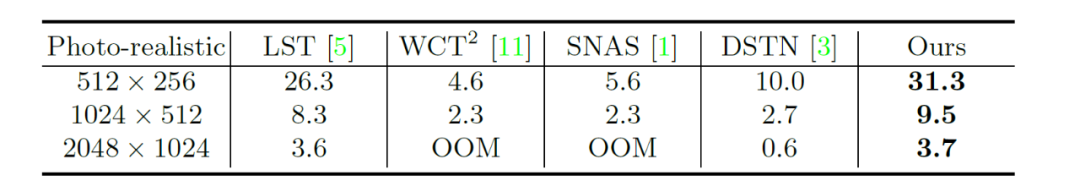

ECCV 2022 Oral | CCPL: 一种通用的关联性保留损失函数实现通用风格迁移

![[Kali Security Penetration Testing Practice Course] Chapter 7 Privilege Escalation](/img/fe/c1aebd4a9f8be29820af35c79d6332.png)

[Kali Security Penetration Testing Practice Course] Chapter 7 Privilege Escalation

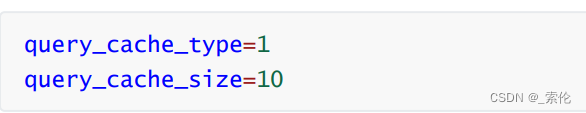

MySQL:你做过哪些MySQL的优化?

Fusion Compute网络虚拟化

推荐几款好用的MySQL开源客户端,建议收藏

随机推荐

数据库治理利器:动态读写分离

实例044:矩阵相加

State compression small experience

[Red Team] ATT&CK - Self-starting - Self-starting mechanism using LSA authentication package

数据挖掘和数据仓库之间的区别

2022.8.9 Exam Travel Summary

[Semantic Segmentation] 2022-HRViT CVPR

Screen 拆分屏幕

ArcGIS Advanced (1) - Install ArcGIS Enterprise and create an sde library

SQLserver adds a judgment

小菜鸟河北联通上岗培训随笔

What makes training multi-modal classification networks hard?

如何编写一份优质的测试用例?

流星加速器木马分析与处置方案

GDB之指令基础参数

HRnet

2022.8.9考试平衡的余数--1000题解

QT modal dialog and non-modal dialog learning

Go语言JSON文件的读写操作

The 25th day of the special assault version of the sword offer